您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇“pytorch中使用LSTM實例分析”文章的知識點大部分人都不太理解,所以小編給大家總結了以下內容,內容詳細,步驟清晰,具有一定的借鑒價值,希望大家閱讀完這篇文章能有所收獲,下面我們一起來看看這篇“pytorch中使用LSTM實例分析”文章吧。

可以在troch.nn模塊中找到LSTM類

lstm = torch.nn.LSTM(*paramsters)

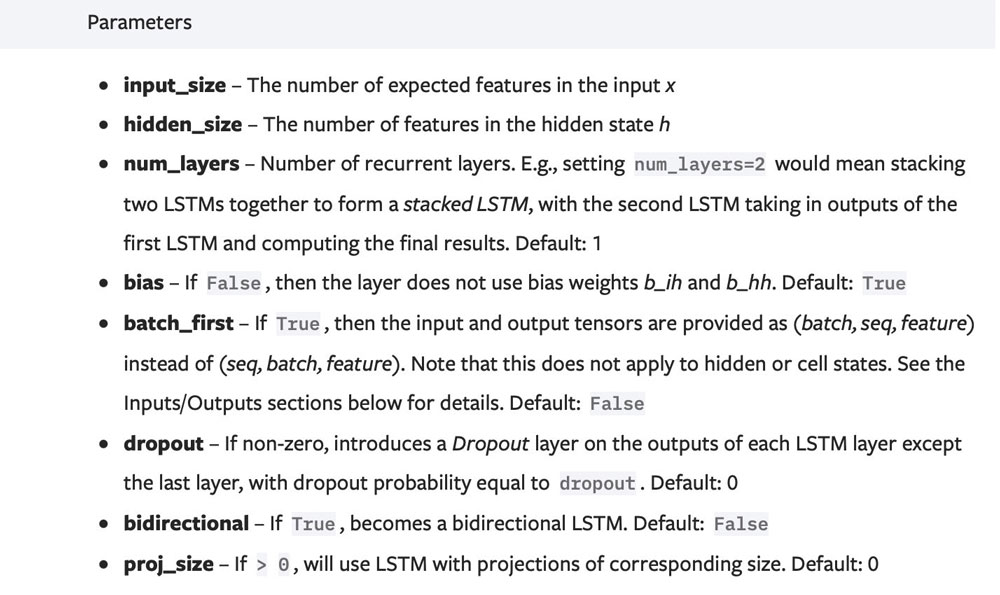

首先對nn.LSTM類進行實例化,需要傳入的參數如下圖所示:

一般我們關注這4個:

input_size表示輸入的每個token的維度,也可以理解為一個word的embedding的維度。

hidden_size表示隱藏層也就是記憶單元C的維度,也可以理解為要將一個word的embedding維度轉變成另一個大小的維度。除了C,在LSTM中輸出的H的維度與C的維度是一致的。

num_layers表示有多少層LSTM,加深網絡的深度,這個參數對LSTM的輸出的維度是有影響的(后文會提到)。

bidirectional表示是否需要雙向LSTM,這個參數也會對后面的輸出有影響。

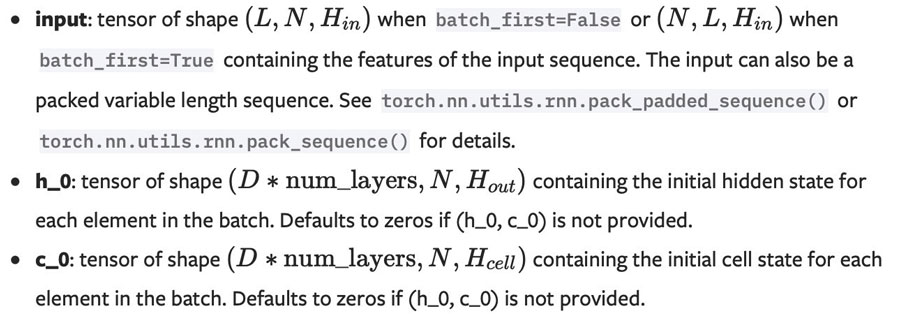

將數據input傳入forward方法進行前向傳播時有3個參數可以輸入,見下圖:

這里要注意的是input參數各個維度的意義,一般來說如果不在實例化時制定batch_first=True,那么input的第一個維度是輸入句子的長度seq_len,第二個維度是批量的大小,第三個維度是輸入句子的embedding維度也就是input_size,這個參數要與__init__方法中的第一個參數對應。

另外記憶細胞中的兩個參數h_0和c_0可以選擇自己初始化傳入也可以不傳,系統默認是都初始化為0。傳入的話注意維度[bidirectional * num_layers, batch_size, hidden_size]。

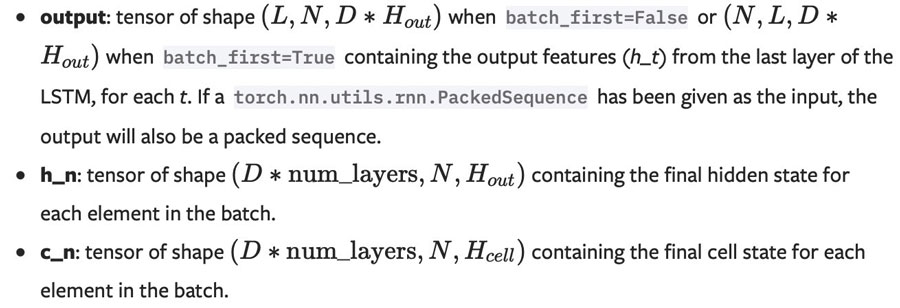

forward方法的輸出如下圖所示:

一般采用如下形式:

out,(h_n, c_n) = lstm(x)

out表示在最后一層上,每一個時間步的輸出,也就是句子有多長,這個out的輸出就有多長;其維度為[seq_len, batch_size, hidden_size * bidirectional]。因為如果的雙向LSTM,最后一層的輸出會把正向的和反向的進行拼接,故需要hidden_size * bidirectional。h_n表示的是每一層(雙向算兩層)在最后一個時間步上的輸出;其維度為[bidirectional * num_layers, batch_size, hidden_size]

假設是雙向的LSTM,且是3層LSTM,雙向每個方向算一層,兩個方向的組合起來叫一層LSTM,故共會有6層(3個正向,3個反向)。所以h_n是每層的輸出,bidirectional * num_layers = 6。c_n表示的是每一層(雙向算兩層)在最后一個時間步上的記憶單元,意義不同,但是其余均與 h_n一樣。

可以在troch.nn模塊中找到LSTMCell類

lstm = torch.nn.LSTMCell(*paramsters)

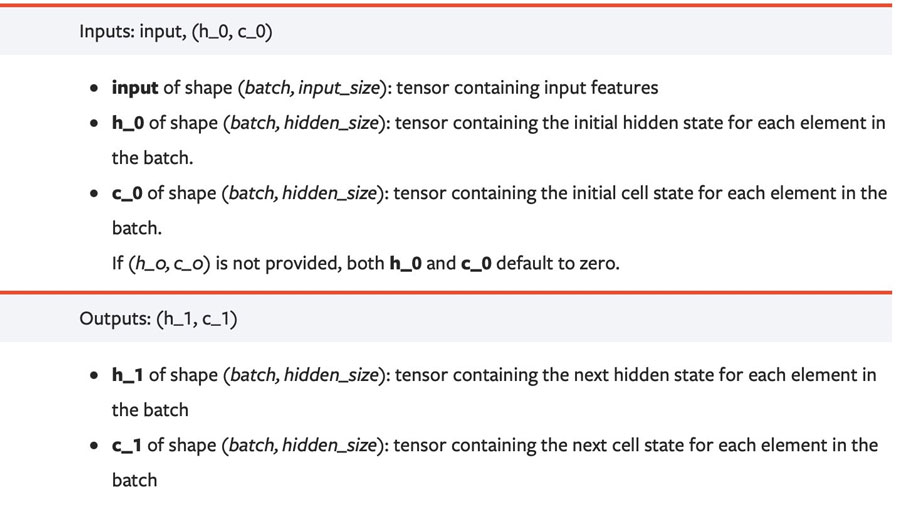

它的__init__方法的參數設置與LSTM類似,但是沒有num_layers參數,因為這就是一個細胞單元,談不上多少層和是否雙向。forward的輸入和輸出與LSTM均有所不同:

其相比LSTM,輸入沒有了時間步的概念,因為只有一個Cell單元;輸出 也沒有out參數,因為就一個Cell,out就是h_1,h_1和c_1也因為只有一個Cell單元,其沒有層數上的意義,故只是一個Cell的輸出的維度[batch_size, hidden_size].

代碼演示如下:

rnn = nn.LSTMCell(10, 20) # (input_size, hidden_size) input = torch.randn(2, 3, 10) # (time_steps, batch, input_size) hx = torch.randn(3, 20) # (batch, hidden_size) cx = torch.randn(3, 20) output = [] # 從輸入的第一個維度也就是seq_len上遍歷,每循環一次,輸入一個單詞 for i in range(input.size()[0]): # 更新細胞記憶單元 hx, cx = rnn(input[i], (hx, cx)) # 將每個word作為輸入的輸出存起來,相當于LSTM中的out output.append(hx) output = torch.stack(output, dim=0)

以上就是關于“pytorch中使用LSTM實例分析”這篇文章的內容,相信大家都有了一定的了解,希望小編分享的內容對大家有幫助,若想了解更多相關的知識內容,請關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。