您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

今天小編給大家分享一下Python爬蟲框架NewSpaper如何使用的相關知識點,內容詳細,邏輯清晰,相信大部分人都還太了解這方面的知識,所以分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后有所收獲,下面我們一起來了解一下吧。

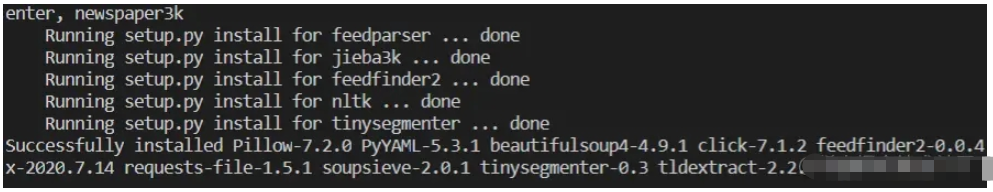

安裝非常簡單

pip install newspaper3k -i pypi.tuna.tsinghua.edu.cn/simple

對于這款框架,使用起來難度是非常低的。簡單對照這一頁文檔即可應用起來

第一種應用方式,直接獲取網頁內容

from newspaper import Article url = "https://36kr.com/p/857678806293124" article = Article(url) # 創建文章對象 article.download() # 加載網頁 article.parse() # 解析網頁 print(article.html) # 打印html文檔

當然還有一些其他屬性,不過該框架都是基于關鍵字識別的,有一些BUG存在,有時識別不準

# print(article.html) # 打印html文檔

print(article.text) # 新聞正文

print("-"*100)

print(article.title) # 新聞標題

print("-"*100)

print(article.authors) # 新聞作者

print("-"*100)

print(article.summary) # 新聞摘要

print(article.keywords) # 新聞關鍵詞

# print(article.top_image) # 本文的top_image的URL

# print(article.images) # 本文中的所有圖像url默認情況下,newspaper緩存所有待提取的文章,如果文章被爬取過之后就會清除掉它。此功能用于防止重復的文章和提高提取速度。可以使用memoize_articles參數選擇是否緩存。

但當我使用下面這個辦法進行提取的時候,神奇的BUG出現了,怎么也得不到我想要的文章了。唉~看來框架完善之路還是要繼續啊

import newspaper

url = "https://news.sina.com.cn/c/2020-08-29/doc-iivhvpwy3651884.shtml"

# article = Article(url) # 創建文章對象

# article.download() # 加載網頁

# article.parse() # 解析網頁

news = newspaper.build(url, language='zh', memoize_articles=False)

article = news.articles[0]

article.download()

article.parse()

print('title=',article.title)在應用的過程中發現確實解析存在很大的問題,不過整體的框架設計思路還是非常棒的。有點高開低走 ,看到github上的評語其實對newspaper是非常有期待的,使用之后,我建議還是使用requests然后加上bs4自己搞搞更加合理。

除了上面簡單介紹到的功能,它還有一些擴展,例如下面這些

requests和newspaper合體解析網頁正文,也就是用requests爬取,newspaper充當解析器

可以調用Google Trends信息

支持多任務爬取

支持NPL自然語言處理

以上就是“Python爬蟲框架NewSpaper如何使用”這篇文章的所有內容,感謝各位的閱讀!相信大家閱讀完這篇文章都有很大的收獲,小編每天都會為大家更新不同的知識,如果還想學習更多的知識,請關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。