您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容主要講解“python爬蟲如何繞過 CloudFlare 5秒盾”,感興趣的朋友不妨來看看。本文介紹的方法操作簡單快捷,實用性強。下面就讓小編來帶大家學習“python爬蟲如何繞過 CloudFlare 5秒盾”吧!

相信下面這個界面大家都不會陌生。【圖1-1】

當我們第一次訪問使用 CloudFlare 加速的網站時,網站就會出現讓我們等待 5 秒種的提示,當我們需要的通過爬蟲爬取這類網站的時候,應該如何爬取呢?

首先我們需要分析在這個等待的時間里瀏覽器做了哪些操作。

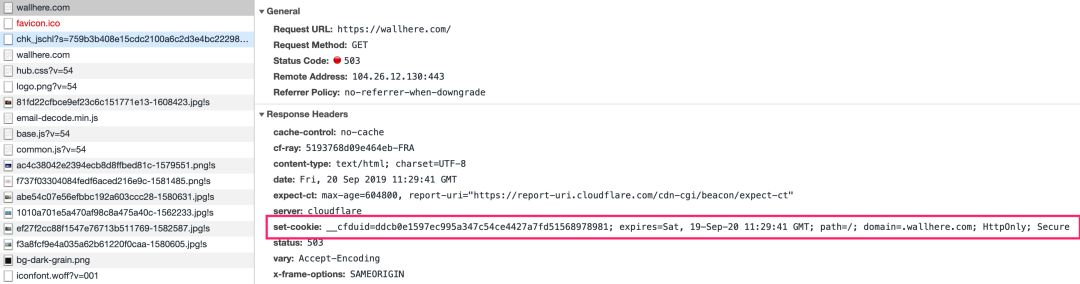

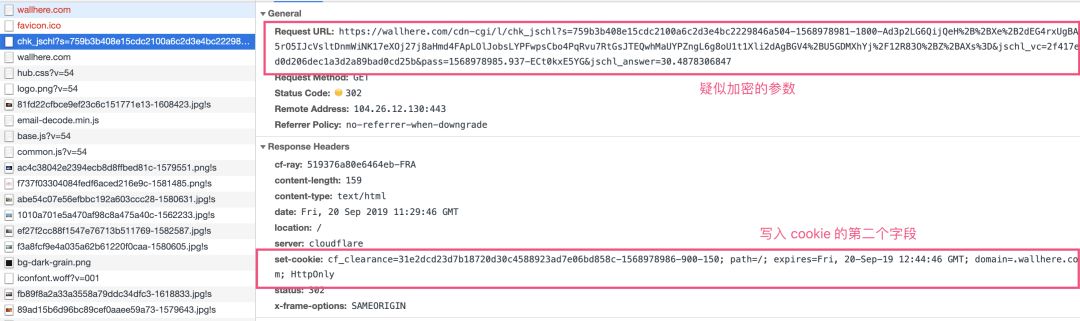

通過抓包,我們可以看到在等待的過程中,瀏覽器做了下面的三次請求【圖1-2】- 【圖1-4】:

【圖1-2】請求 1 寫入 cookie 字段 __cfduid

【圖1-3】請求 2 帶有疑似加密的請求參數請求并寫入 cookie 字段 cf_clearance

【圖1-4】請求 3 帶上前面寫入的cookie 請求網站首頁,返回首頁內容。

這整個過程需要的請求現在已經分析清楚了,接下來就是使用 Python 實現這個請求流程,不過是這樣的話就配不上這個標題了。

先說說這個按照正常流程是怎么實現抓取繞過的:

使用瀏覽器模擬技術請求目標網站,例如:Selenium、 PhantomJS等

破解請求 2 的加密參數使用請求庫模擬整個請求過程

這兩個方法當然是可以抓取的,但是都不符合標題的巧字。

接下來給大家介紹一個專門為了繞過這個 CloudFlare 開發的 Python 庫 cloudflare-scrape

用上它就可以無感爬取使用了 CloudFlare 的網站,使用這個庫非常簡單。

使用pip install cfscrape安裝cloudflare-scrape,同時確認本地是否安裝node.js開發環境,如果沒有,需要安裝配置nodejs開發環境。

處理 get 請求的 CloudFlare

import cfscrape

# 實例化一個create_scraper對象

scraper = cfscrape.create_scraper()

# 請求報錯,可以加上時延

# scraper = cfscrape.create_scraper(delay = 10)

# 獲取網頁源代碼

web_data = scraper.get("https://wallhere.com/").content

print(web_data)

處理 post 請求的 CloudFlare

# import cfscrape

# 實例化一個create_scraper對象

scraper = cfscrape.create_scraper()

# 獲取真實網頁源代碼

web_data = scraper.post("http://example.com").content

print(web_data)使用cloudflare-scrape后整個請求過程如絲般順滑。

到此,相信大家對“python爬蟲如何繞過 CloudFlare 5秒盾”有了更深的了解,不妨來實際操作一番吧!這里是億速云網站,更多相關內容可以進入相關頻道進行查詢,關注我們,繼續學習!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。