您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“如何通過Spark的IDE搭建并測試Spark開發環境”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

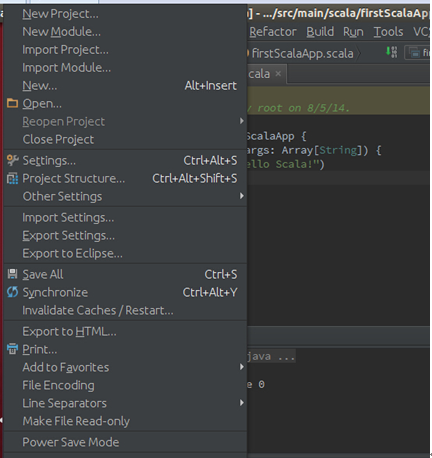

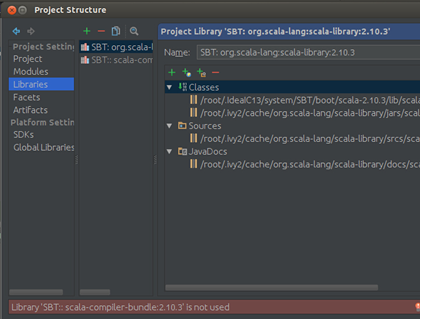

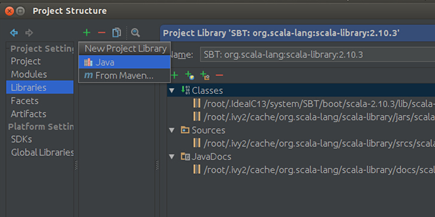

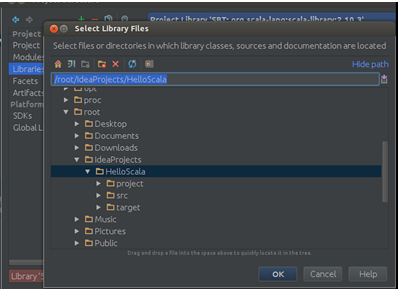

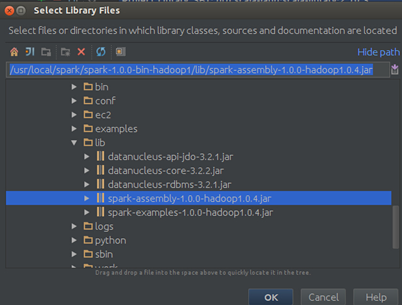

Step 1:導入Spark-hadoop對應的包,次選擇“File”–> “Project Structure” –> “Libraries”,選擇“+”,將spark-hadoop 對應的包導入:

點擊“OK”確認:

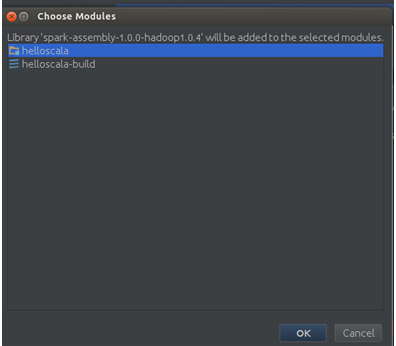

點擊“OK”:

IDEA工作完成后會發現Spark的jar包導入到了我們的工程中:

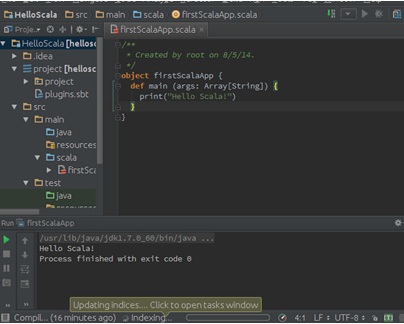

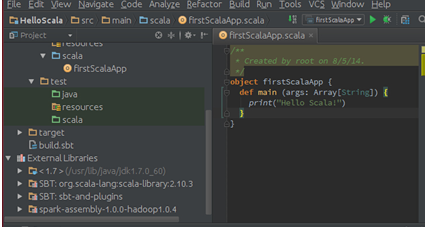

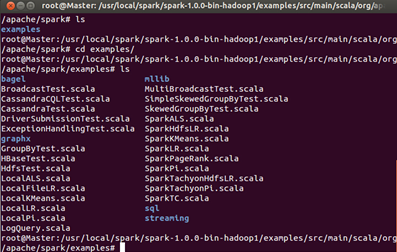

Step 2:開發第一個Spark程序。打開Spark自帶的Examples目錄:

此時發現內部有很多文件,這些都是Spark給我提供的實例。

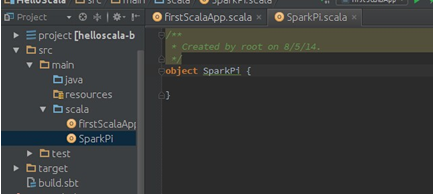

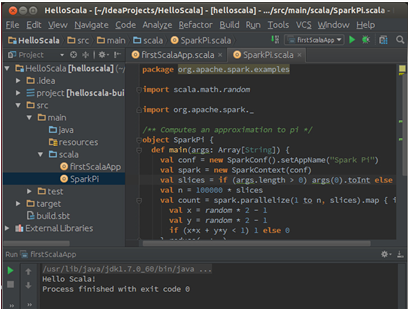

在我們的在我們的第一Scala工程的src下創建一個名稱為SparkPi的Scala的object:

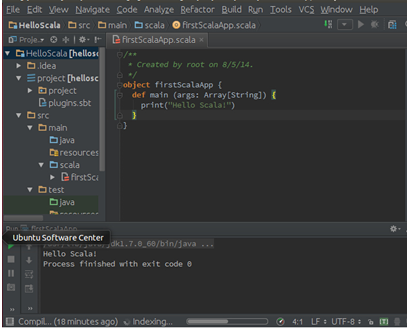

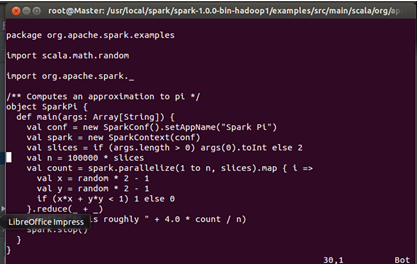

此時打開Spark自帶的Examples下的SparkPi文件:

我們把該文的內容直接拷貝到IDEA中創建的SparkPi中:

“如何通過Spark的IDE搭建并測試Spark開發環境”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。