您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本文將介紹在Mac os上搭建Spark開發環境。

在安裝spark環境之前,需要確保配置相應的java環境,jdk或者jre的版本需要在1.8.0版本以上。

(1)首先下載開發IDE,目前比較流行的IDE是IntelliJ IDEA,可以在官網下載使用,下載地址:https://www.jetbrains.com/idea/。

(2)Spark環境搭建:

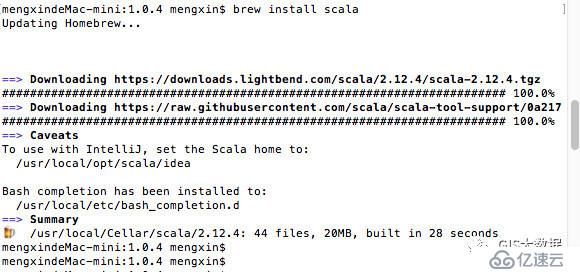

mac上啟動終端,使用brew install scala命令(brew是一個軟件包管理工具,類似于centos下的yum或者ubuntu下的apt-get),進行Scala的安裝下載,如下:

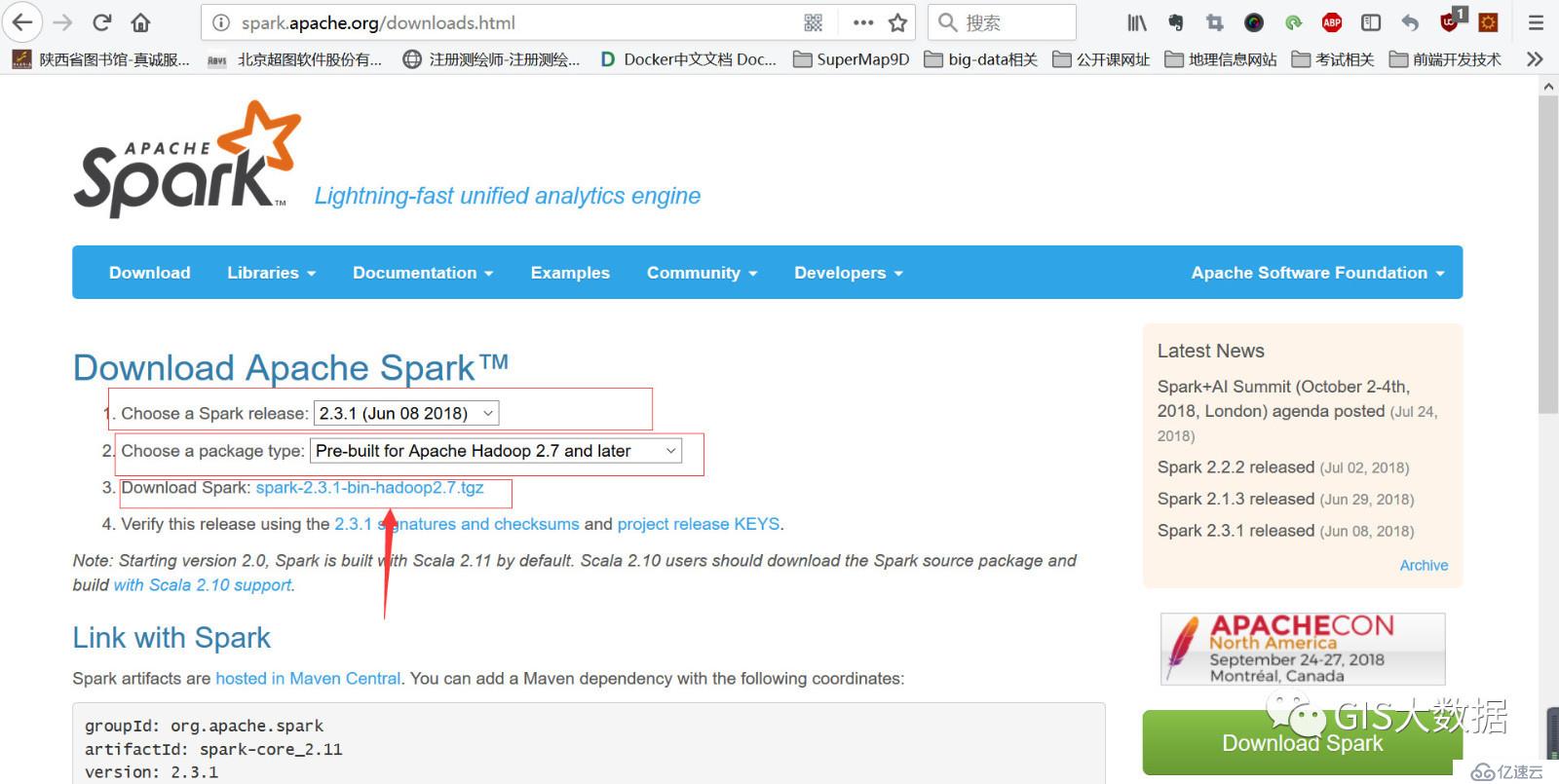

到此scala的環境已經安裝成功,現在我們從spark的官網下載spark相關環境,網址為:http://spark.apache.org/

下載完spark,進入到下載的spark包的文件夾下,執行tar -zxvf spark-2.3.1-bin-hadoop2.7.tar。

安裝完scala以及spark后,進行相關環境變量的配置,執行vim /etc/profile命令,在其后追加如下環境變量:

export SCALA_HOME=/usr/local/Cellar/scala/2.12.4

export PATH=$PATH:$SCALA_HOME/bin

export SPARK_HOME=/Users/mengxin/Downloads/spark-2.3.1-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/bin

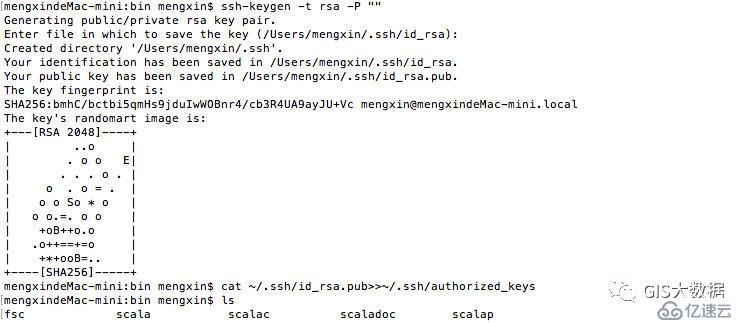

(3)進行本機ssh配置,主目錄執行以下命令:

ssh-keygen -t rsa -P ""

cat ~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys

執行過程如下:

(4)檢測下spark是否能啟動

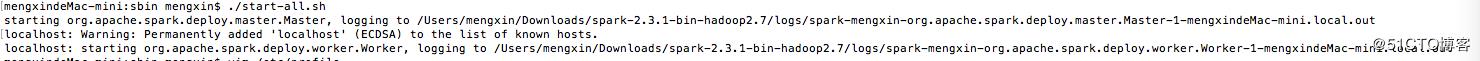

進入spark解壓包下的sbin目錄,執行./start-all.sh,如下圖

可以在local.out文件下查看相關的啟動情況。

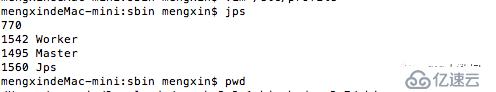

spark啟動后,所啟動的master以及worker進程其實就是就是jvm進程,我們可以用jps命令看一下。

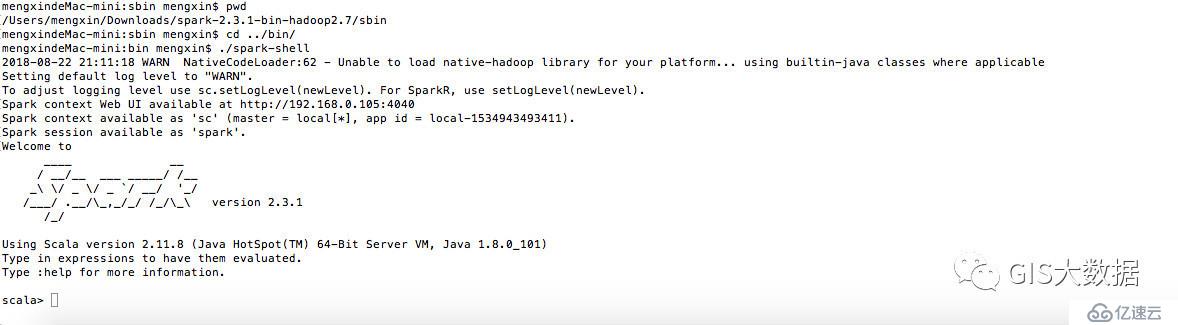

再用spark shell測試下,進入到spark安裝包的bin目錄下,如果出現如下界面,則說明spark安裝環境已經大功告成了。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。