您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹“Flink與數據庫集成方法是什么”,在日常操作中,相信很多人在Flink與數據庫集成方法是什么問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”Flink與數據庫集成方法是什么”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

JDBC-Connector 的重構

FLINK-15782 :Rework JDBC Sinks[1] (重寫 JDBC Sink)

FLINK-17537:Refactor flink-jdbc connector structure[2] (重構 flink-jdbc 連接器的結構)

FLIP-95: New TableSource and TableSink interfaces[3] (新的 TableSource 和 TableSink 接口)

FLIP-122:New Connector Property Keys for New Factory[4](新的連接器參數)

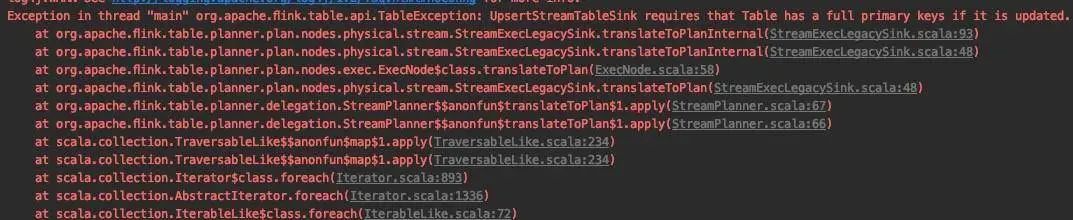

FLIP-87:Primary key Constraints in Table API[5] (Table API 接口中的主鍵約束問題)

JDBC Catalog

// The supported methods by Postgres Catalog.PostgresCatalog.databaseExists(String databaseName)PostgresCatalog.listDatabases()PostgresCatalog.getDatabase(String databaseName)PostgresCatalog.listTables(String databaseName)PostgresCatalog.getTable(ObjectPath tablePath)PostgresCatalog.tableExists(ObjectPath tablePath)

JDBC Dialect

https://ci.apache.org/projects/flink/flink-docs-release-1.11/zh/dev/table/connectors/jdbc.html#data-type-mapping

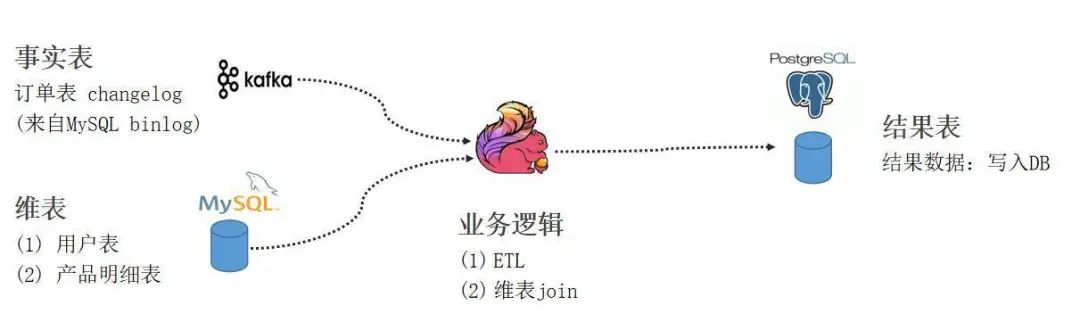

實踐 Demo

https://github.com/leonardBang/flink-sql-etl

問答環節

到此,關于“Flink與數據庫集成方法是什么”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。