您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關TensorFlow的自動求導原理是什么,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

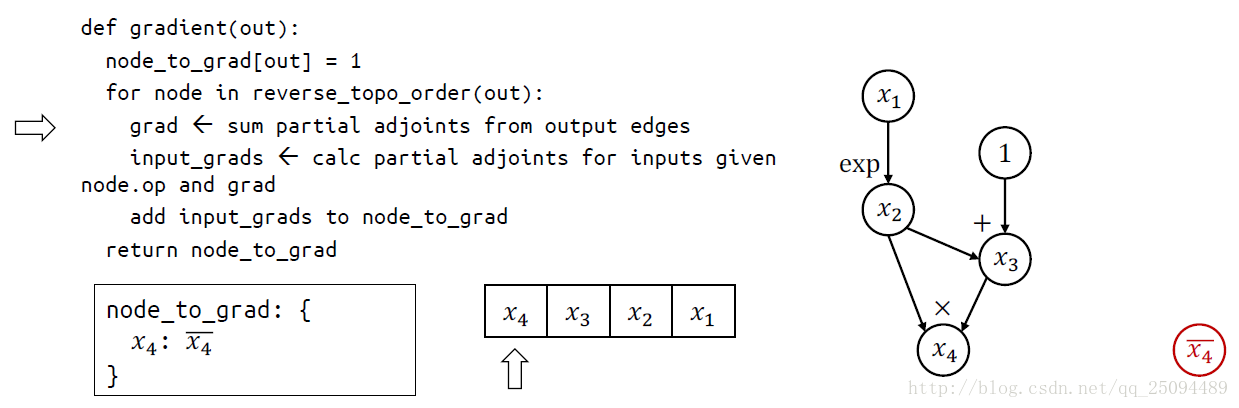

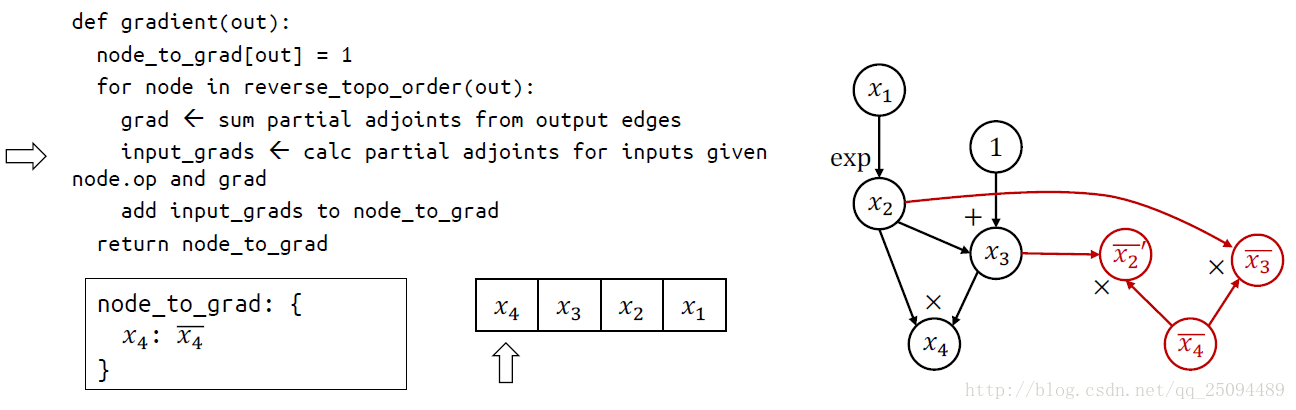

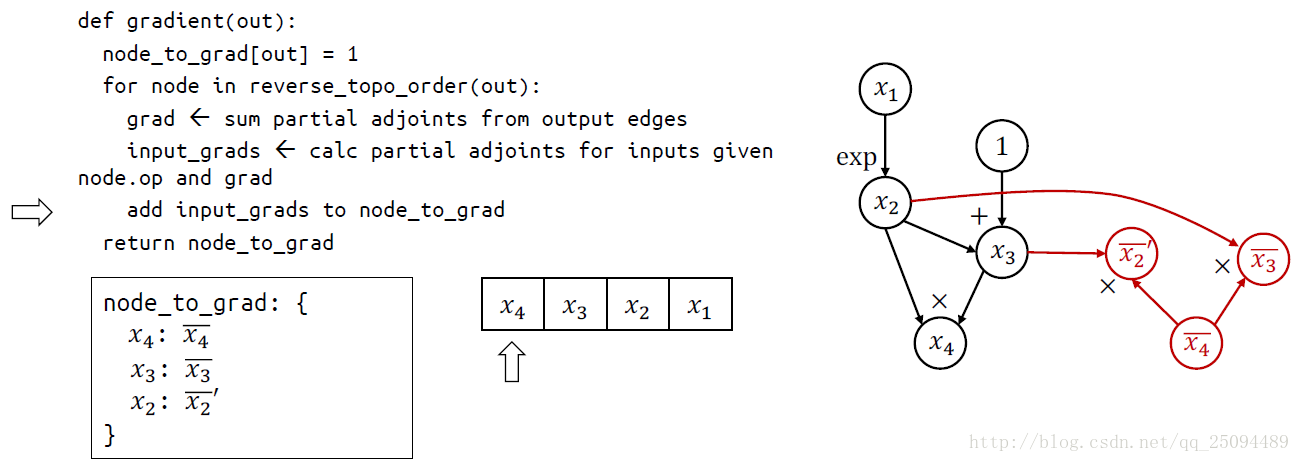

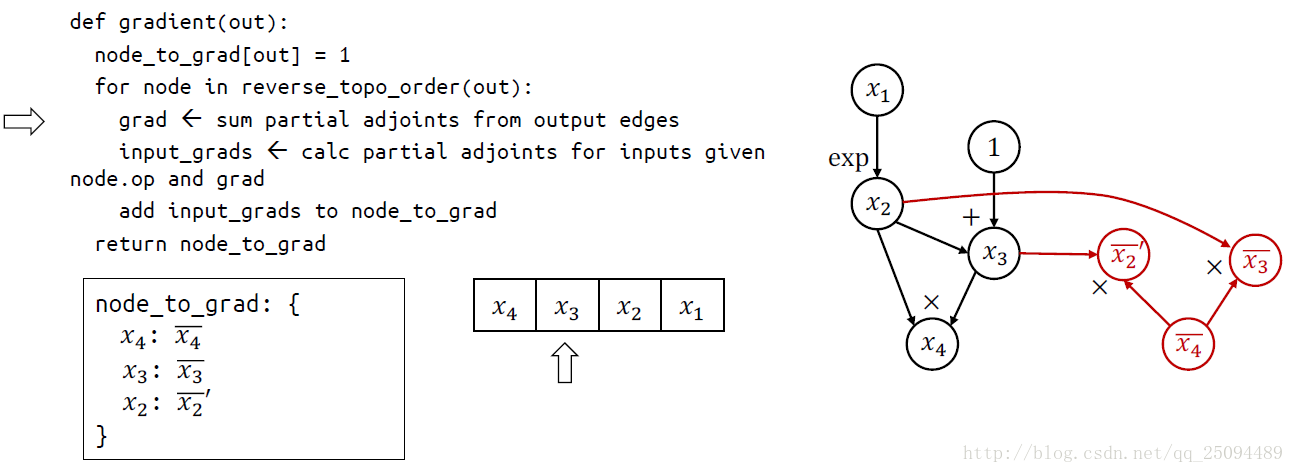

TensorFlow使用的求導方法稱為自動微分(Automatic Differentiation),它既不是符號求導也不是數值求導,而類似于將兩者結合的產物。

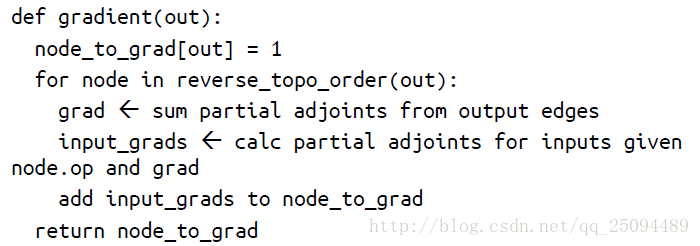

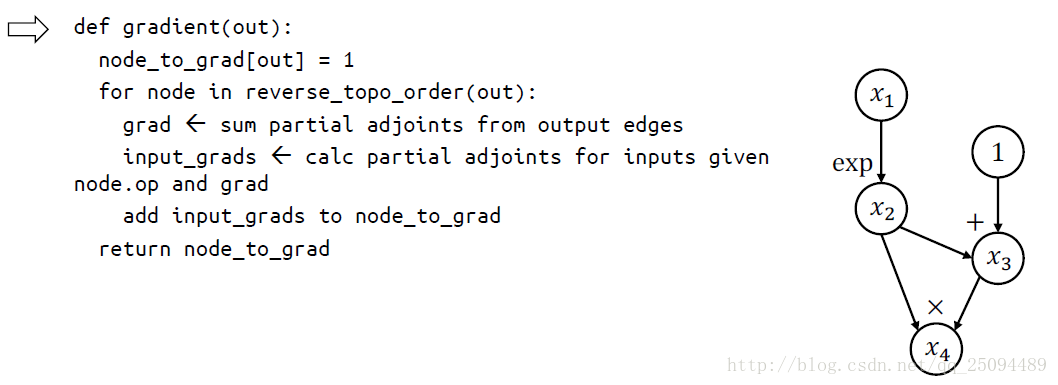

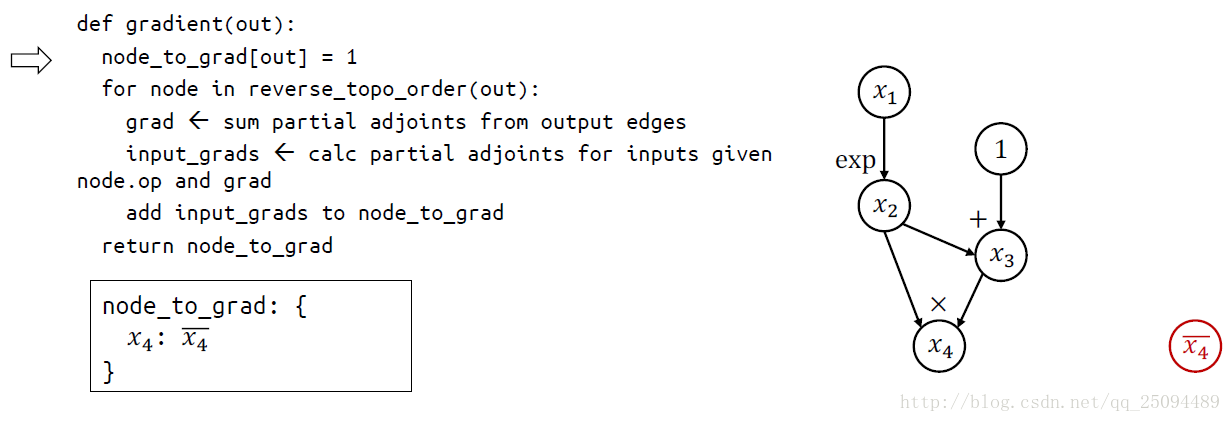

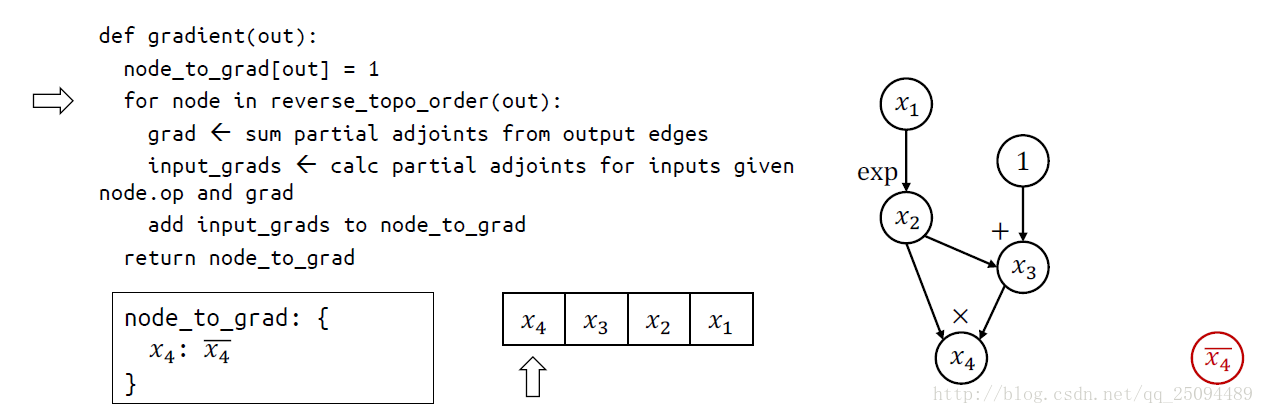

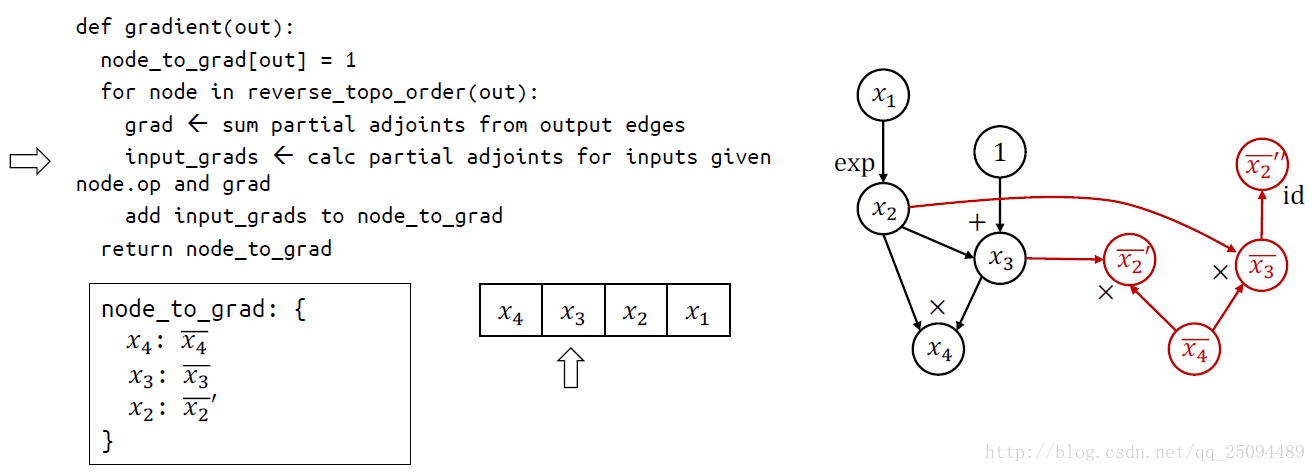

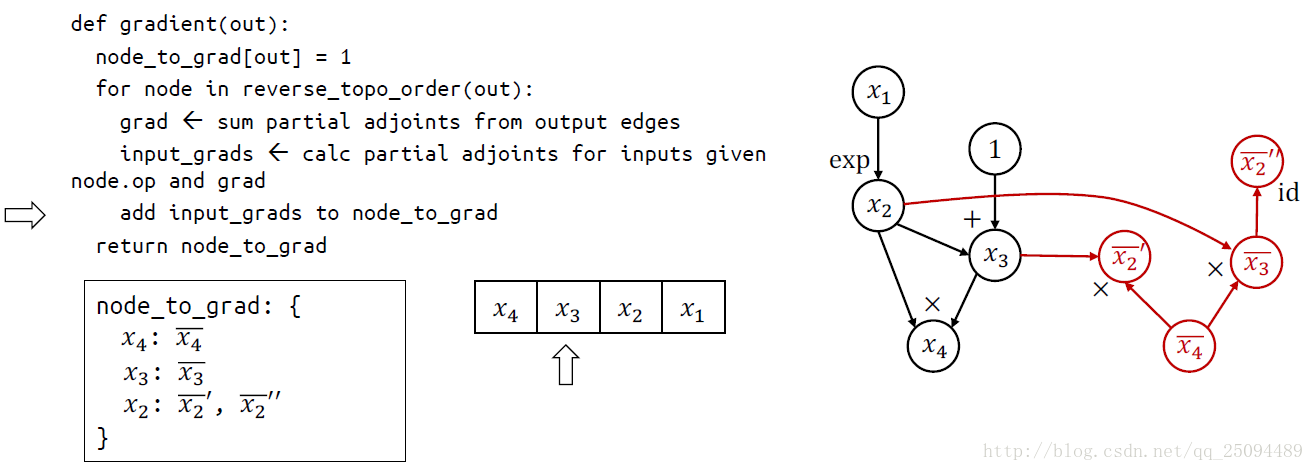

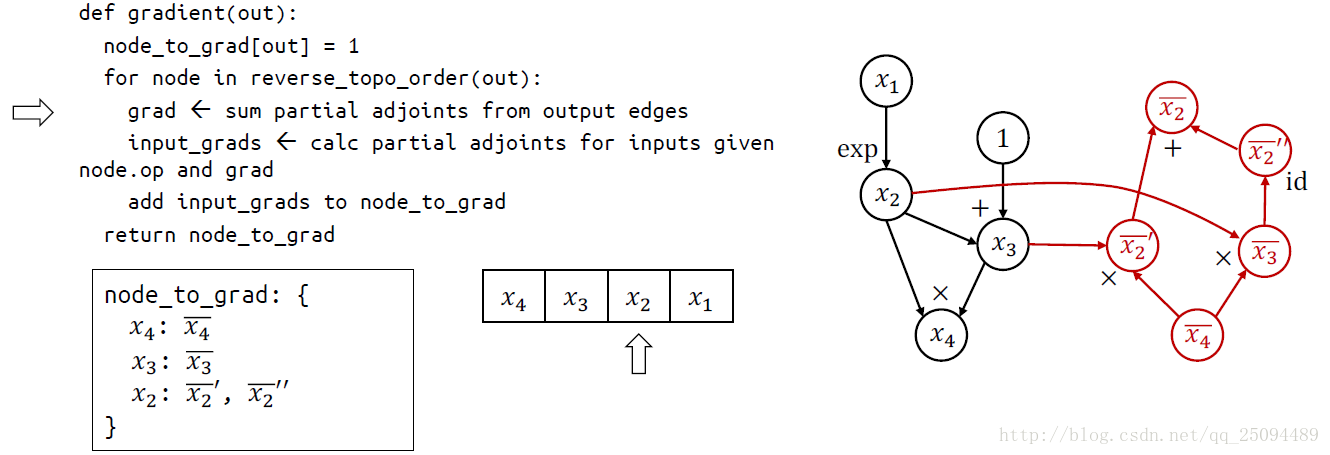

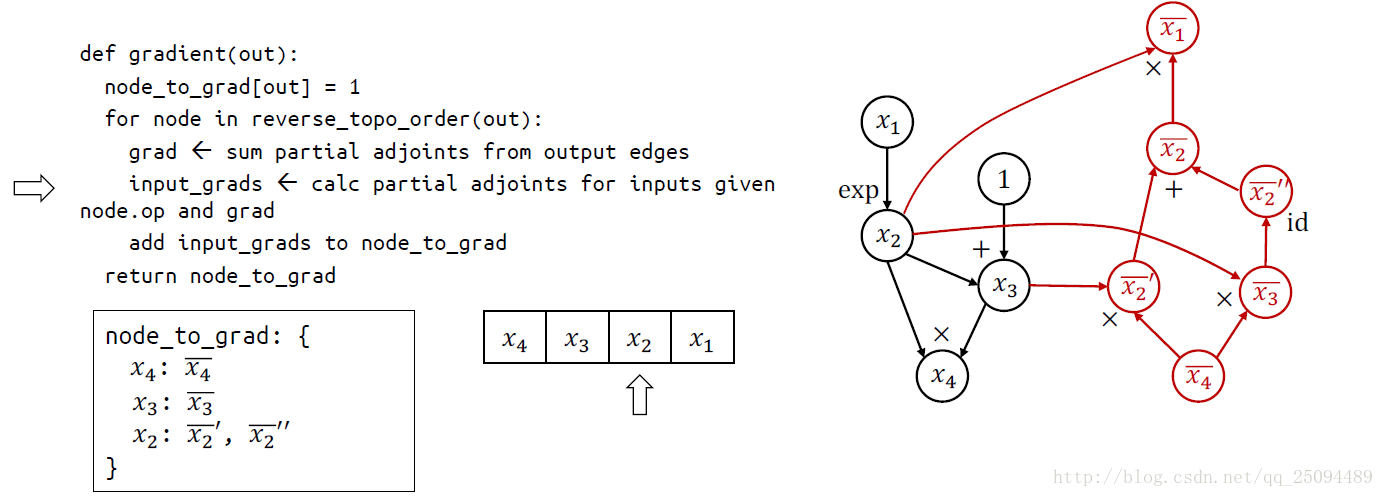

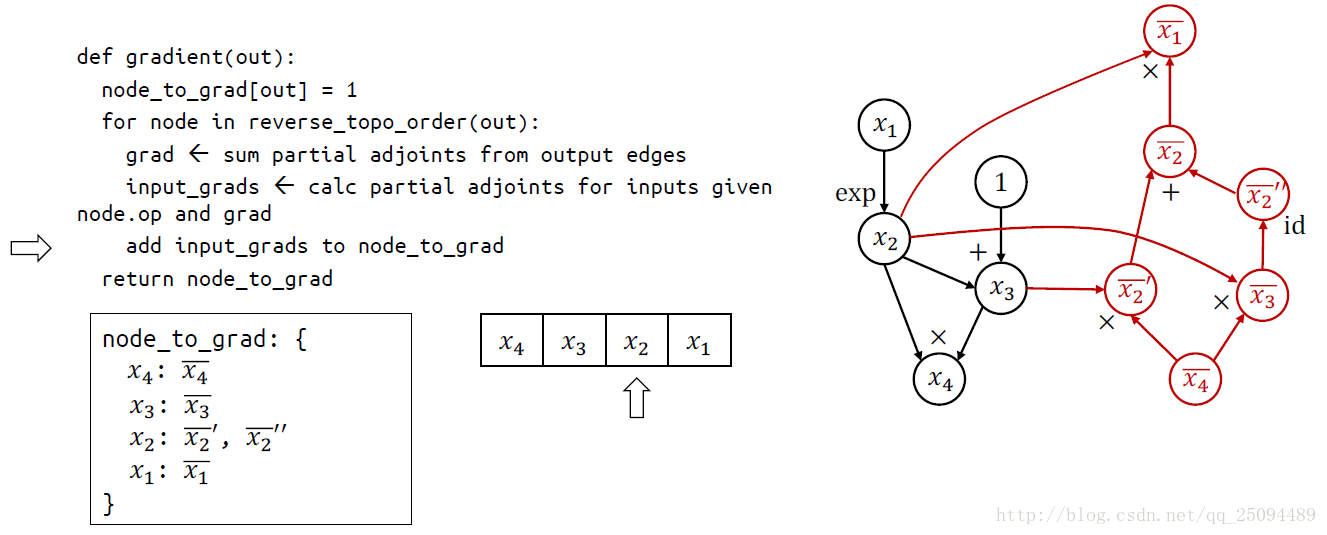

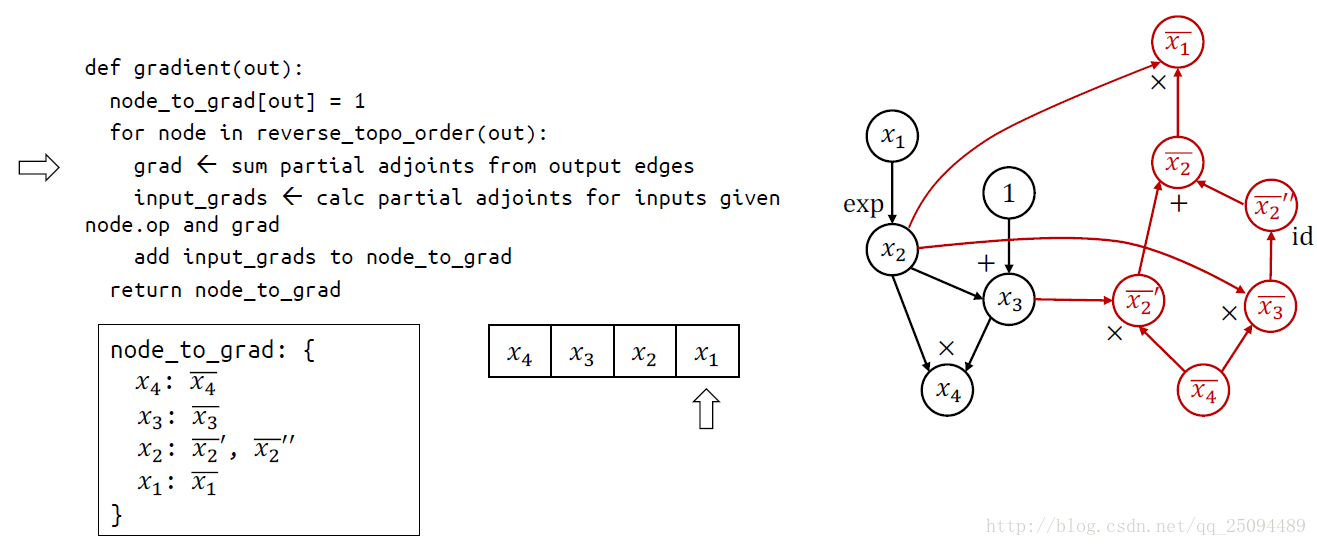

最基本的原理就是鏈式法則,關鍵思想是在基本操作(op)的水平上應用符號求導,并保持中間結果(grad)。

基本操作的符號求導定義在\tensorflow\python\ops\math_grad.py文件中,這個文件中的所有函數都用RegisterGradient裝飾器包裝了起來,這些函數都接受兩個參數op和grad,參數op是操作,第二個參數是grad是之前的梯度。

舉個例子:

補充:聊聊Tensorflow自動求導機制

在即時執行模式下,Tensorflow引入tf.GradientTape()這個“求導記錄器”來實現自動求導。

import tensorflow as tf #定義變量 x = tf.Variable(initial_value = 3.) #在tf.GradientTape()的上下文內,所有計算步驟都會被記錄以用于求導 with tf.GradientTape() as tape: #y = x^2 y = tf.square(x) #計算y關于x的導數(斜率,梯度) y_grad = tape.gradient(y,x) print([y,y_grad])

輸出:

[<tf.Tensor: shape=(), dtype=float32, numpy=9.0>, <tf.Tensor: shape=(), dtype=float32, numpy=6.0>]

關于“TensorFlow的自動求導原理是什么”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。