您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家分享的是有關python爬蟲怎么用scrapy獲取影片的內容。小編覺得挺實用的,因此分享給大家做個參考。一起跟隨小編過來看看吧。

1. 創建項目

運行命令:

scrapy startproject myfrist(your_project_name)

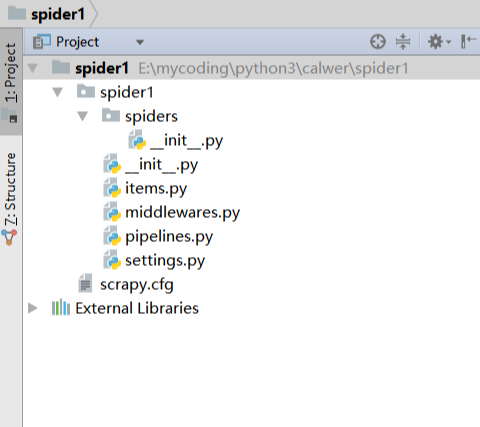

文件說明: 名稱 | 作用 --|-- scrapy.cfg | 項目的配置信息,主要為Scrapy命令行工具提供一個基礎的配置信息。(真正爬蟲相關的配置信息在settings.py文件中) items.py | 設置數據存儲模板,用于結構化數據,如:Django的Model pipelines | 數據處理行為,如:一般結構化的數據持久化 settings.py | 配置文件,如:遞歸的層數、并發數,延遲下載等 spiders | 爬蟲目錄,如:創建文件,編寫爬蟲規則

注意:一般創建爬蟲文件時,以網站域名命名

2 編寫 spdier

在spiders目錄中新建 daidu_spider.py 文件

2.1 注意

爬蟲文件需要定義一個類,并繼承scrapy.spiders.Spider

必須定義name,即爬蟲名,如果沒有name,會報錯。因為源碼中是這樣定義的

2.2 編寫內容

在這里可以告訴 scrapy 。要如何查找確切數據,這里必須要定義一些屬性

name: 它定義了蜘蛛的唯一名稱

allowed_domains: 它包含了蜘蛛抓取的基本URL;

start-urls: 蜘蛛開始爬行的URL列表;

parse(): 這是提取并解析刮下數據的方法;

下面的代碼演示了蜘蛛代碼的樣子:

import scrapy

class DoubanSpider(scrapy.Spider):

name = 'douban'

allwed_url = 'douban.com'

start_urls = [

'https://movie.douban.com/top250/'

]

def parse(self, response):

movie_name = response.xpath("//div[@class='item']//a/span[1]/text()").extract()

movie_core = response.xpath("//div[@class='star']/span[2]/text()").extract()

yield {

'movie_name':movie_name,

'movie_core':movie_core

}感謝各位的閱讀!關于python爬蟲怎么用scrapy獲取影片就分享到這里了,希望以上內容可以對大家有一定的幫助,讓大家可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到吧!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。