您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

目前深度學習應用廣發, 其中 AI 推理的在線服務是其中一個重要的可落地的應用場景。本文將為大家介紹使用函數計算部署深度學習 AI 推理的最佳實踐, ?其中包括使用 FUN 工具一鍵部署安裝第三方依賴、一鍵部署、本地調試以及壓測評估, 全方位展現函數計算的開發敏捷特性、自動彈性伸縮能力、免運維和完善的監控設施。

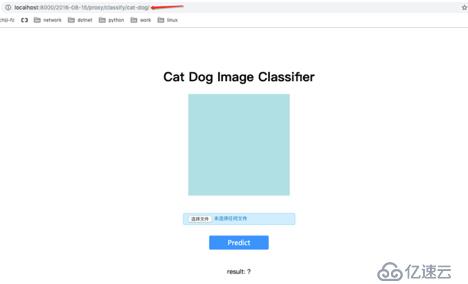

通過上傳一個貓或者狗的照片, 識別出這個照片里面的動物是貓還是狗

開通服務

免費開通函數計算, 按量付費,函數計算有很大的免費額度。

免費開通文件存儲服務NAS, 按量付費

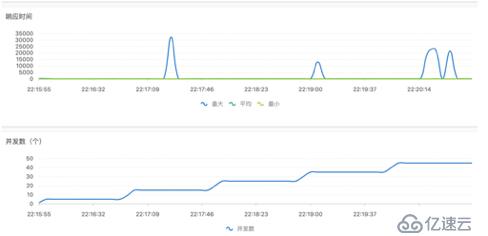

如上圖所示, 當多個用戶通過對外提供的 url 訪問推理服務時候,每秒的請求幾百上千都沒有關系, 函數計算平臺會自動伸縮, 提供足夠的執行實例來響應用戶的請求, 同時函數計算提供了完善的監控設施來監控您的函數運行情況。

| 自建服務 | 函數計算 Serverless | |

|---|---|---|

| 基礎設施 | 需要用戶采購和管理 | 無 |

| 開發效率 | 除了必要的業務邏輯開發,需要自己建立相同線上運行環境, 包括相關軟件的安裝、服務配置、安全更新等一系列問題 | 只需要專注業務邏輯的開發, 配合 FUN 工具一鍵資源編排和部署 |

| 學習上手成本 | 可能使用 K8S 或彈性伸縮( ESS ),需要了解更多的產品、名詞和參數的意義 | 會編寫對應的語言的函數代碼即可 |

| 自建服務 | 函數計算 Serverless | |

|---|---|---|

| 彈性高可用 | 需要自建負載均衡 (SLB),彈性伸縮,擴容縮容速度較 FC 慢 | FC系統固有毫秒級別彈性伸縮,快速實現底層擴容以應對峰值壓力,免運維 |

| 監控報警查詢 | ECS 級別的 metrics | 提供更細粒度的函數執行情況,每次訪問函數執行的 latency 和日志等, 更加完善的報警監控機制 |

對于明顯波峰波谷或者稀疏調用具有低成本優勢, 同時還保持了彈性能力,以后業務規模做大以后并沒有技術切換成本,同時財務成本增長配合預付費也能保持平滑。

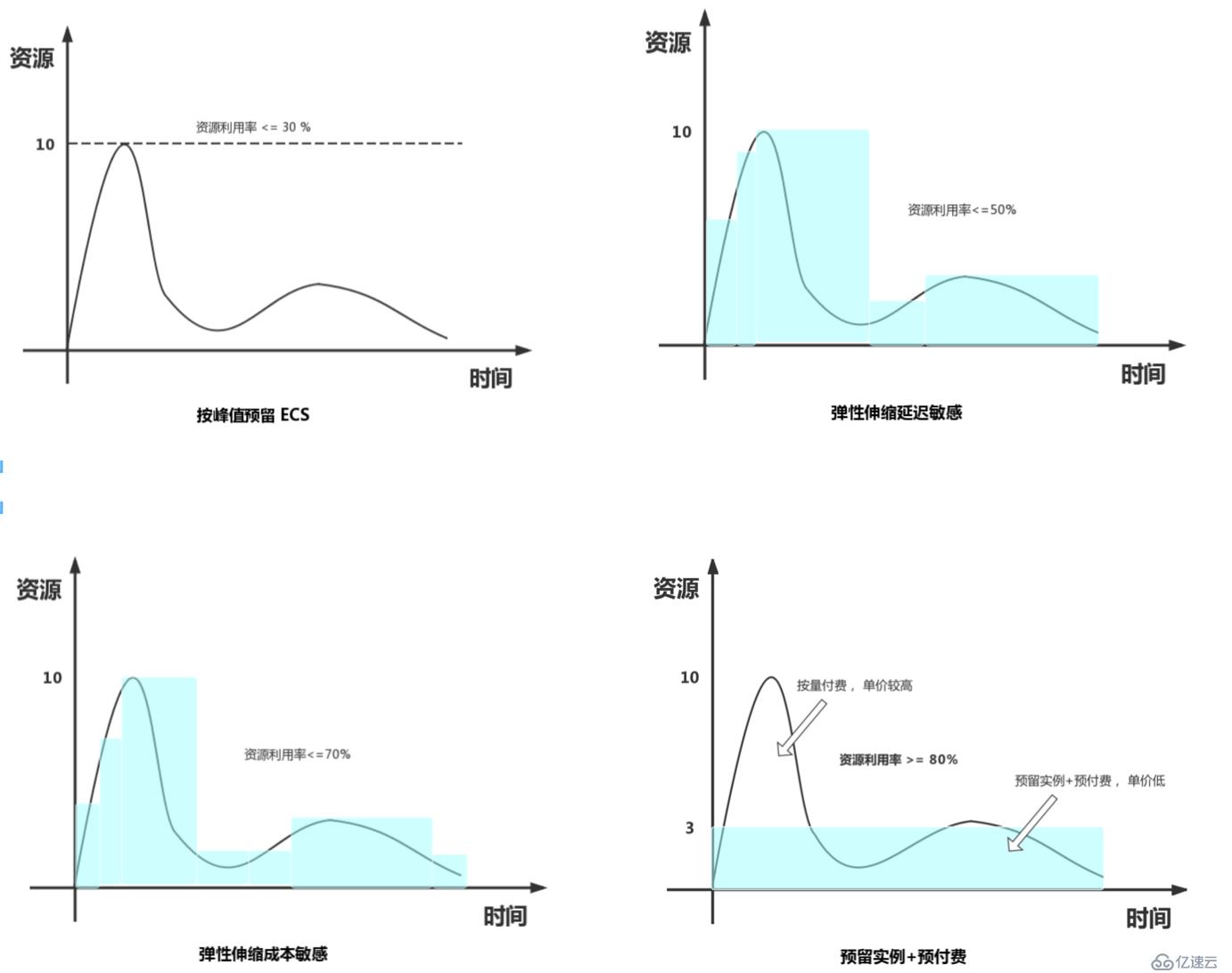

假設有一個在線計算服務,由于是CPU 密集型計算, 因此在這里我們將平均 CPU 利用率作為核心參考指標對成本,以一個月為周期,10臺 C5 ECS 的總計算力為例,總的計算量約為 30% 場景下, 各解決方案 CPU 資源利用率使用情況示意圖大致如下:

由上圖預估出如下計費模型:

| 平均CPU利用率 | 計算費用 | SLB | 總計 | |

|---|---|---|---|---|

| 函數計算組合付費 | >=80% | 738+X(246.27*3+X) | 無 | <= 738+X |

| 按峰值預留ECS | <=30% | 2190(10*219) | 526.52 | >=2716.52 |

| 彈性伸縮延遲敏感 | <=50% | 1314(102193/5) | 526.52 | >= 1840.52 |

| 彈性伸縮成本敏感 | <=70% | 938.57 (102193/7) | 526.52 | >= 1465.09 |

注:

這里假設函數邏輯沒有公網公網下行流量費用, 即使有也是一致的, 這里成本比較暫不參與

延時敏感,當 CPU 利用率大于等于 50% 就需要開始進行擴容,不然更來不及應對峰值

- 成本敏感,當 CPU 利用率大約 80% 即開始進行擴容, 能容受一定幾率的超時或者5XX

上表中, 其中函數計算組合付費中的 X 為按需付費的成本價,假設按需付費的計算量占整個計算量的 10%,假設 CPU 利用率為100%, ?對應上表,那么需要 3 臺 ECS 的計算能力即可。因此 FC 按量付費的成本 X = 3 ?446.4 ? 10% ? 2 = ?267.84 ( FC 按量付費是按量 ECS 的2倍),這個時候函數計算組合付費總計 ?1005.8 元。 在這個模型預估里面, 只要 FC 按量付費占整個計算量小于 20%, 即使不考慮 SLB, 單純考慮計算成本, 都是有一定優勢的。

基于函數計算進行 AI 推理等 CPU 密集型的主要優勢:

FUN 操作簡明視頻教程

免費開通函數計算, 按量付費,函數計算有很大的免費額度。

免費開通文件存儲服務NAS, 按量付費

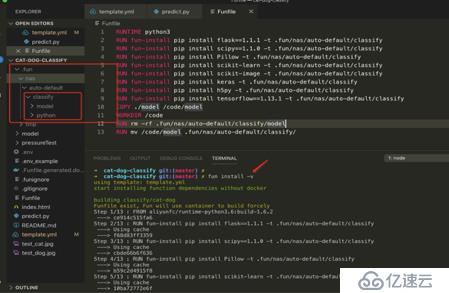

git clone https://github.com/awesome-fc/cat-dog-classify.gitfun install -v, ?fun 會根據 Funfile 中定義的邏輯安裝相關的依賴包

root@66fb3ad27a4c: ls .fun/nas/auto-default/classify

model python

root@66fb3ad27a4c: du -sm .fun

697 .fun根據 Funfile 的定義:

.fun/nas/auto-default/classify/python 目錄下.fun/nas/auto-default/model 目錄下安裝完成后,從這里我們看出, 函數計算引用的代碼包解壓之后已經達到了 670 M, 遠超過 50M 代碼包限制, 解決方案是 NAS 詳情可以參考: ?掛載NAS訪問,幸運的是 FUN 工具一鍵解決了 nas 的配置和文件上傳問題。

fun nas init

fun nas info

fun nas sync

fun nas ls nas://classify:/mnt/auto/依次執行這些命令,就將本地中的 .fun/nas/auto-default 中的第三方代碼包和模型文件傳到 NAS 中, 依次看下這幾個命令的做了什么事情:

fun nas init: 初始化 NAS, 基于您的 .env 中的信息獲取(已有滿足條件的nas)或創建一個同region可用的nasfun nas info: 可以查看本地 NAS 的目錄位置, 對于此工程是 $(pwd)/.fun/nas/auto-default/classifyfun nas sync: 將本地 NAS 中的內容(.fun/nas/auto-default/classify)上傳到 NAS 中的 classify 目錄fun nas ls nas:///mnt/auto/: 查看我們是否已經正確將文件上傳到了 NAS登錄 NAS 控制臺 https://nas.console.aliyun.com 和 VPC 控制臺 https://vpc.console.aliyun.com<br />可以觀察到在指定的 region 上有 NAS 和 相應的 vpc 創建成功

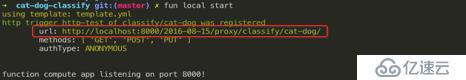

在 template.yml 中, 指定了這個函數是 http 類型的函數, 所以根據 fun 的提示:

Tips for next step

======================

* Invoke Event Function: fun local invoke

* Invoke Http Function: fun local start

* Build Http Function: fun build

* Deploy Resources: fun deploy執行 fun local start, ?本地就會啟動一個 http server 來模擬函數的執行, 然后我們 client 端可以使用 postman, curl 或者瀏覽器, 比如對于本例:

本地調試OK 后,我們接下來將函數部署到云平臺:

修改 template.yml LogConfig 中的 Project, 任意取一個不會重復的名字即可,有兩處地方需要更改,然后執行

fun deploy

注意: ?template.yml 注釋的部分為自定義域名的配置, 如果想在 fun deploy 中完成這個部署工作:

fun deploy這個時候如果沒有自定義域名, 直接通過瀏覽器訪問訪問http trigger 的url, 比如 https://123456.cn-shenzhen.fc.aliyuncs.com/2016-08-15/proxy/classify/cat-dog/ 會被強制下載.

原因:https://help.aliyun.com/knowledge_detail/56103.html#HTTP-Trigger-compulsory-header

登錄控制臺https://fc.console.aliyun.com,可以看到service 和 函數已經創建成功, 并且 service 也已經正確配置。

在這里,我們發現第一次打開頁面訪問函數的時候,執行環境實例冷啟動時間非常長, 如果是一個在線AI推理服務,對響應時間非常敏感,冷啟動引起的毛刺對于這種類型的服務是不可接受的,接下來,本文講解如何利用函數計算的預留模式來消除冷啟動帶來的負面影響。

函數計算具有動態伸縮的特性, 根據并發請求量,自動彈性擴容出執行環境來執行環境,在這個典型的深度學習示例中,import keras 消耗的時間很長 , 在我們設置的 1 G 規格的函數中, 并發訪問的時候耗時10s左右, 有時甚至20s+

start = time.time()

from keras.models import model_from_json

print("import keras time = ", time.time()-start)預留操作簡明視頻教程

從上面圖中我們可以看出,當函數執行的請求到來時,優先被調度到預留的實例中被執行, 這個時候是沒有冷啟動的,所以請求是沒有毛刺的, 后面隨著測試的壓力不斷增大(峰值TPS 達到 1184), 預留的實例不能滿足調用函數的請求, 這個時候函數計算就自動進行按需擴容實例供函數執行,此時的調用就有冷啟動的過程, 從上面我們可以看出,函數的最大 latency 時間甚至達到了 32s,如果這個web AP是延時敏感的,這個 latency 是不可接受的。

有任何問題歡迎進掃碼進釘釘群溝通

“阿里巴巴云原生關注微服務、Serverless、容器、Service Mesh 等技術領域、聚焦云原生流行技術趨勢、云原生大規模的落地實踐,做最懂云原生開發者的技術圈。”

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。