您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇文章為大家展示了使用TensorFlow怎么實現一個線性回歸,內容簡明扼要并且容易理解,絕對能使你眼前一亮,通過這篇文章的詳細介紹希望你能有所收獲。

單變量線性回歸:

a) 因為是線性回歸,所以學習到的函數為線性函數,即直線函數;

b) 因為是單變量,因此只有一個x。

我們能夠給出單變量線性回歸的模型:

我們常稱x為feature,h(x)為hypothesis。

上面介紹的方法中,我們肯定有一個疑問,怎樣能夠看出線性函數擬合的好不好呢?

所以此處,我們需要使用到Cost Function(代價函數),代價函數越小,說明線性回歸也越好(和訓練集合擬合的越好),當然最小就是0,即完全擬合。

舉個實際的例子:

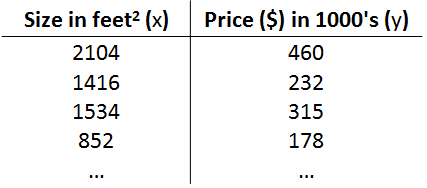

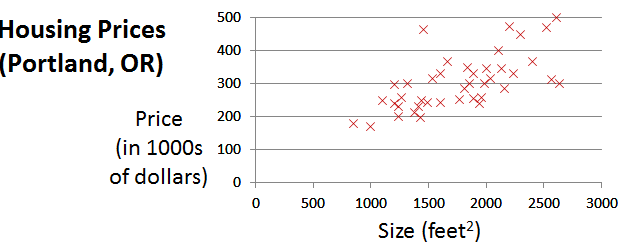

我們想要根據房子的大小,預測房子的價格,給定如下數據集:

根據上面的數據集,畫出如下所示的圖:

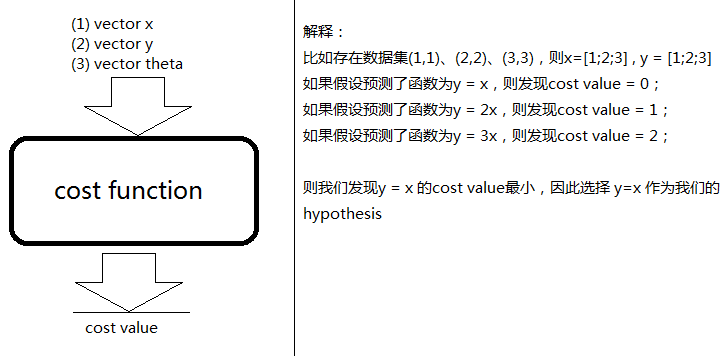

我們需要根據這些點擬合出一條直線,使得Cost Function最小。雖然現在我們還不知道Cost Function內部到底是什么樣的,但是我們的目標是:給定輸入向量x,輸出向量y,theta向量,輸出Cost值。

Cost Function:

Cost Function的用途:對假設的函數進行評價,Cost Function越小的函數,說明對訓練數據擬合的越好。

下圖詳細說明了當Cost Function為黑盒的時候,Cost Function的作用:

但是我們肯定想知道Cost Function的內部結構是什么?因此我們給出下面的公式:

其中:

表示向量x中的第i個元素;

表示向量x中的第i個元素;

表示向量y中的第i個元素;

表示向量y中的第i個元素;

表示已知的假設函數;m表示訓練集的數量。

表示已知的假設函數;m表示訓練集的數量。

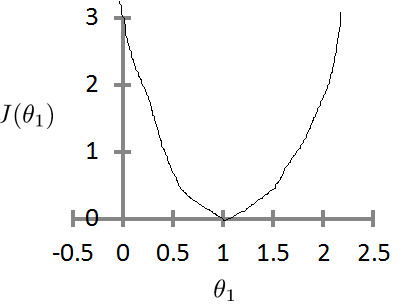

如果theta0一直為0,則theta1與J的函數為:

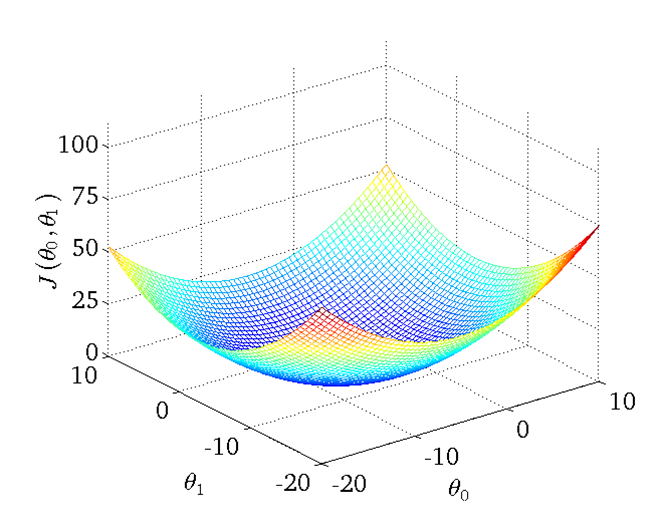

如果theta0和theta1都不固定,則theta0、theta1、J的函數為:

當然我們也能夠用二維的圖來表示,即等高線圖:

注意如果是線性回歸,則cost function一定是碗狀的,即只有一個最小點。

Gradient Descent(梯度下降):

但是又一個問題引出來了,雖然給定一個函數,我們能夠根據cost function知道這個函數擬合的好不好,但是畢竟函數有這么多,總不能一個一個試吧?

于是我們引出了梯度下降:能夠找出cost function函數的最小值。(當然解決問題的方法有很多,梯度下降只是其中一個,還有一種方法叫Normal Equation)。

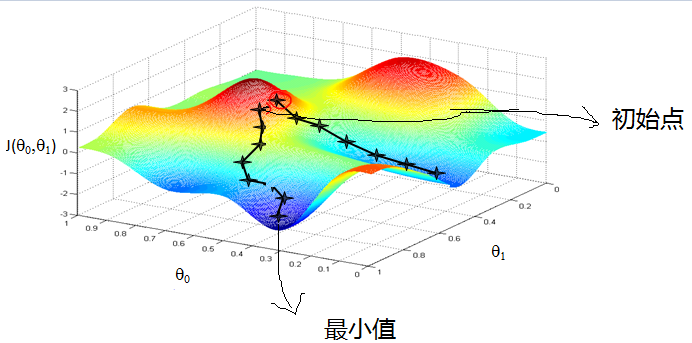

梯度下降的原理:將函數比作一座山,我們站在某個山坡上,往四周看,從哪個方向向下走一小步,能夠下降的最快。

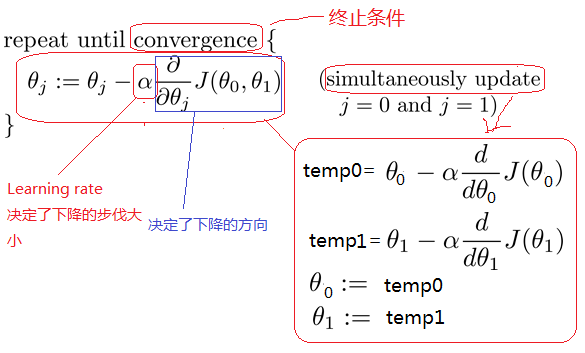

方法:

a) 先確定向下一步的步伐大小,我們稱為learning rate;

b) 任意給定一個初始值: 和

和 ;

;

c) 確定一個向下的方向,并向下走預定的步伐,并更新 和

和 ;

;

d) 當下降的高度小于某個定義的值,則停止下降。

算法:

特點:

a)初始點不同,獲得的最小值也不同,因此梯度下降求得的只是局部最小值;

b)越接近最小值,下降速度越慢。

問題1:如果 和

和 初始值就在local minimum的位置,則

初始值就在local minimum的位置,則 、

、 會如何變化?

會如何變化?

答案:因為 、

、 已經在local minimum位置,所以derivative肯定是0,因此

已經在local minimum位置,所以derivative肯定是0,因此 、

、 不會改變。

不會改變。

問題2:如果取到一個正確的 值,則cost function應該會越來越小。那么,怎么取

值,則cost function應該會越來越小。那么,怎么取 值?

值?

答案:隨時觀察 值,如果cost function變小了,則OK;反之,則再取一個更小的值。

值,如果cost function變小了,則OK;反之,則再取一個更小的值。

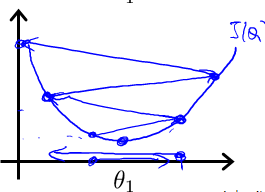

下圖就詳細說明了梯度下降的過程:

從上圖中可以看出:初始點不同,獲得的最小值也不同,因此,梯度下降求得的只是局部最小值。

注意:下降的步伐大小非常重要,因為,如果太小,則找到函數最小值的速度就很慢;如果太大,則可能會出現overshoot the minimum現象。

下圖就是overshoot現象:

如果Learning Rate取值后發現J function增長了,則需要減小Learning Rate的值。

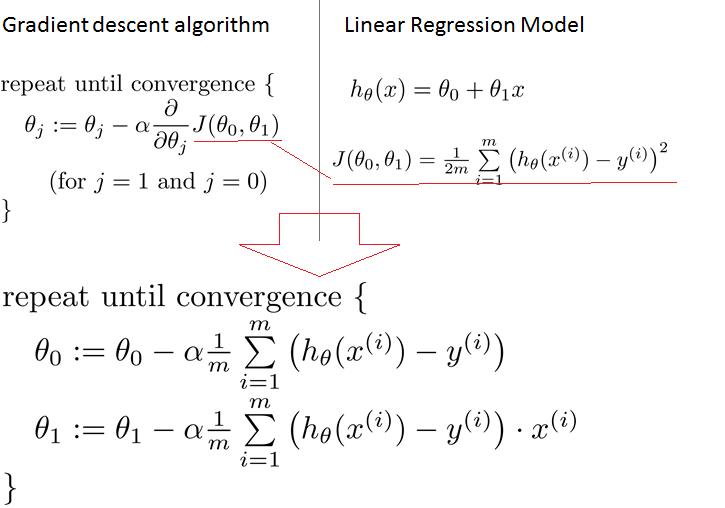

Integrating with Gradient Descent & Linear Regression:

梯度下降能夠求出一個函數的最小值。

線性回歸需要求得最小的Cost Function。

因此我們能夠對Cost Function運用梯度下降,即將梯度下降和線性回歸進行整合,如下圖所示:

梯度下降是通過不停的迭代,而我們比較關注迭代的次數,因為這關系到梯度下降的執行速度,為了減少迭代次數,因此引入了Feature Scaling。

Feature Scaling:

此種方法應用于梯度下降,為了加快梯度下降的執行速度。

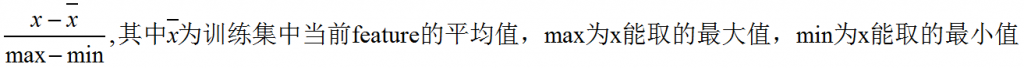

思想:將各個feature的值標準化,使得取值范圍大致都在-1<=x<=1之間。

常用的方法是Mean Normalization,即 ,或者[X-mean(X)]/std(X)。

,或者[X-mean(X)]/std(X)。

練習題

我們想要通過期中考試成績預測期末考試成績,我們希望得到的方程為:

給定以下訓練集:

我們想對(midterm exam)^2進行feature scaling,則 經過feature scaling后的值為多少?

經過feature scaling后的值為多少?

解答:其中max = 8836,min = 4761,mean = 6675.5,則 = (4761 - 6675.5)/(8836 - 4761) = -0.47 。

= (4761 - 6675.5)/(8836 - 4761) = -0.47 。

多變量線性回歸

前面我們只介紹了單變量的線性回歸,即只有一個輸入變量,現實世界可不只是這么簡單,因此此處我們要介紹多變量的線性回歸。

舉個例子:房價其實受很多因素決定,比如size、number of bedrooms、number of floors、age of home等,這里我們假設房價由4個因素決定,如下圖所示:

我們前面定義過單變量線性回歸的模型:

這里我們可以定義出多變量線性回歸的模型:

Cost Function如下:

如果下面我們要用梯度下降解決多變量的線性回歸,則我們還是可以用傳統的梯度下降算法進行計算:

總練習題

我們想要根據一個學生第一年的成績預測第二年的成績,x為第一年得到A的數量,y為第二年得到A的數量,給定以下數據集:

(1) 訓練集的個數?

答:4個。

(2) J(0, 1)的結果是多少?

解:J(0,1) = 1/(2*4)*[(3-4)^2+(2-1)^2+(4-3)^2+(0-1)^2] = 1/8*(1+1+1+1) = 1/2 = 0.5。

我們也可以通過vectorization的方法快速算出J(0, 1):

下面是通過TensorFlow進行簡單的實現:

#!/usr/bin/env python

from __future__ import print_function

import tensorflow as tf

import numpy as np

trX = np.linspace(-1, 1, 101)

# create a y value which is approximately linear but with some random noise

trY = 2 * trX + \

np.ones(*trX.shape) * 4 + \

np.random.randn(*trX.shape) * 0.03

X = tf.placeholder(tf.float32) # create symbolic variables

Y = tf.placeholder(tf.float32)

def model(X, w, b):

# linear regression is just X*w + b, so this model line is pretty simple

return tf.mul(X, w) + b

# create a shared for weight s

w = tf.Variable(0.0, name="weights")

# create a variable for biases

b = tf.Variable(0.0, name="biases")

y_model = model(X, w, b)

cost = tf.square(Y - y_model) # use square error for cost function

# construct an optimizer to minimize cost and fit line to mydata

train_op = tf.train.GradientDescentOptimizer(0.01).minimize(cost)

# launch the graph in a session

with tf.Session() as sess:

# you need to initialize variables (in this case just variable w)

init = tf.initialize_all_variables()

sess.run(init)

# train

for i in range(100):

for (x, y) in zip(trX, trY):

sess.run(train_op, feed_dict={X: x, Y: y})

# print weight

print(sess.run(w)) # it should be something around 2

# print bias

print(sess.run(b)) # it should be something atound 4上述內容就是使用TensorFlow怎么實現一個線性回歸,你們學到知識或技能了嗎?如果還想學到更多技能或者豐富自己的知識儲備,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。