您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

python機器學習之神經網絡實現?很多新手對此不是很清楚,為了幫助大家解決這個難題,下面小編將為大家詳細講解,有這方面需求的人可以來學習下,希望你能有所收獲。

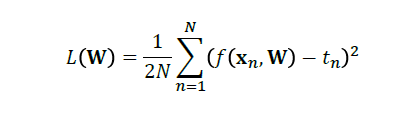

首先,當我們建立一個回歸和分類模型的時候,無論是用最小二乘法(OLS)還是最大似然值(MLE)都用來使得殘差達到最小。因此我們在建立模型的時候,都會有一個loss function。

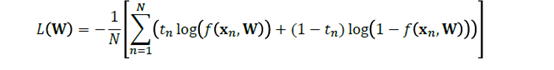

而在神經網絡里也不例外,也有個類似的loss function。

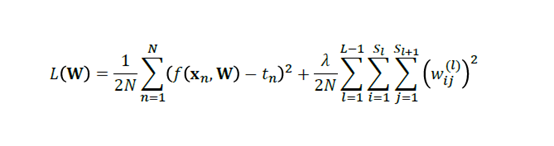

對回歸而言:

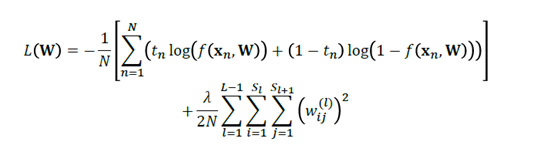

對分類而言:

然后同樣方法,對于W開始求導,求導為零就可以求出極值來。

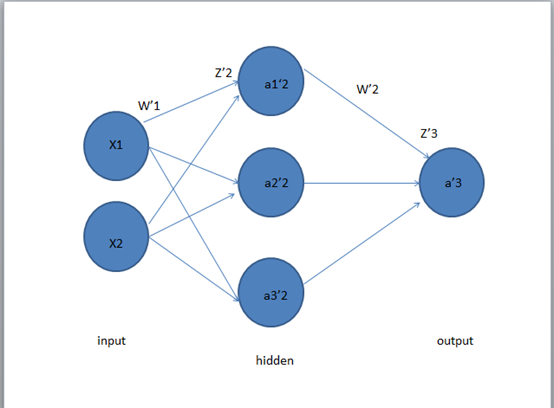

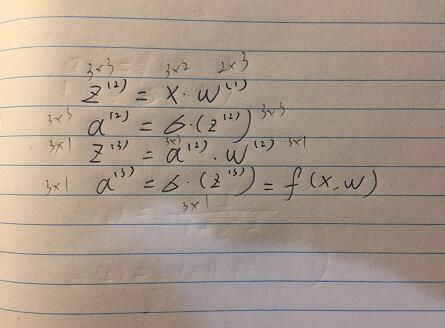

關于式子中的W。我們在這里以三層的神經網絡為例。先介紹一下神經網絡的相關參數。

第一層是輸入層,第二層是隱藏層,第三層是輸出層。

在X1,X2經過W1的加權后,達到隱藏層,然后經過W2的加權,到達輸出層

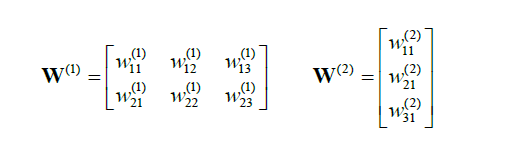

其中,

我們有:

至此,我們建立了一個初級的三層神經網絡。

當我們要求其的loss function最小時,我們需要逆向來求,也就是所謂的backpropagation。

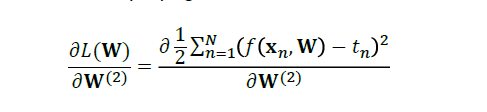

我們要分別對W1和W2進行求導,然后求出其極值。

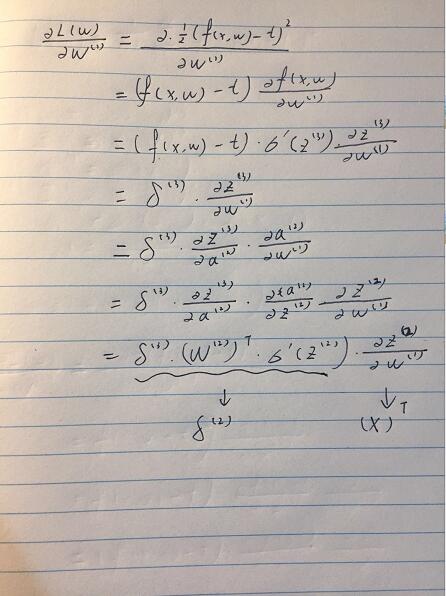

從右手邊開始逆推,首先對W2進行求導。

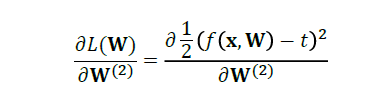

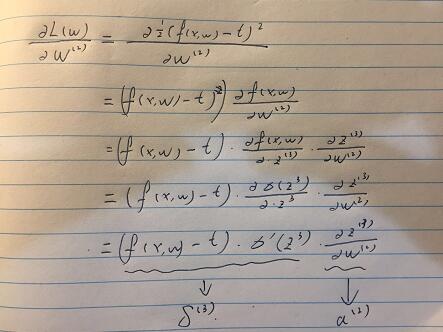

代入損失函數公式:

然后,我們進行化簡:

化簡到這里,我們同理再對W1進行求導。

我們可以發現當我們在做bp網絡時候,有一個逆推回去的誤差項,其決定了loss function 的最終大小。

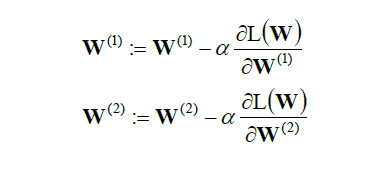

在實際的運算當中,我們會用到梯度求解,來求出極值點。

總結一下來說,我們使用向前推進來理順神經網絡做到回歸分類等模型。而向后推進來計算他的損失函數,使得參數W有一個最優解。

當然,和線性回歸等模型相類似的是,我們也可以加上正則化的項來對W參數進行約束,以免使得模型的偏差太小,而導致在測試集的表現不佳。

Python 的實現:

使用了KERAS的庫

解決線性回歸:

model.add(Dense(1, input_dim=n_features, activation='linear', use_bias=True)) # Use mean squared error for the loss metric and use the ADAM backprop algorithm model.compile(loss='mean_squared_error', optimizer='adam') # Train the network (learn the weights) # We need to convert from DataFrame to NumpyArray history = model.fit(X_train.values, y_train.values, epochs=100, batch_size=1, verbose=2, validation_split=0)

解決多重分類問題:

# create model model = Sequential() model.add(Dense(64, activation='relu', input_dim=n_features)) model.add(Dropout(0.5)) model.add(Dense(64, activation='relu')) model.add(Dropout(0.5)) # Softmax output layer model.add(Dense(7, activation='softmax')) model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy']) model.fit(X_train.values, y_train.values, epochs=20, batch_size=16) y_pred = model.predict(X_test.values) y_te = np.argmax(y_test.values, axis = 1) y_pr = np.argmax(y_pred, axis = 1) print(np.unique(y_pr)) print(classification_report(y_te, y_pr)) print(confusion_matrix(y_te, y_pr))

當我們選取最優參數時候,有很多種解決的途徑。這里就介紹一種是gridsearchcv的方法,這是一種暴力檢索的方法,遍歷所有的設定參數來求得最優參數。

from sklearn.model_selection import GridSearchCV def create_model(optimizer='rmsprop'): model = Sequential() model.add(Dense(64, activation='relu', input_dim=n_features)) model.add(Dropout(0.5)) model.add(Dense(64, activation='relu')) model.add(Dropout(0.5)) model.add(Dense(7, activation='softmax')) model.compile(loss='categorical_crossentropy', optimizer=optimizer, metrics=['accuracy']) return model model = KerasClassifier(build_fn=create_model, verbose=0) optimizers = ['rmsprop'] epochs = [5, 10, 15] batches = [128] param_grid = dict(optimizer=optimizers, epochs=epochs, batch_size=batches, verbose=['2']) grid = GridSearchCV(estimator=model, param_grid=param_grid) grid.fit(X_train.values, y_train.values)

看完上述內容是否對您有幫助呢?如果還想對相關知識有進一步的了解或閱讀更多相關文章,請關注億速云行業資訊頻道,感謝您對億速云的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。