您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹了python Opencv計算圖像相似度過程解析,文中通過示例代碼介紹的非常詳細,對大家的學習或者工作具有一定的參考學習價值,需要的朋友可以參考下

一、相關概念

一般我們人區分誰是誰,給物品分類,都是通過各種特征去辨別的,比如黑長直、大白腿、櫻桃唇、瓜子臉。王麻子臉上有麻子,隔壁老王和兒子很像,但是兒子下巴漲了一顆痣和他媽一模一樣,讓你確定這是你兒子。

還有其他物品、什么桌子帶腿、鏡子反光能在里面倒影出東西,各種各樣的特征,我們通過學習、歸納,自然而然能夠很快識別分類出新物品。

而沒有學習訓練過的機器就沒辦法了。

但是圖像是一個個像素點組成的,我們就可以通過不同圖像之間這些差異性就判斷兩個圖的相似度了。其中顏色特征是最常用的,(其余常用的特征還有紋理特征、形狀特征和空間關系特征等)

其中又分為

1、直方圖

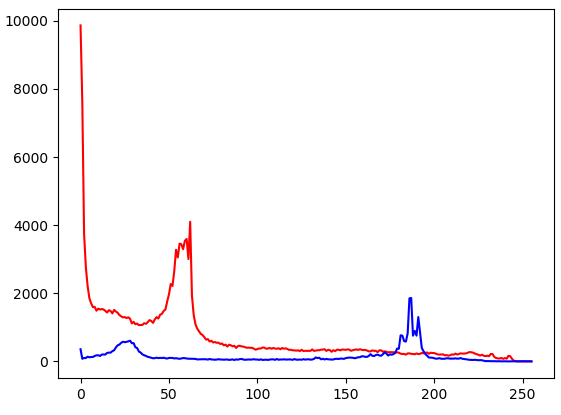

在Python中利用opencv中的calcHist()方法獲取其直方圖數據,返回的結果是一個列表,使用matplotlib,畫出了這兩張圖的直方圖數據圖

import cv2

import numpy

from matplotlib import pyplot

if __name__ == '__main__':

imgobj1 = cv2.imread('pho.jpg')

imgobj2 = cv2.imread('ph2.jpg')

hist1 = cv2.calcHist([imgobj1], [0], None, [256], [0.0, 255.0])

hist2 = cv2.calcHist([imgobj2], [0], None, [256], [0.0, 255.0])

pyplot.plot(range(256), hist1, 'r')

pyplot.plot(range(256), hist2, 'b')

pyplot.show()

cv2.imshow('img1',imgobj1)

cv2.imshow('img2',imgobj2)

cv2.waitKey(0)

1.2 灰度圖及作用

灰度圖是只含有黑白顏色,和0~255亮度等級的圖片。灰度圖具有存儲小,其亮度值就是256色調色板索引號,從整幅圖像的整體和局部的色彩以及亮度等級分布特征來看,灰度圖描述與彩色圖的描述是一致的特點。因此很多真彩色圖片的分析,第一步就是轉換為灰度圖,然后再進行分析。

真彩色,因為是24位,2(^8) * 2(^8)* 2(^8) = 16777216種顏色,需要調色板16777216 * 4byte字節的空間也就是64MB的調色板空間,所以真彩色是不用調色板的。

例如視頻目標跟蹤和識別時,第一步就是要轉換為灰度圖。現有的成熟分析算法多是基于灰度圖像的,灰度圖像綜合了真彩色位圖的RGB各通道的信息。

(一):單通道圖,

俗稱灰度圖,每個像素點只能有有一個值表示顏色,它的像素值在0到255之間,0是黑色,255是白色,中間值是一些不同等級的灰色。(也有3通道的灰度圖,3通道灰度圖只有一個通道有值,其他兩個通道的值都是零)。

(二):三通道圖,每個像素點都有3個值表示 ,所以就是3通道。也有4通道的圖。例如RGB圖片即為三通道圖片,RGB色彩模式是工業界的一種顏色標準,是通過對紅(R)、綠(G)、藍(B)三個顏色通道的變化以及它們相互之間的疊加來得到各式各樣的顏色的,RGB即是代表紅、綠、藍三個通道的顏色,這個標準幾乎包括了人類視力所能感知的所有顏色,是目前運用最廣的顏色系統之一。總之,每一個點由三個值表示。

直方圖判斷相似度,如上圖,就算重合度即可

1.3 圖像指紋和漢明距離

圖像指紋:

和人的指紋一樣,是身份的象征,而圖像指紋簡單點來講,就是將圖像按照一定的哈希算法,經過運算后得出的一組二進制數字。

漢明距離:

假如一組二進制數據為101,另外一組為111,那么顯然把第一組的第二位數據0改成1就可以變成第二組數據111,所以兩組數據的漢明距離就為1

簡單點說,漢明距離就是一組二進制數據變成另一組數據所需的步驟數,顯然,這個數值可以衡量兩張圖片的差異,漢明距離越小,則代表相似度越高。漢明距離為0,即代表兩張圖片完全一樣。

1.3.1 平均哈希

此算法是基于比較灰度圖每個像素與平均值來實現的

一般步驟:

import cv2

import numpy as np

img1 = cv2.imread("/absPath.png")

img2 = cv2.imread("./x.png")

#調整到8*8

img1 = cv2.resize(img1,(8,8))

img2 = cv2.resize(img2,(8,8))

#轉化為灰度圖

gray1 = cv2.cvtColor(img1,cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(img2,cv2.COLOR_BGR2GRAY)

#獲取哈希

hash2 = getHash(gray1)

hash3 = getHash(gray2)

ret = Hamming_distance(hash2,hash3)

# 輸入灰度圖,返回hash

def getHash(image):

avreage = np.mean(image) #計算像素平均值

hash = []

for i in range(image.shape[0]):

for j in range(image.shape[1]):

if image[i, j] > avreage:

hash.append(1)

else:

hash.append(0)

return hash

# 計算漢明距離

def Hamming_distance(hash2, hash3):

num = 0

for index in range(len(hash2)):

if hash2[index] != hash3[index]:

num += 1

return num

1.3.2 感知哈希及d哈希

感知哈希算法(pHash)

平均哈希算法過于嚴格,不夠精確,更適合搜索縮略圖,為了獲得更精確的結果可以選擇感知哈希算法,它采用的是DCT(離散余弦變換)來降低頻率的方法

一般步驟:

dHash算法

相比pHash,dHash的速度要快的多,相比aHash,dHash在效率幾乎相同的情況下的效果要更好,它是基于漸變實現的。

步驟:

縮小圖片:收縮到9*8的大小,以便它有72的像素點

轉化為灰度圖

計算差異值:dHash算法工作在相鄰像素之間,這樣每行9個像素之間產生了8個不同的差異,一共8行,則產生了64個差異值

獲得指紋:如果左邊的像素比右邊的更亮,則記錄為1,否則為0.

最后比對兩張圖片的指紋,獲得漢明距離即可。

dHash:

#差值感知算法

def dhash(image1,image2):

image1 = cv2.resize(image1,(9,8))

image2 = cv2.resize(image2,(9,8))

gray1 = cv2.cvtColor(image1,cv2.COLOR_BGR2GRAY) #切換至灰度圖

gray2 = cv2.cvtColor(image2,cv2.COLOR_BGR2GRAY)

hash2 = dhashcaulate(gray1)

hash3 = dhashcaulate(gray2)

return Hamming_distance(hash2,hash3)

def dhashcaulate(gray):

hash_str = ''

for i in range(8):

for j in range(8):

if gray[i, j] > gray[i, j + 1]:

hash_str = hash_str + '1'

else:

hash_str = hash_str + '0'

return hash_str

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持億速云。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。