溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

小編給大家分享一下pytorch方法測試之歸一化BatchNorm2d的示例分析,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

測試代碼:

import torch

import torch.nn as nn

m = nn.BatchNorm2d(2,affine=True) #權重w和偏重將被使用

input = torch.randn(1,2,3,4)

output = m(input)

print("輸入圖片:")

print(input)

print("歸一化權重:")

print(m.weight)

print("歸一化的偏重:")

print(m.bias)

print("歸一化的輸出:")

print(output)

print("輸出的尺度:")

print(output.size())

# i = torch.randn(1,1,2)

print("輸入的第一個維度:")

print(input[0][0])

firstDimenMean = torch.Tensor.mean(input[0][0])

firstDimenVar= torch.Tensor.var(input[0][0],False) #Bessel's Correction貝塞爾校正不會被使用

print(m.eps)

print("輸入的第一個維度平均值:")

print(firstDimenMean)

print("輸入的第一個維度方差:")

print(firstDimenVar)

bacthnormone = \

((input[0][0][0][0] - firstDimenMean)/(torch.pow(firstDimenVar+m.eps,0.5) ))\

* m.weight[0] + m.bias[0]

print(bacthnormone)輸出為:

輸入圖片:

tensor([[[[-2.4308, -1.0281, -1.1322, 0.9819], [-0.4069, 0.7973, 1.6296, 1.6797], [ 0.2802, -0.8285, 2.0101, 0.1286]], [[-0.5740, 0.1970, -0.7209, -0.7231], [-0.1489, 0.4993, 0.4159, 1.4238], [ 0.0334, -0.6333, 0.1308, -0.2180]]]])

歸一化權重:

Parameter containing: tensor([ 0.5653, 0.0322])

歸一化的偏重:

Parameter containing: tensor([ 0., 0.])

歸一化的輸出:

tensor([[[[-1.1237, -0.5106, -0.5561, 0.3679], [-0.2391, 0.2873, 0.6510, 0.6729], [ 0.0612, -0.4233, 0.8173, -0.0050]], [[-0.0293, 0.0120, -0.0372, -0.0373], [-0.0066, 0.0282, 0.0237, 0.0777], [ 0.0032, -0.0325, 0.0084, -0.0103]]]])

輸出的尺度:

torch.Size([1, 2, 3, 4])

輸入的第一個維度:

tensor([[-2.4308, -1.0281, -1.1322, 0.9819], [-0.4069, 0.7973, 1.6296, 1.6797], [ 0.2802, -0.8285, 2.0101, 0.1286]]) 1e-05

輸入的第一個維度平均值:

tensor(0.1401)

輸入的第一個維度方差:

tensor(1.6730) tensor(-1.1237)

結論:

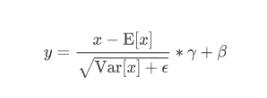

輸出的計算公式如下

注意torch中方差實現的方法是沒有使用Bessel's correction 貝塞爾校正的方差,所以在自己寫的方差中不要用錯了。

以上是“pytorch方法測試之歸一化BatchNorm2d的示例分析”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。