您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關clip gradient如何解決梯度爆炸的問題,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

1. 梯度爆炸的影響

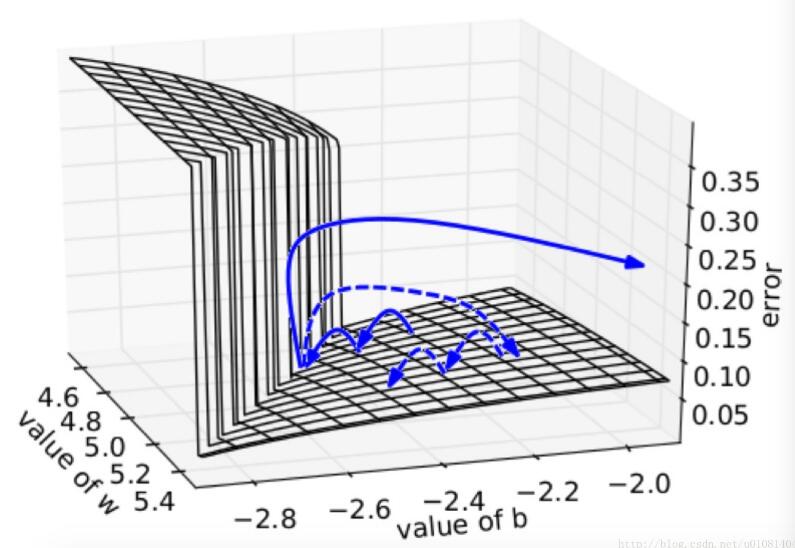

在一個只有一個隱藏節點的網絡中,損失函數和權值w偏置b構成error surface,其中有一堵墻,如下所示

損失函數每次迭代都是每次一小步,但是當遇到這堵墻時,在墻上的某點計算梯度,梯度會瞬間增大,指向某處不理想的位置。如果我們使用縮放,可以把誤導控制在可接受范圍內,如虛線箭頭所示

2. 解決梯度爆炸問題的方法

通常會使用一種叫”clip gradients “的方法. 它能有效地權重控制在一定范圍之內.

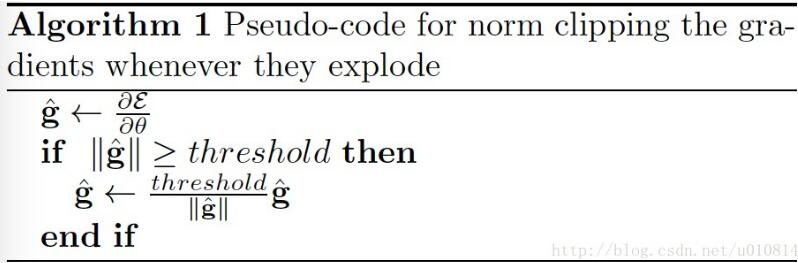

算法步驟如下。

首先設置一個梯度閾值:clip_gradient

在后向傳播中求出各參數的梯度,這里我們不直接使用梯度進去參數更新,我們求這些梯度的l2范數

然后比較梯度的l2范數||g||與clip_gradient的大小

如果前者大,求縮放因子clip_gradient/||g||, 由縮放因子可以看出梯度越大,則縮放因子越小,這樣便很好地控制了梯度的范圍

最后將梯度乘上縮放因子便得到最后所需的梯度

3. 有無clip_gradient在GRU模型中的結果比較

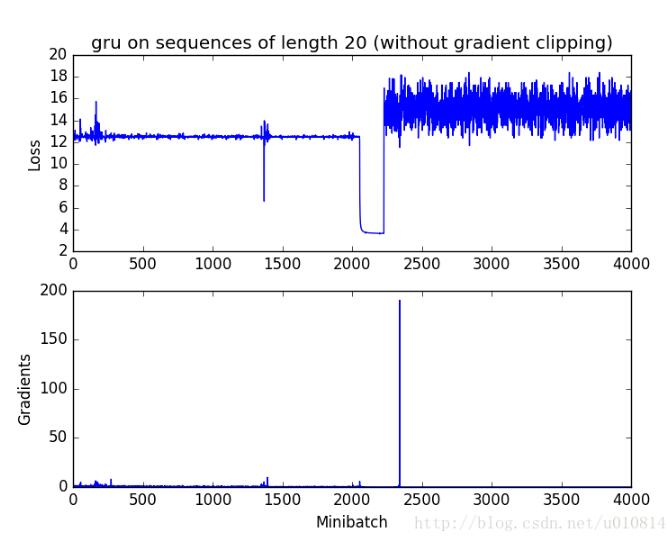

無clip_gradient

可以很清楚地發現在2000次迭代出發生了梯度爆炸,最終影響了訓練的效果。

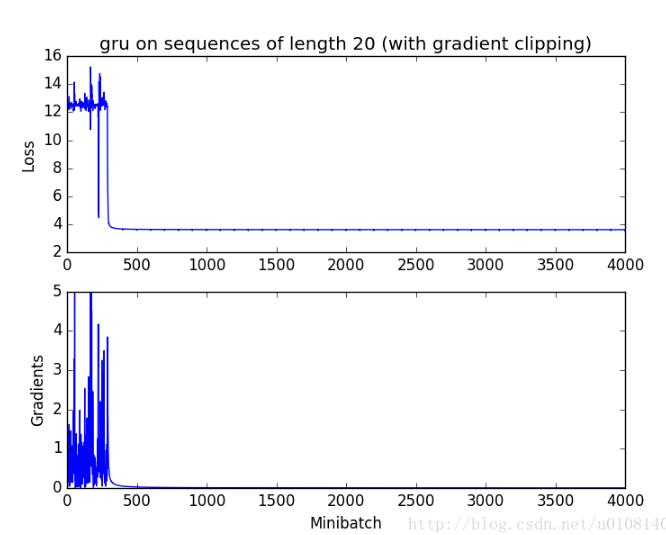

有clip_gradient

可以發現clip_gradient在前期有效了控制了梯度爆炸的影響,使得最終的loss能下降到滿意的結果

關于“clip gradient如何解決梯度爆炸的問題”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。