您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要講解了“怎么使用Python進行數據清洗”,文中的講解內容簡單清晰,易于學習與理解,下面請大家跟著小編的思路慢慢深入,一起來研究和學習“怎么使用Python進行數據清洗”吧!

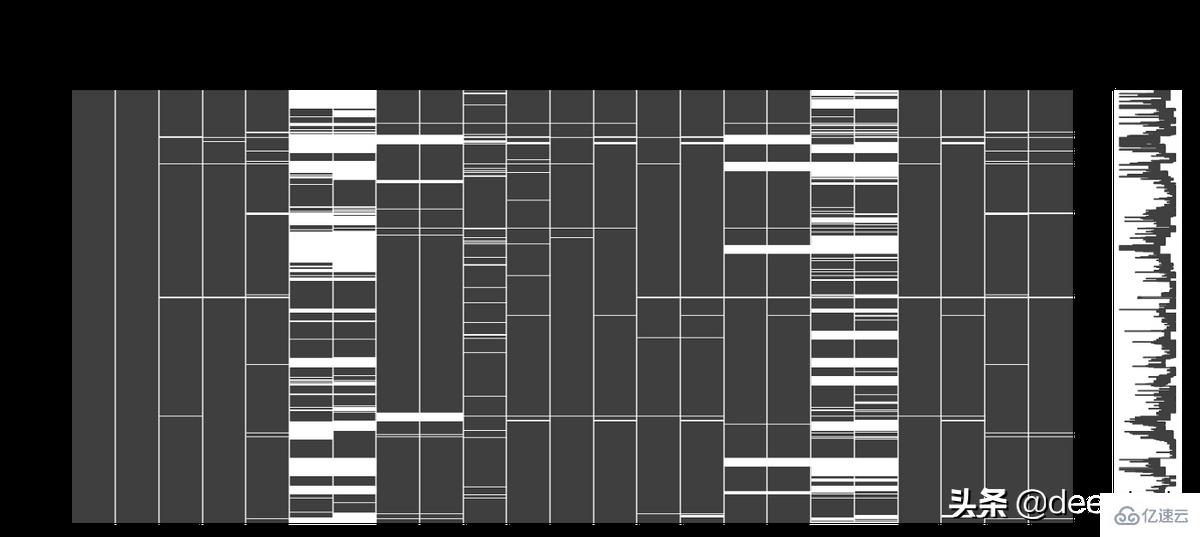

當數據集中包含缺失數據時,在填充之前可以先進行一些數據的分析。 因為空單元格本身的位置可以告訴我們一些有用的信息。 例如:

NA值僅在數據集的尾部或中間出現。 這意味著在數據收集過程中可能存在技術問題。 可能需要分析該特定樣本序列的數據收集過程,并嘗試找出問題的根源。

如果列NA數量超過 70–80%,可以刪除該列。

如果 NA 值在表單中作為可選問題的列中,則該列可以被額外的編碼為用戶回答(1)或未回答(0)。

missingno這個python庫就可以用于檢查上述情況,并且使用起來非常的簡單,例如下圖中的白線是 NA:

import missingno as msno msno.matrix(df)

對于缺失值的填補計算有很多方法,例如:

平均,中位數,眾數

kNN

零或常數等

不同的方法相互之間有優勢和不足,并且沒有適用于所有情況的“最佳”技術。具體可以參考我們以前發布的文章

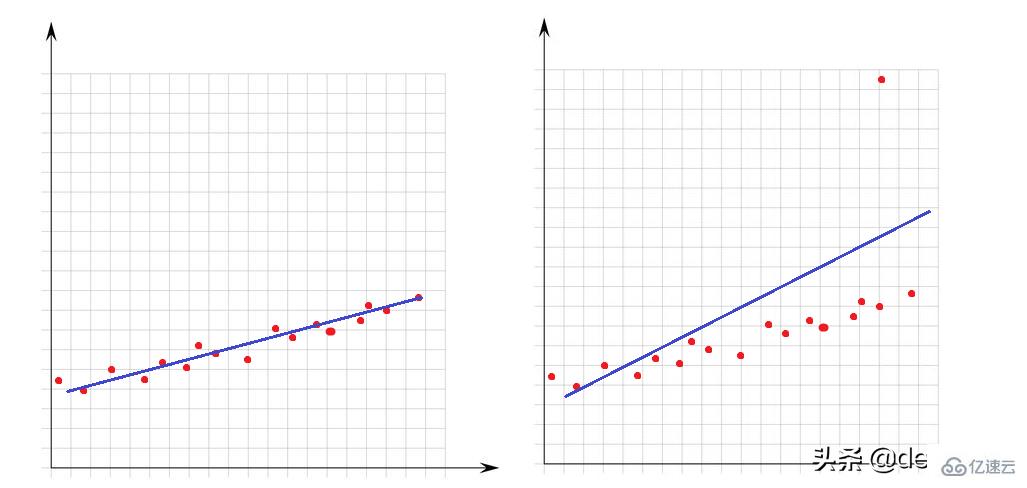

異常值是相對于數據集的其他點而言非常大或非常小的值。 它們的存在極大地影響了數學模型的性能。 讓我們看一下這個簡單的示例:

在左圖中沒有異常值,我們的線性模型非常適合數據點。 在右圖中有一個異常值,當模型試圖覆蓋數據集的所有點時,這個異常值的存在會改變模型的擬合方式,并且使我們的模型不適合至少一半的點。

對于異常值來說我們有必要介紹一下如何確定異常,這就要從數學角度明確什么是極大或極小。

大于Q3+1.5 x IQR或小于Q1-1.5 x IQR都可以作為異常值。 IQR(四分位距) 是 Q3 和 Q1 之間的差 (IQR = Q3-Q1)。

可以使用下面函數來檢查數據集中異常值的數量:

def number_of_outliers(df): df = df.select_dtypes(exclude = 'object') Q1 = df.quantile(0.25) Q3 = df.quantile(0.75) IQR = Q3 - Q1 return ((df < (Q1 - 1.5 * IQR)) | (df > (Q3 + 1.5 * IQR))).sum()

處理異常值的一種方法是可以讓它們等于 Q3 或 Q1。 下面的lower_upper_range 函數使用 pandas 和 numpy 庫查找其外部為異常值的范圍, 然后使用clip 函數將值裁剪到指定的范圍。

def lower_upper_range(datacolumn): sorted(datacolumn) Q1,Q3 = np.percentile(datacolumn , [25,75]) IQR = Q3 - Q1 lower_range = Q1 - (1.5 * IQR) upper_range = Q3 + (1.5 * IQR) return lower_range,upper_range for col in columns: lowerbound,upperbound = lower_upper_range(df[col]) df[col]=np.clip(df[col],a_min=lowerbound,a_max=upperbound)

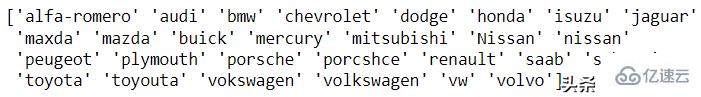

異常值問題是關于數字特征的,現在讓我們看看字符類型(分類)特征。 數據不一致意味著列的唯一類具有不同的表示形式。 例如在性別欄中,既有m/f,又有male/female。在這種情況下,就會有4個類,但實際上有兩類。

這種問題目前沒有自動處理的辦法,所以需要手動進行分析。 pandas 的unique函數就是為了這個分析準備的,下面看一個汽車品牌的例子:

df['CarName'] = df['CarName'].str.split().str[0] print(df['CarName'].unique())

maxda-mazda, Nissan-nissan, porcshce-porsche, toyouta-toyota等都可以進行合并。

df.loc[df['CarName'] == 'maxda', 'CarName'] = 'mazda' df.loc[df['CarName'] == 'Nissan', 'CarName'] = 'nissan' df.loc[df['CarName'] == 'porcshce', 'CarName'] = 'porsche' df.loc[df['CarName'] == 'toyouta', 'CarName'] = 'toyota' df.loc[df['CarName'] == 'vokswagen', 'CarName'] = 'volkswagen' df.loc[df['CarName'] == 'vw', 'CarName'] = 'volkswagen'

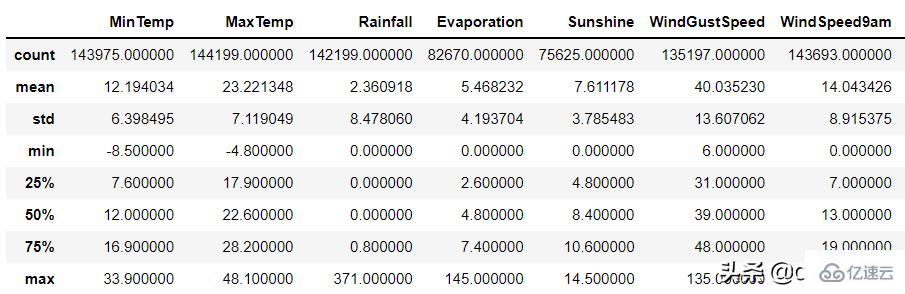

無效的數據表示在邏輯上根本不正確的值。 例如,

某人的年齡是 560;

某個操作花費了 -8 小時;

一個人的身高是1200 cm等;

對于數值列,pandas的 describe 函數可用于識別此類錯誤:

df.describe()

無效數據的產生原因可能有兩種:

1、數據收集錯誤:例如在輸入時沒有進行范圍的判斷,在輸入身高時錯誤的輸入了1799cm 而不是 179cm,但是程序沒有對數據的范圍進行判斷。

2、數據操作錯誤

數據集的某些列可能通過了一些函數的處理。 例如,一個函數根據生日計算年齡,但是這個函數出現了BUG導致輸出不正確。

以上兩種隨機錯誤都可以被視為空值并與其他 NA 一起估算。

當數據集中有相同的行時就會產生重復數據問題。 這可能是由于數據組合錯誤(來自多個來源的同一行),或者重復的操作(用戶可能會提交他或她的答案兩次)等引起的。 處理該問題的理想方法是刪除復制行。

可以使用 pandas duplicated 函數查看重復的數據:

df.loc[df.duplicated()]

在識別出重復的數據后可以使用pandas 的 drop_duplicate 函數將其刪除:

df.drop_duplicates()

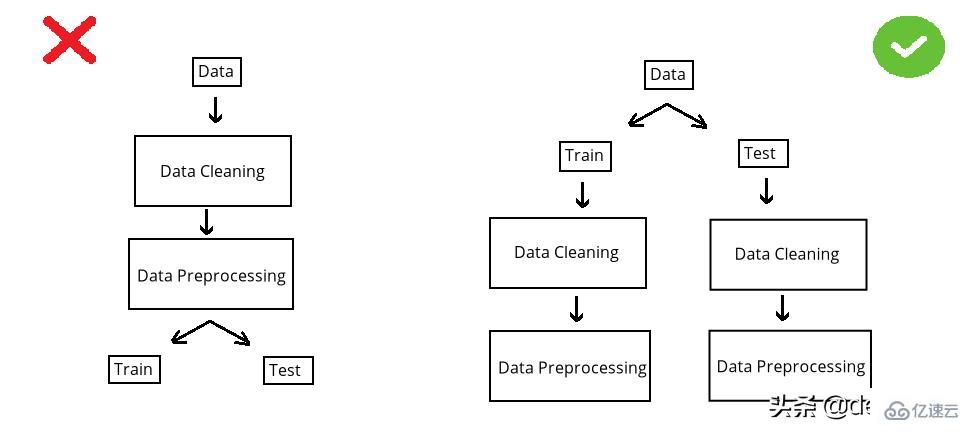

在構建模型之前,數據集被分成訓練集和測試集。 測試集是看不見的數據用于評估模型性能。 如果在數據清洗或數據預處理步驟中模型以某種方式“看到”了測試集,這個就被稱做數據泄漏(data leakage)。 所以應該在清洗和預處理步驟之前拆分數據:

以選擇缺失值插補為例。數值列中有 NA,采用均值法估算。在 split 前完成時,使用整個數據集的均值,但如果在 split 后完成,則使用分別訓練和測試的均值。

第一種情況的問題是,測試集中的推算值將與訓練集相關,因為平均值是整個數據集的。所以當模型用訓練集構建時,它也會“看到”測試集。但是我們拆分的目標是保持測試集完全獨立,并像使用新數據一樣使用它來進行性能評估。所以在操作之前必須拆分數據集。

雖然訓練集和測試集分別處理效率不高(因為相同的操作需要進行2次),但它可能是正確的。因為數據泄露問題非常重要,為了解決代碼重復編寫的問題,可以使用sklearn 庫的pipeline。簡單地說,pipeline就是將數據作為輸入發送到的所有操作步驟的組合,這樣我們只要設定好操作,無論是訓練集還是測試集,都可以使用相同的步驟進行處理,減少的代碼開發的同時還可以減少出錯的概率。

感謝各位的閱讀,以上就是“怎么使用Python進行數據清洗”的內容了,經過本文的學習后,相信大家對怎么使用Python進行數據清洗這一問題有了更深刻的體會,具體使用情況還需要大家實踐驗證。這里是億速云,小編將為大家推送更多相關知識點的文章,歡迎關注!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。