您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇“怎么用docker掛載NVIDIA顯卡運行pytorch”文章的知識點大部分人都不太理解,所以小編給大家總結了以下內容,內容詳細,步驟清晰,具有一定的借鑒價值,希望大家閱讀完這篇文章能有所收獲,下面我們一起來看看這篇“怎么用docker掛載NVIDIA顯卡運行pytorch”文章吧。

寫在前面:

安裝好centos、nvidia相關驅動及軟件、docker及加速鏡像。

主機運行環境

$ uname -a linux centos 3.10.0-514.26.2.el7.x86_64 #1 smp tue jul 4 15:04:05 utc 2017 x86_64 x86_64 x86_64 gnu/linux $ cat /usr/local/cuda/version.txt cuda version 8.0.61 $ cat /usr/local/cuda/include/cudnn.h | grep cudnn_major -a 2 #define cudnn_major 6 #define cudnn_minor 0 #define cudnn_patchlevel 21 #define cudnn_version (cudnn_major * 1000 + cudnn_minor * 100 + cudnn_patchlevel) #include "driver_types.h" # nvidia 1080ti

一、關于gpu的掛載

1. 在docker運行時指定device掛載

先查看一下有哪些相關設備

$ ls -la /dev | grep nvidia crw-rw-rw- 1 root root 195, 0 nov 15 13:41 nvidia0 crw-rw-rw- 1 root root 195, 1 nov 15 13:41 nvidia1 crw-rw-rw- 1 root root 195, 255 nov 15 13:41 nvidiactl crw-rw-rw- 1 root root 242, 0 nov 15 13:41 nvidia-uvm crw-rw-rw- 1 root root 242, 1 nov 15 13:41 nvidia-uvm-tools

電腦上裝了兩個顯卡。我需要運行pytorch,dockerhub中pytorch官方鏡像沒有gpu支持,所以只能先pull一個anaconda鏡像試試,后面可以編排成dockerfile。

$ docker run -it -d --rm --name pytorch -v /home/qiyafei/pytorch:/mnt/home --privileged=true --device /dev/nvidia-uvm:/dev/nvidia-uvm --device /dev/nvidia1:/dev/nvidia1 --device /dev/nvidiactl:/dev/nvidiactl okwrtdsh/anaconda3 bash

okwrtdsh的鏡像似乎是針對他們實驗室gpu環境的,有點過大了,不過勉強運行一下還是可以的。在容器內部還需要

安裝pytorch:

$ conda install pytorch torchvision -c pytorch

這里運行torch成功,但是加載顯卡失敗了,可能還是因為驅動不匹配的原因吧,需要重新安裝驅動,暫時不做此嘗試;

二、通過nvidia-docker在docker內使用顯卡

(1)安裝nvidia-docker

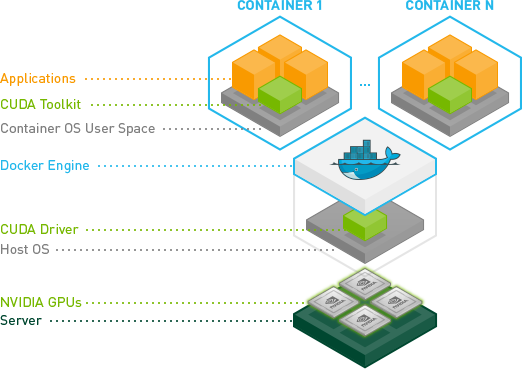

nvidia-docker其實是docker引擎的一個應用插件,專門面向nvidia gpu,因為docker引擎是不支持nvidia驅動的,安裝插件后可以在用戶層上直接使用cuda。具體看上圖。這個圖很形象,docker引擎的運行機制也表現出來了,就是在系統內核之上通過cgroup和namespace虛擬出一個容器os的用戶空間,我不清楚這是否運行在ring0上,但是cuda和應用確實可以使用了(虛擬化的問題,如果關心此類問題可以了解一些關于docker、kvm等等虛擬化的實現方式,目前是系統類比較火熱的話題)

這里也可以通過添加apt或者yum sourcelist的方式進行安裝,但是我沒有root權限,而且update容易引起docker重啟,如果不是實驗室的個人環境不推薦這么做,防止破壞別人正在運行的程序(之前公司一個小伙子就是在阿里云上進行了yum update,結果導致公司部分業務停了一個上午)。

$ sudo rpm -i nvidia-docker-1.0.1-1.x86_64.rpm && rm nvidia-docker-1.0.1-1.x86_64.rpm $ sudo systemctl start nvidia-docker

(2)容器測試

我們還需要nvidia官方提供的docker容器nvidia/cuda,里面已經編譯安裝了cuda和cudnn,或者直接run,缺少image的會自動pull。

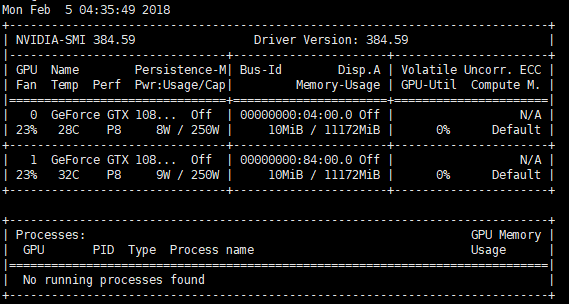

$ docker pull nvidia/cuda $ nvidia-docker run --rm nvidia/cuda nvidia-smi

在容器內測試是可以成功使用nvidia顯卡的:

(3)合適的鏡像或者自制dockerfile

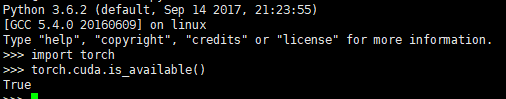

合適的鏡像:這里推薦floydhub的pytorch,注意對應的cuda和cudnn版本。

docker pull floydhub/pytorch:0.3.0-gpu.cuda8cudnn6-py3.22 nvidia-docker run -ti -d --rm floydhub/pytorch:0.3.0-gpu.cuda8cudnn6-py3.22 bash

自制dockerfile

首先,我們需要把要裝的東西想清楚:

1. 基礎鏡像肯定是nvidia官方提供的啦,最省事,不用裝cuda和cudnn了;

2. vim、git、lrzsz、ssh這些肯定要啦;

3. anaconda、pytorch肯定要啦;

所以需要準備好國內源source.list,否則安裝速度很慢。

deb-src http://archive.ubuntu.com/ubuntu xenial main restricted #added by software-properties deb http://mirrors.aliyun.com/ubuntu/ xenial main restricted deb-src http://mirrors.aliyun.com/ubuntu/ xenial main restricted multiverse universe #added by software-properties deb http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricted deb-src http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricted multiverse universe #added by software-properties deb http://mirrors.aliyun.com/ubuntu/ xenial universe deb http://mirrors.aliyun.com/ubuntu/ xenial-updates universe deb http://mirrors.aliyun.com/ubuntu/ xenial multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-updates multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiverse #added by software-properties deb http://archive.canonical.com/ubuntu xenial partner deb-src http://archive.canonical.com/ubuntu xenial partner deb http://mirrors.aliyun.com/ubuntu/ xenial-security main restricted deb-src http://mirrors.aliyun.com/ubuntu/ xenial-security main restricted multiverse universe #added by software-properties deb http://mirrors.aliyun.com/ubuntu/ xenial-security universe deb http://mirrors.aliyun.com/ubuntu/ xenial-security multiverse

下載anaconda的地址:https://repo.continuum.io/archive/anaconda3-5.0.1-linux-x86_64.sh,這里直接在dockerfile里下了,具體如下:

$ vim dockerfile

from nvidia/cuda

label author="qyf"

env pythonioencoding=utf-8

run mv /etc/apt/sources.list /etc/apt/sources.list.bak

add $pwd/sources.list /etc/apt/sources.list

run apt-get update --fix-missing && \

apt-get install -y vim net-tools curl wget git bzip2 ca-certificates libglib2.0-0 libxext6 libsm6 libxrender1 mercurial subversion apt-transport-https software-properties-common

run apt-get install -y openssh-server -y

run echo 'root:passwd' | chpasswd

run sed -i 's/permitrootlogin prohibit-password/permitrootlogin yes/' /etc/ssh/sshd_config

run sed -i 's/#passwordauthentication yes/passwordauthentication yes/' /etc/ssh/sshd_config

run echo 'export path=/opt/conda/bin:$path' > /etc/profile.d/conda.sh && wget --quiet https://repo.continuum.io/archive/anaconda3-5.0.1-linux-x86_64.sh -o ~/anaconda.sh && /bin/bash ~/anaconda.sh -b -p /opt/conda && rm ~/anaconda.sh

run apt-get install -y grep sed dpkg && \

tini_version=`curl https://github.com/krallin/tini/releases/latest | grep -o "/v.*\"" | sed 's:^..\(.*\).$:\1:'` && \

curl -l "https://github.com/krallin/tini/releases/download/v${tini_version}/tini_${tini_version}.deb"; > tini.deb && \

dpkg -i tini.deb && \

rm tini.deb && \

apt-get clean

env path /opt/conda/bin:$path

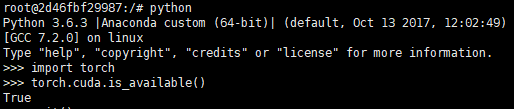

run conda install pytorch torchvision -c pytorch -y

entrypoint [ "/usr/bin/tini", "--" ]

cmd [ "/bin/bash" ]通過docker build構造鏡像:

docker build -t pytorch/cuda8 ./

運行成功調用cuda。

以上就是關于“怎么用docker掛載NVIDIA顯卡運行pytorch”這篇文章的內容,相信大家都有了一定的了解,希望小編分享的內容對大家有幫助,若想了解更多相關的知識內容,請關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。