您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關大數據機器學習中的過擬合與解決辦法,文章內容質量較高,因此小編分享給大家做個參考,希望大家閱讀完這篇文章后對相關知識有一定的了解。

什么是過擬合

對于機器學習項目而言,過擬合(overfitting)這個問題一般都會遇到。什么是過擬合呢?

維基百科:

在統計學中,過擬合現象是指在擬合一個統計模型時,使用過多參數。對比于可獲取的數據總量來說,一個荒謬的模型只要足夠復雜,是可以完美地適應數據。過擬合一般可以視為違反奧卡姆剃刀原則。當可選擇的參數的自由度超過數據所包含信息內容時,這會導致最后(擬合后)模型使用任意的參數,這會減少或破壞模型一般化的能力更甚于適應數據。過擬合的可能性不只取決于參數個數和數據,也跟模型架構與數據的一致性有關。此外對比于數據中預期的噪聲或錯誤數量,跟模型錯誤的數量也有關。

過擬合現象的觀念對機器學習也是很重要的。通常一個學習算法是借由訓練示例來訓練的。亦即預期結果的示例是可知的。而學習者則被認為須達到可以預測出其它示例的正確的結果,因此,應適用于一般化的情況而非只是訓練時所使用的現有數據(根據它的歸納偏向)。然而,學習者卻會去適應訓練數據中太特化但又隨機的特征,特別是在當學習過程太久或示例太少時。在過擬合的過程中,當預測訓練示例結果的表現增加時,應用在未知數據的表現則變更差。

相對于過擬合是指,使用過多參數,以致太適應數據而非一般情況,另一種常見的現象是使用太少參數,以致于不適應數據,這則稱為欠擬合(underfitting),或稱:擬合不足現象。

這里不展開說明欠擬合現象,后續補上。總的來說,是學習得過頭了,死記硬背的那種學習,對于訓練數據預測得非常準確,但當遇到新的問題時候,泛化能力不行,無法作出正確的預測。

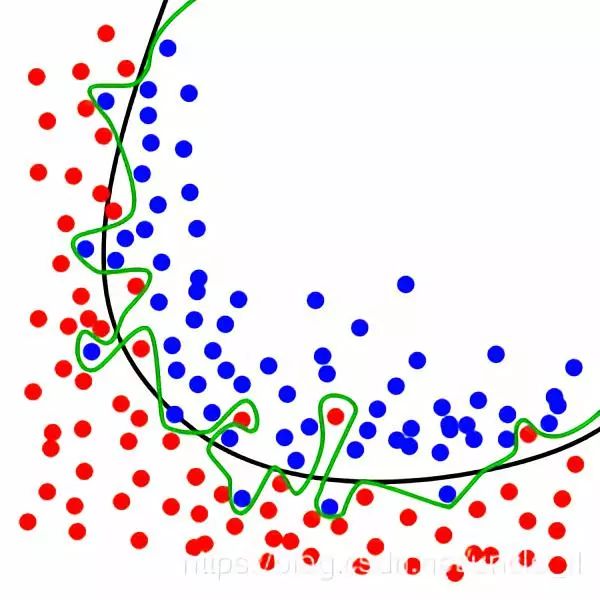

綠線代表過擬合模型,黑線代表正則化模型。雖然綠線完美的匹配訓練數據,但太過依賴,并且與黑線相比,對于新的測試數據上具有更高的錯誤率。

知乎

知乎上有個帖子:用簡單易懂的語言描述「過擬合 overfitting」?

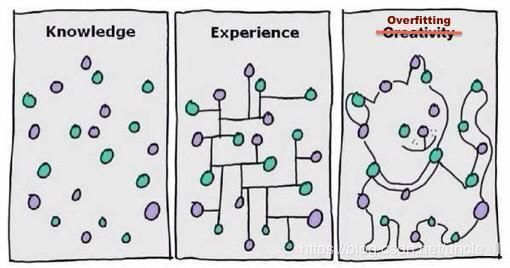

過擬合其實就是一種機器學習沒找到正確的規律情況,所以要搞懂什么是過擬合首先得搞懂為什么機器學習能找出正確規律。

具體情況

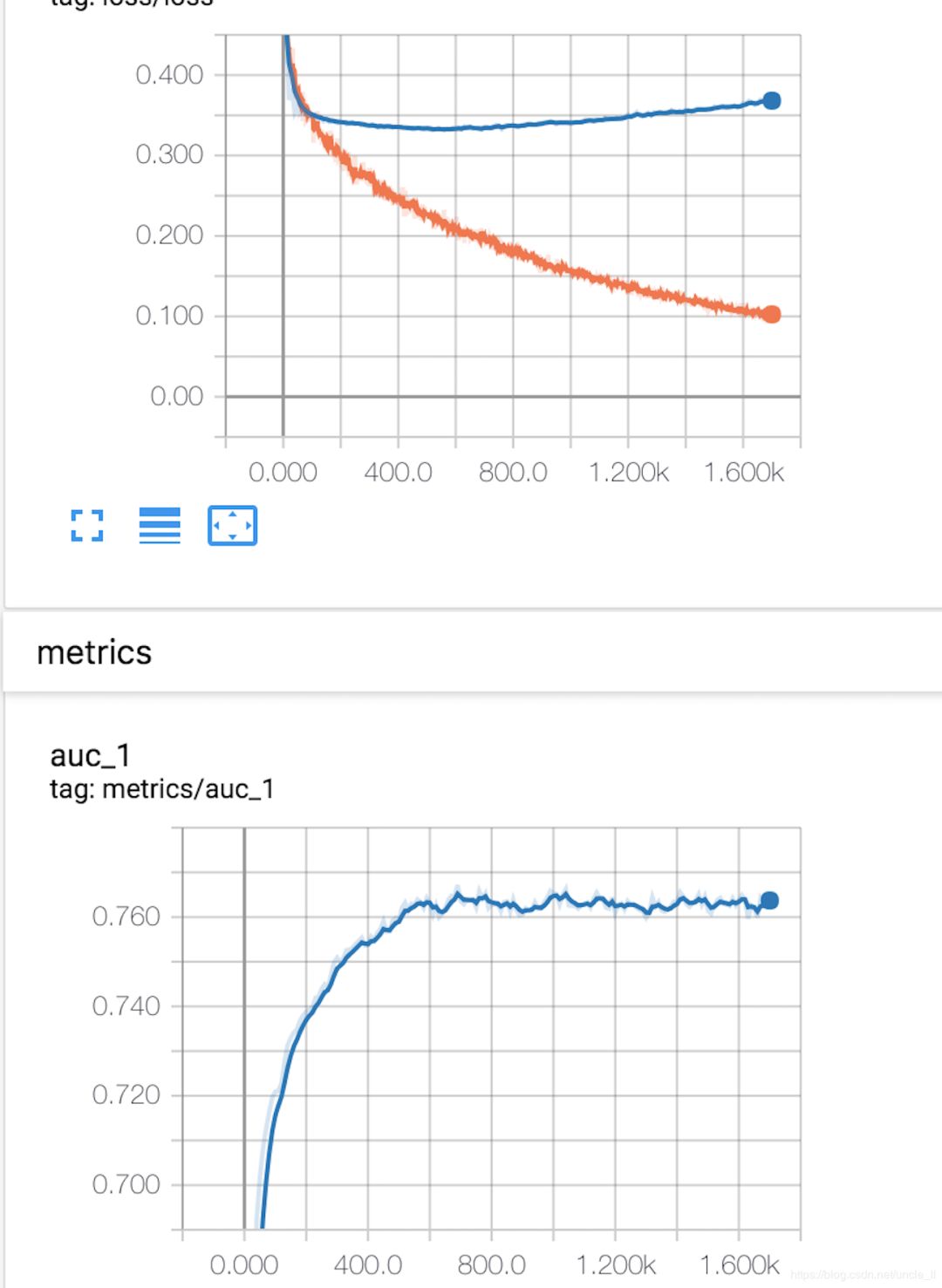

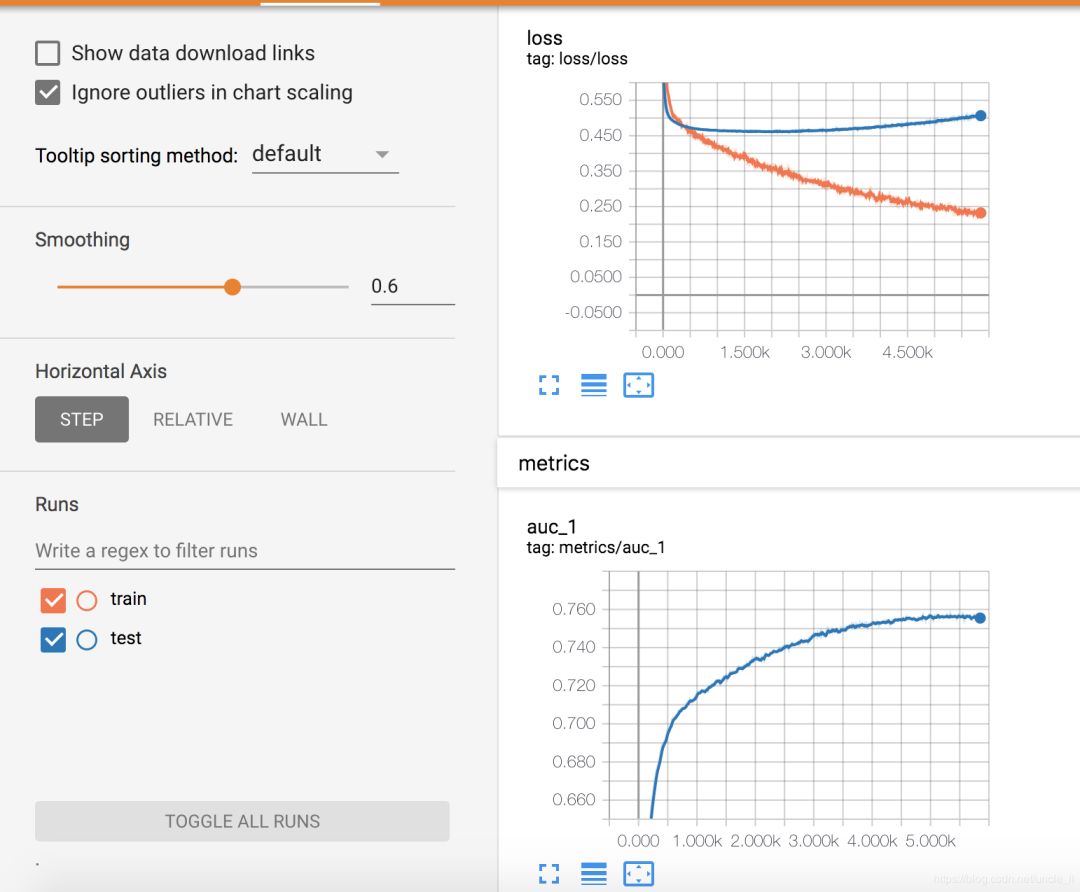

實際中遇到的問題,訓練和測試曲線如下:

可以看到訓練損失一直下降,但測試損失先下降后上升。

解決辦法

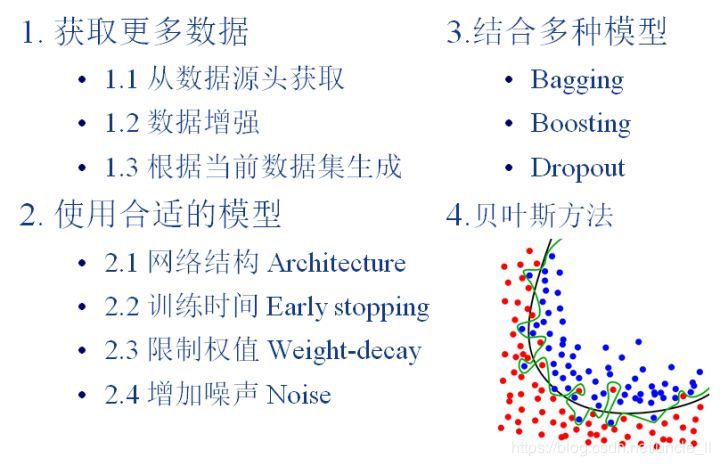

在統計和機器學習中,為了避免過擬合現象,須要使用額外的技巧,以指出何時會有更多訓練而沒有導致更好的一般化。具體有以下幾種方法:

獲取更多數據;

使用合適的模型;

結合多種模型;

貝葉斯方法;

增大訓練數據后,加入earlystopping,曲線稍微好點。

關于大數據機器學習中的過擬合與解決辦法就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。