您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要為大家展示了“如何永久自定義hive函數”,內容簡而易懂,條理清晰,希望能夠幫助大家解決疑惑,下面讓小編帶領大家一起研究并學習一下“如何永久自定義hive函數”這篇文章吧。

有一些函數是比較基礎的,公用的,每次都要create temporary function麻煩了,這樣的基礎函數需要直接集成到hive中去,避免每次都要創建。

本人擁有一個賬戶zb_test

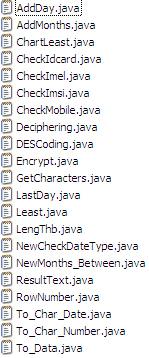

自定義的函數已經準備好

把CLASSPATH改成如下:

export CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$SQOOP_HOME/lib:/opt/boh-2.0.0/hadoop/share/hadoop/

tools/lib/*:/opt/boh-2.0.0/hadoop/share/hadoop/common/lib/*:/opt/boh-2.0.0/hadoop/share/hadoop/common/*:/opt/boh-2.0.0/hive/li

b/*:$CLASSPATH(目的是自己編譯的時候要用到)

解壓,找到hive-exec-0.12.0-cdh6.0.0.jar包(hive函數跟這個有關),再解壓。

jar -xvf XXX.jar

編譯自定義函數的java文件,比如放在utf下

Javac ./utf/*

產生.class文件,放到abc目錄下。

把.class文件打成jar包

Jar -cvf ./hello.jar ./abc/*

產生一個jar包,叫hello.jar

把jar包放到/data/zb_test/目錄下

然后修改/data/zb_test/.bashrc文件的:

export CLASSPATH=/data/zb_test/hello.jar:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$SQOOP_HOME/lib:/opt/boh-2.0.0/hadoop/share/hadoop/tools/lib/*:/opt/boh-2.0.0/hadoop/share/hadoop/common/lib/*:/opt/boh-2.0.0/hadoop/share/hadoop/common/*:/opt/boh-2.0.0/hive/lib/*:$CLASSPATH(為了測試用的)

將函數test注冊到hive的函數列表中

修改$HIVE_HOME/src/ql/src/java/org/apache/hadoop/hive/ql/exec/FunctionRegistry.java文件

import org.apache.hadoop.hive.ql.udf.UDFTest;

registerUDF(“test”, UDFTest.class,false);

1:把剛剛產生的所有的.class文件都放到修改$HIVE_HOME/src/ql/src/java/org/apache/hadoop/hive/ql/udf下面

2:然后編譯FunctionRegistry.java文件:編譯通過以后,我們找到hive-exec-0.12.0-cdh6.0.0.jar里面的$HIVE_HOME/src/ql/src/java/org/apache/hadoop/hive/ql/exec/FunctionRegistry.class文件,我們把替換了。

這些路徑都是在hive-exec-0.12.0-cdh6.0.0.jar解壓后的org的路徑下的。

其實把這兩個步驟做了以后,重新把剛剛解壓的hive-exec-0.12.0-cdh6.0.0.jar打成jar包,替換了hive里的,就可以了。

以上是“如何永久自定義hive函數”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。