您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“怎么啟動并驗證Hadoop分布式集群”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

在SparkWorker1和SparkWorker2上完成和SparkMaster同樣的Hadoop 2.2.0操作,建議使用SCP命令把SparkMaster上安裝和配置的Hadoop的各項內容拷貝到SparkWorker1和SparkWorker2上;

啟動并驗證Hadoop分布式集群

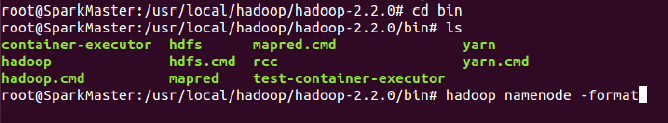

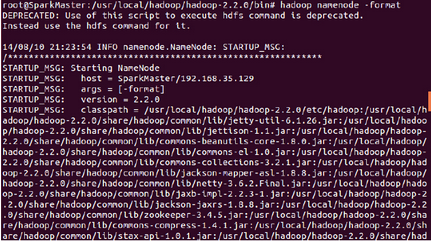

第一步:格式化hdfs文件系統:

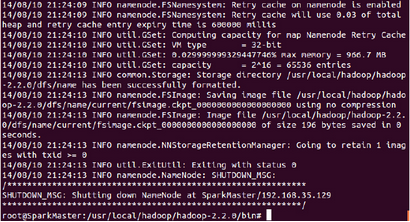

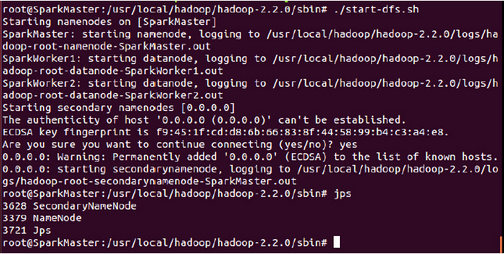

第二步:進入sbin中啟動hdfs,執行如下命令:

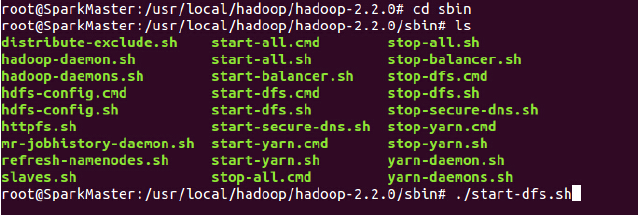

啟動過程如下:

此時我們發現在SparkMaster上啟動了NameNode和SecondaryNameNode;

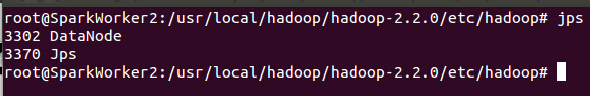

在SparkWorker1和SparkWorker2上均啟動了DataNode:

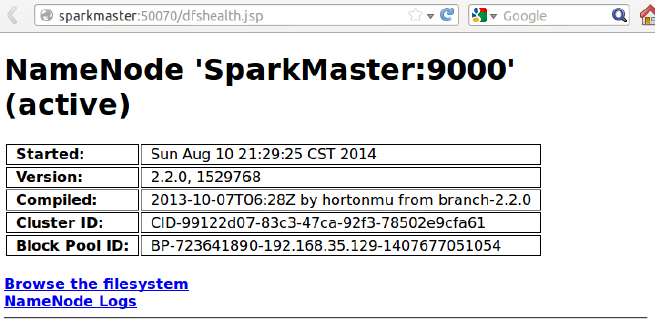

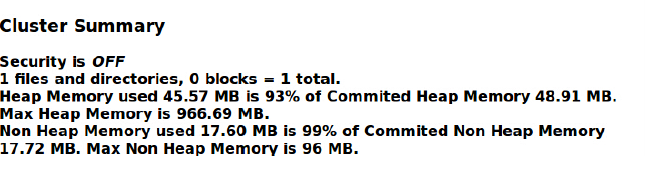

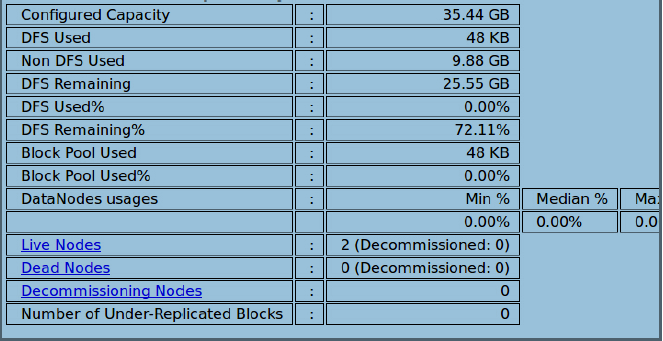

此時訪問http://SparkMaster:50070 登錄Web控制可以查看HDFS集群的狀況:

“怎么啟動并驗證Hadoop分布式集群”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。