您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹“Flink實時計算大促壓測的方法是什么”,在日常操作中,相信很多人在Flink實時計算大促壓測的方法是什么問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”Flink實時計算大促壓測的方法是什么”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

一、背景:

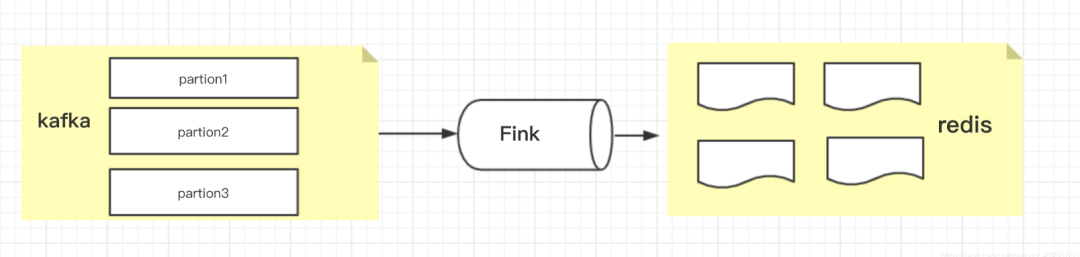

臨近雙11大促,為避免流量峰值較高,電商公司都會對系統進行壓測。一直做實時數據計算,應用是基于Flink做的,接收kafka消息,進行數據統計,包括:pv、uv、dau、單量、成交額等等。

為了保證應用在大促期間不出問題,需要進行實時計算程序進行壓測。由于統計的數據分為兩類(流量數據、訂單數據),對這兩類數據進行不同方式的壓測。

二、壓測準備

(1)壓測時間選擇:一般選擇在凌晨,對業務影響最小

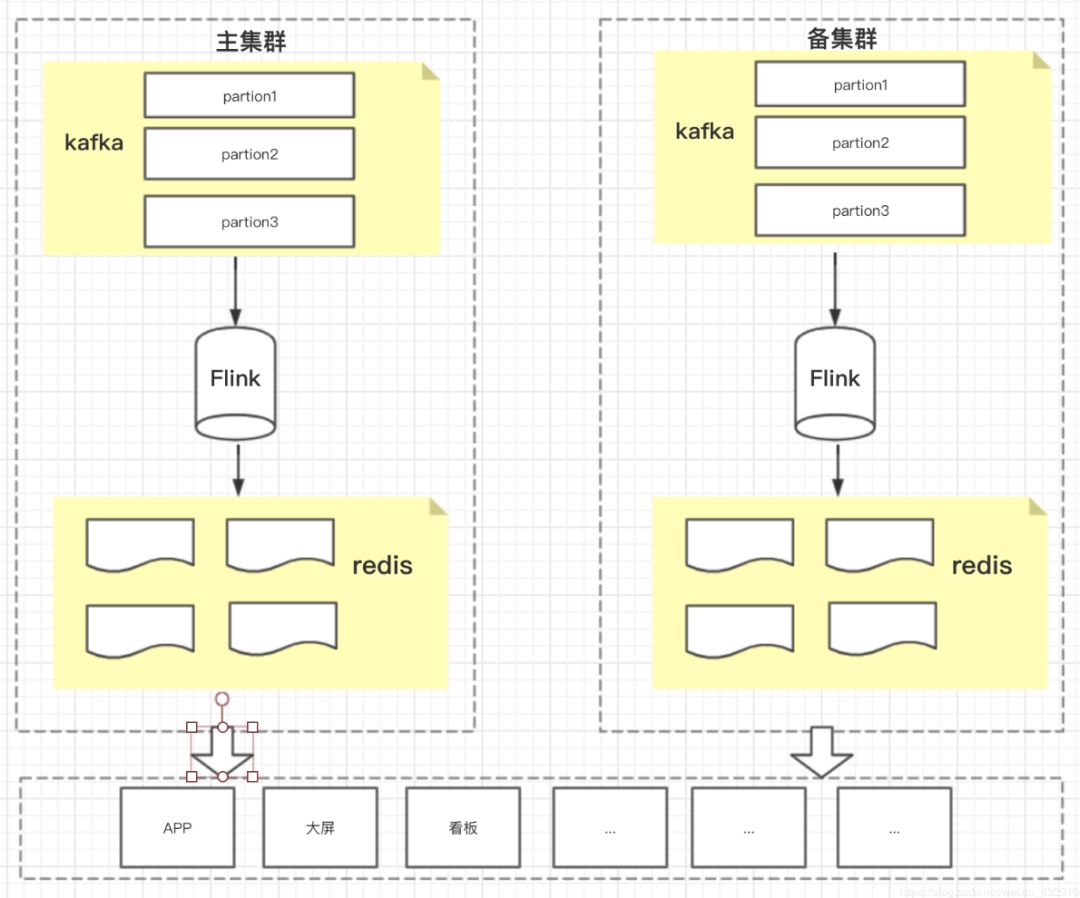

(2)集群準備:搭建主備集群,將kafka集群、Flink集群、redis集群,分別搭建兩套,在資源有充裕的情況下。(主備集群既能夠做到容災、高可用,也能在壓測過程,輕松實現壓測)

(3)如果資源有限,不能搭建主備集群,也能進行壓測,但是在災備和高可用方面就沒辦法保證了

三、壓測實踐

情況一:有主備集群的情況下(壓測比較簡單)

(1)通知下游,將查詢的數據切換另外一套集群上(不進行壓測的集群)

(2)將kafka消息位點進行調整,將消息擠壓量調整至去年大促的峰值的幾倍左右

(3)重啟Flink應用

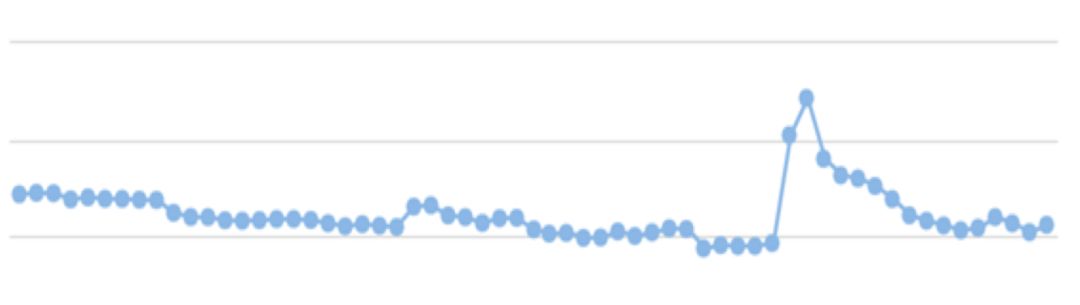

(4)查看監控:kafka監控、Flink監控

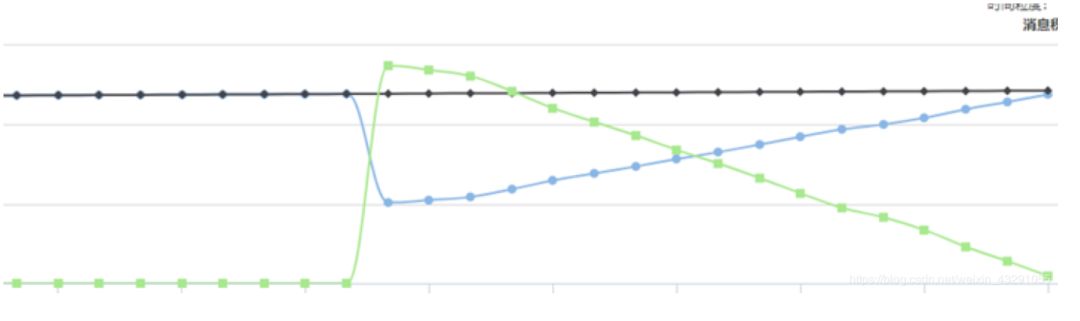

kafka消息擠壓監控

Flink數據處理監控

情況二:沒有主備集群的情況下(由于沒有主備集群,壓測可能會對下游統計數據存在影響,需要通知下游)

1.流量數據壓測(由于數據量較大不好做冪等處理,對下游影響較大)

(1)通知下游,將壓測安排在凌晨進行

(2)停止Flink應用,造成消息擠壓,達到擠壓數量

(3)啟動Flink應用,開始消費,查看各項監控指標

注:沒有采用回置kafka消息位點,而是進行憋數,只造成短時間下游數據指標短時間不可用,整體影響不大

2.訂單數據壓測

沒有冪等處理,同樣可以采用流量的方法進行壓測

有冪等處理

(1)通知下游,進行壓測

(2)回置kafka消息位點

(3)重啟Flink應用,開始消費,查看各項監控指標

注:由于冪等處理,回置位點,不會對下游統計數據造成影響

到此,關于“Flink實時計算大促壓測的方法是什么”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。