溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹Spark如何在Windows本地接入Hive,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

PS:確認Hive服務是否啟動,進入到Hive服務器進行以下操作 1.先開啟 metastore hive --service metastore & 2.開啟hiveserver2,默認端口是10000 hive --service hiveserver2 & 3.驗證是否開啟成功 netstat -ntulp | grep 10000 輸出:tcp 0 0 0.0.0.0:10000 0.0.0.0:* LISTEN 27799/java 即為服務開啟成功

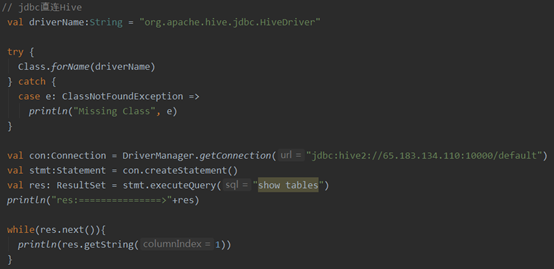

代碼實現

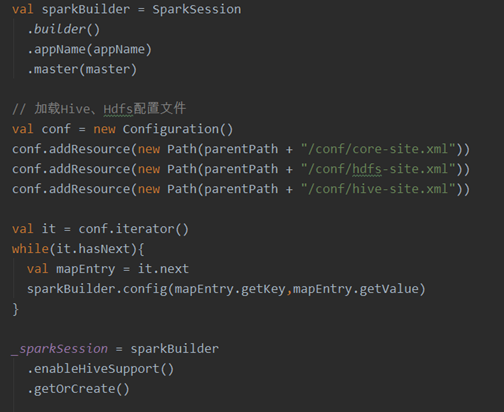

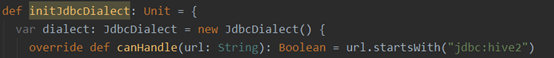

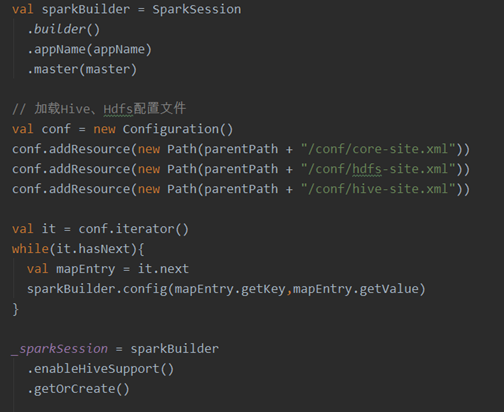

初始化并創建Sparksession,代碼實現

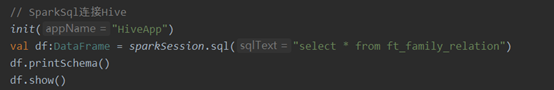

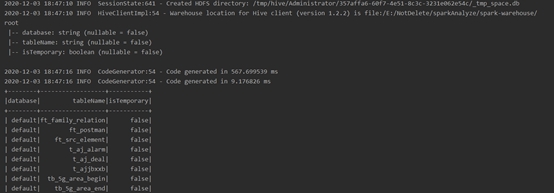

使用Sparksession查詢

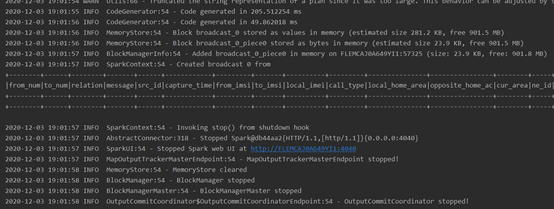

查詢結果

注:連接Hive無需初始化聲明注冊方言

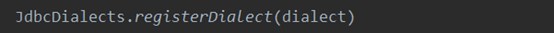

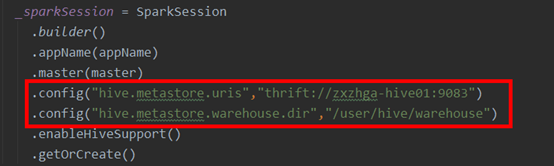

特別注意,若不加載hive-site.xml時,需在config中配置:

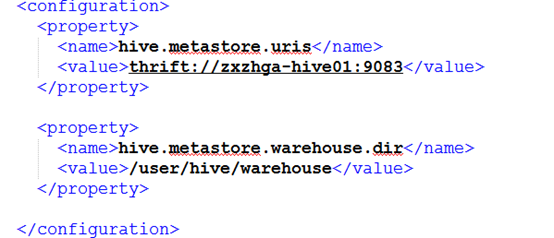

此配置來源于Hive服務器conf/hive-site.xml中配置項

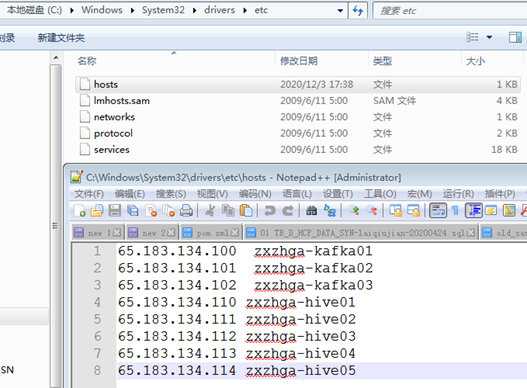

本地還需配置hosts

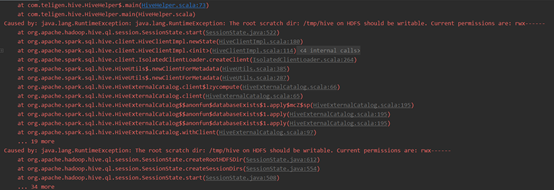

異常1:Caused by: java.lang.RuntimeException: The root scratch dir: /tmp/hive on HDFS should be writable. Current permissions are: rwx------

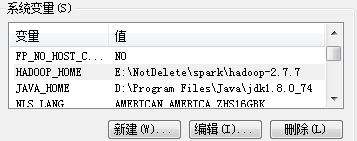

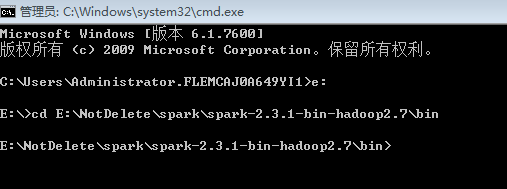

解決方式: 1.配置Hadoop本地環境變量

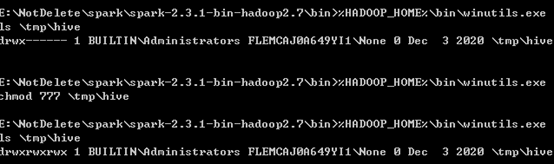

2.打開cmd命令窗口,進入到本地spark-2.3.1-bin-hadoop2.7\bin目錄

3.運行以下3條命令 %HADOOP_HOME%\bin\winutils.exe ls \tmp\hive %HADOOP_HOME%\bin\winutils.exe chmod 777 \tmp\hive %HADOOP_HOME%\bin\winutils.exe ls \tmp\hive

4.驗證效果

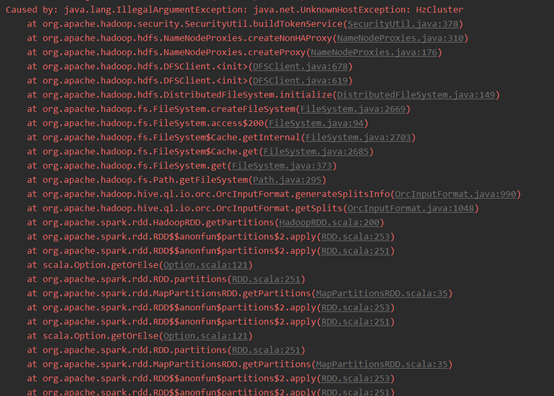

異常2:Caused by: java.lang.IllegalArgumentException: java.net.UnknownHostException: HzCluster

原因:本地Spark連接Hive集群時未能發現Hadoop集群,需裝載hdfs配置。

解決方式:

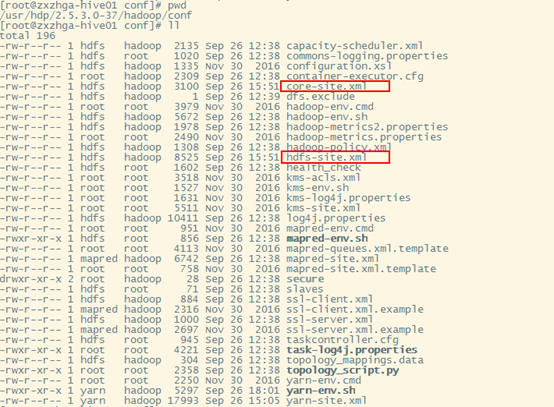

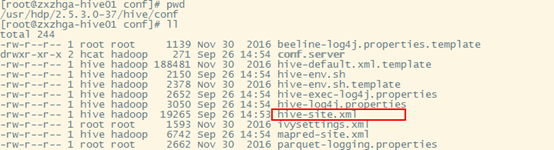

1.拷貝hadoop/conf目錄下的core-site.xml和hdfs-site.xml文件到項目${path}/conf目錄下

2.拷貝hive/conf目錄下的hive-site.xml文件到項目${path}/conf目錄下

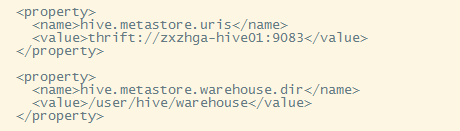

[重要]修改hive-site.xml文件內容,僅保留以下配置

3.初始化Sparksession時裝載Hive、Hdfs的配置文件

以上是“Spark如何在Windows本地接入Hive”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。