您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關如何使用tke-autoscaling-placeholder實現秒級彈性伸縮,文章內容質量較高,因此小編分享給大家做個參考,希望大家閱讀完這篇文章后對相關知識有一定的了解。

當 TKE 集群配置了節點池并啟用了彈性伸縮,在節點資源不夠時可以觸發節點的自動擴容 (自動買機器并加入集群),但這個擴容流程需要一定的時間才能完成,在一些流量突高的場景,這個擴容速度可能會顯得太慢,影響業務。 tke-autoscaling-placeholder 可以用于在 TKE 上實現秒級伸縮,應對這種流量突高的場景。

tke-autoscaling-placeholder 實際就是利用低優先級的 Pod 對資源進行提前占位(帶 request 的 pause 容器,實際不怎么消耗資源),為一些可能會出現流量突高的高優先級業務預留部分資源作為緩沖,當需要擴容 Pod 時,高優先級的 Pod 就可以快速搶占低優先級 Pod 的資源進行調度,而低優先級的 tke-autoscaling-placeholder 的 Pod 則會被 "擠走",狀態變成 Pending,如果配置了節點池并啟用彈性伸縮,就會觸發節點的擴容。這樣,由于有了一些資源作為緩沖,即使節點擴容慢,也能保證一些 Pod 能夠快速擴容并調度上,實現秒級伸縮。要調整預留的緩沖資源多少,可根據實際需求調整 tke-autoscaling-placeholder的 request 或副本數。

使用該應用要求集群版本在 1.18 以上。

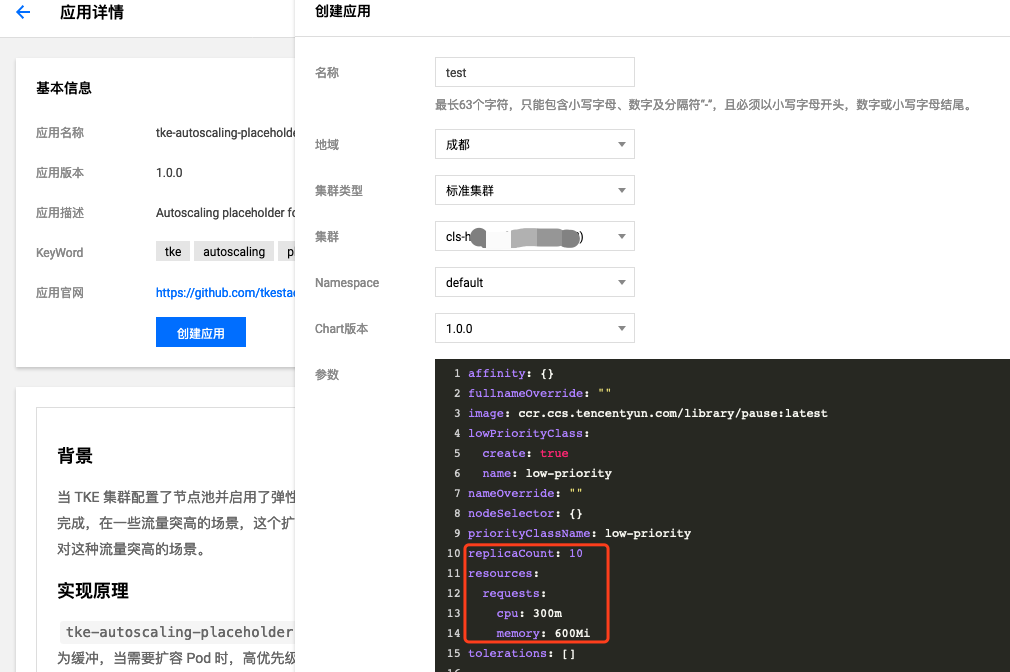

在應用市場找到 tke-autoscaling-placeholder,點擊進入應用詳情,再點 創建應用:

選擇要部署的集群 id 與 namespace,應用的配置參數中最重要的是 replicaCount 與 resources.request,分別表示 tke-autoscaling-placeholder 的副本數與每個副本占位的資源大小,它們共同決定緩沖資源的大小,可以根據流量突高需要的額外資源量來估算進行設置。

最后點擊創建,你可以查看這些進行資源占位的 Pod 是否啟動成功:

$ kubectl get pod -n default tke-autoscaling-placeholder-b58fd9d5d-2p6ww 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-55jw7 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-6rq9r 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-7c95t 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-bfg8r 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-cfqt6 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-gmfmr 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-grwlh 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-ph7vl 1/1 Running 0 8s tke-autoscaling-placeholder-b58fd9d5d-xmrmv 1/1 Running 0 8s

tke-autoscaling-placeholder 的完整配置參考下面的表格:

| 參數 | 描述 | 默認值 |

|---|---|---|

replicaCount | placeholder 的副本數 | 10 |

image | placeholder 的鏡像地址 | ccr.ccs.tencentyun.com/library/pause:latest |

resources.requests.cpu | 單個 placeholder 副本占位的 cpu 資源大小 | 300m |

resources.requests.memory | 單個 placeholder 副本占位的內存大小 | 600Mi |

lowPriorityClass.create | 是否創建低優先級的 PriorityClass (用于被 placeholder 引用) | true |

lowPriorityClass.name | 低優先級的 PriorityClass 的名稱 | low-priority |

nodeSelector | 指定 placeholder 被調度到帶有特定 label 的節點 | {} |

tolerations | 指定 placeholder 要容忍的污點 | [] |

affinity | 指定 placeholder 的親和性配置 | {} |

tke-autoscaling-placeholder 的優先級很低,我們的業務 Pod 可以指定一個高優先的 PriorityClass,方便搶占資源實現快速擴容,如果沒有可以先創建一個:

apiVersion: scheduling.k8s.io/v1 kind: PriorityClass metadata: name: high-priority value: 1000000 globalDefault: false description: "high priority class"

在我們的業務 Pod 中指定 priorityClassName 為高優先的 PriorityClass:

apiVersion: apps/v1 kind: Deployment metadata: name: nginx spec: replicas: 8 selector: matchLabels: app: nginx template: metadata: labels: app: nginx spec: priorityClassName: high-priority # 這里指定高優先的 PriorityClass containers: - name: nginx image: nginx resources: requests: cpu: 400m memory: 800Mi

當集群節點資源不夠,擴容出來的高優先級業務 Pod 就可以將低優先級的 tke-autoscaling-placeholder 的 Pod 資源搶占過來并調度上,然后 tke-autoscaling-placeholder 的 Pod 再 Pending:

$ kubectl get pod -n default NAME READY STATUS RESTARTS AGE nginx-bf79bbc8b-5kxcw 1/1 Running 0 23s

關于如何使用tke-autoscaling-placeholder實現秒級彈性伸縮就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。