溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

scrapydweb.herokuapp.com

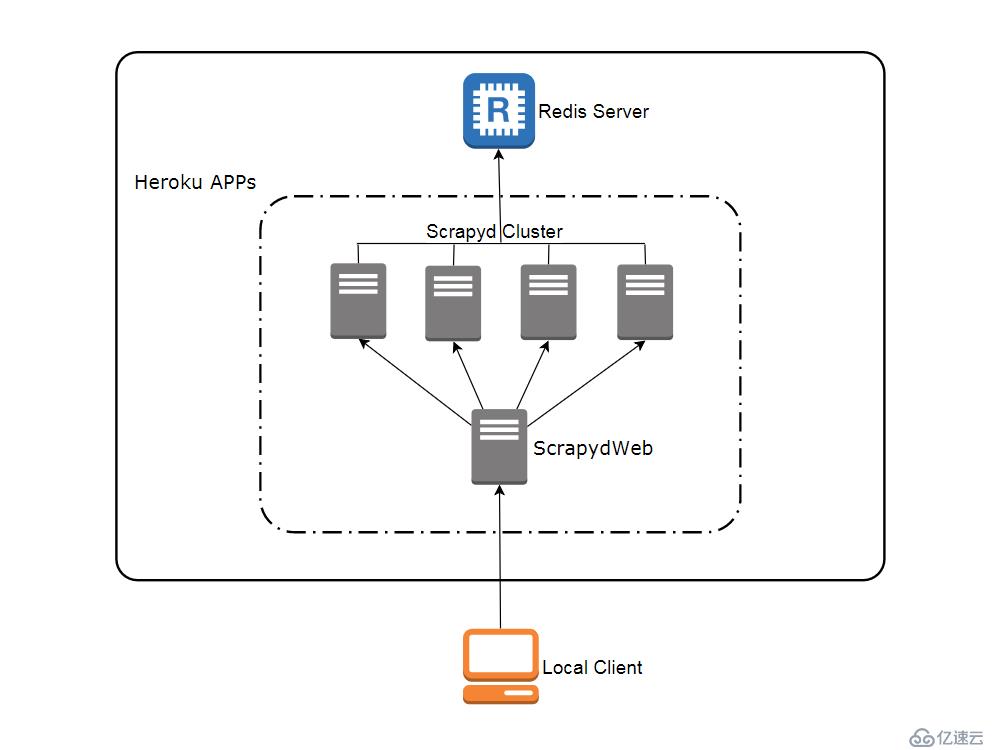

訪問 heroku.com 注冊免費賬號(注冊頁面需要調用 google recaptcha 人機驗證,登錄頁面也需要科學地進行上網,訪問 app 運行頁面則沒有該問題),免費賬號最多可以創建和運行5個 app。

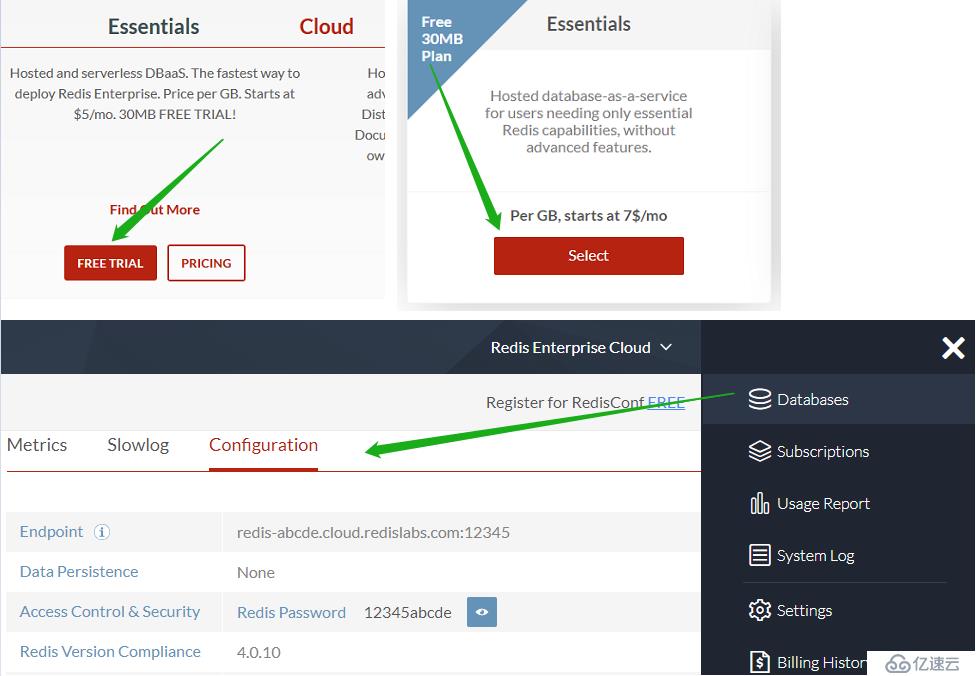

訪問 redislabs.com 注冊免費賬號,提供30MB 存儲空間,用于下文通過 scrapy-redis 實現分布式爬蟲。

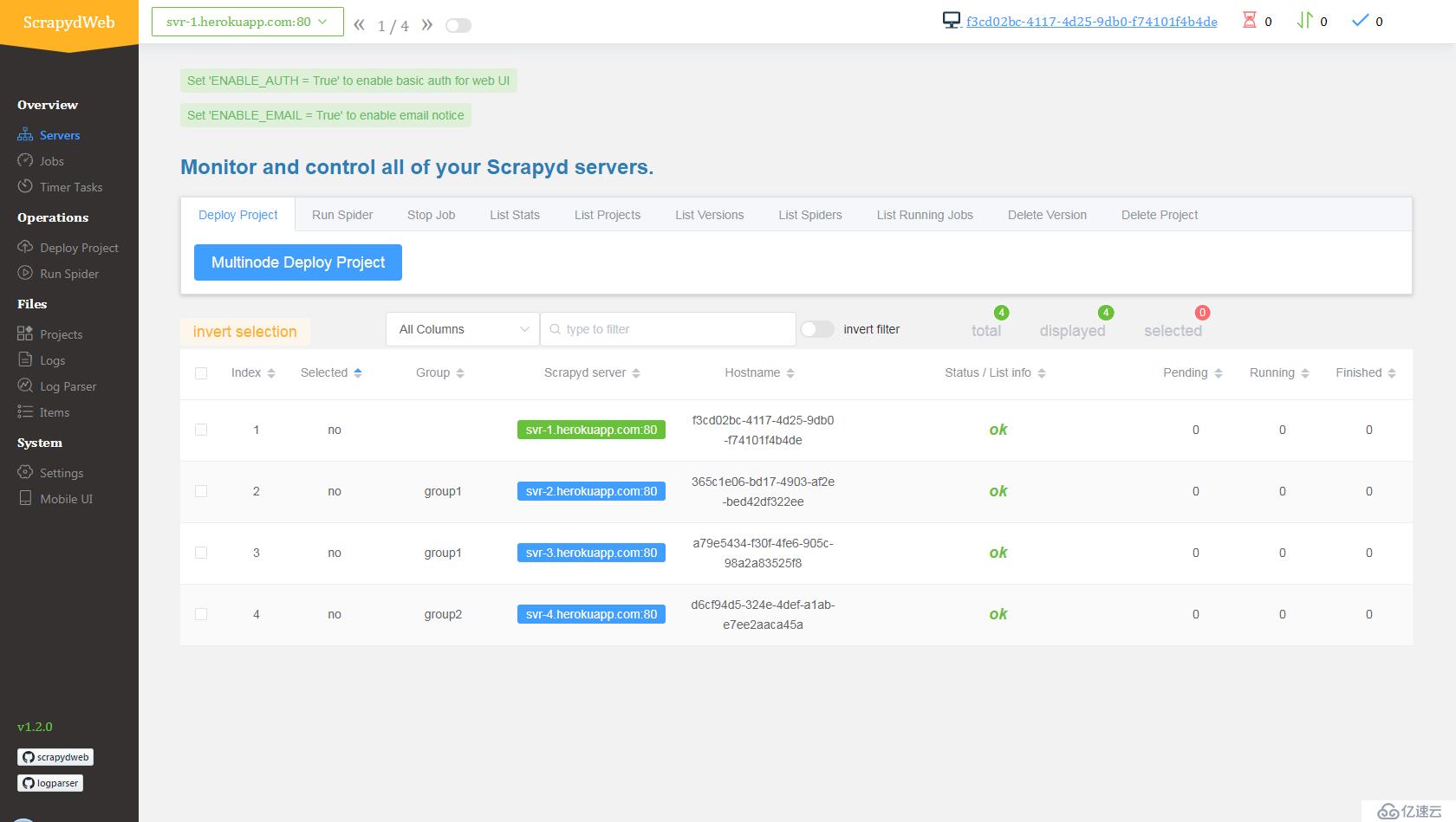

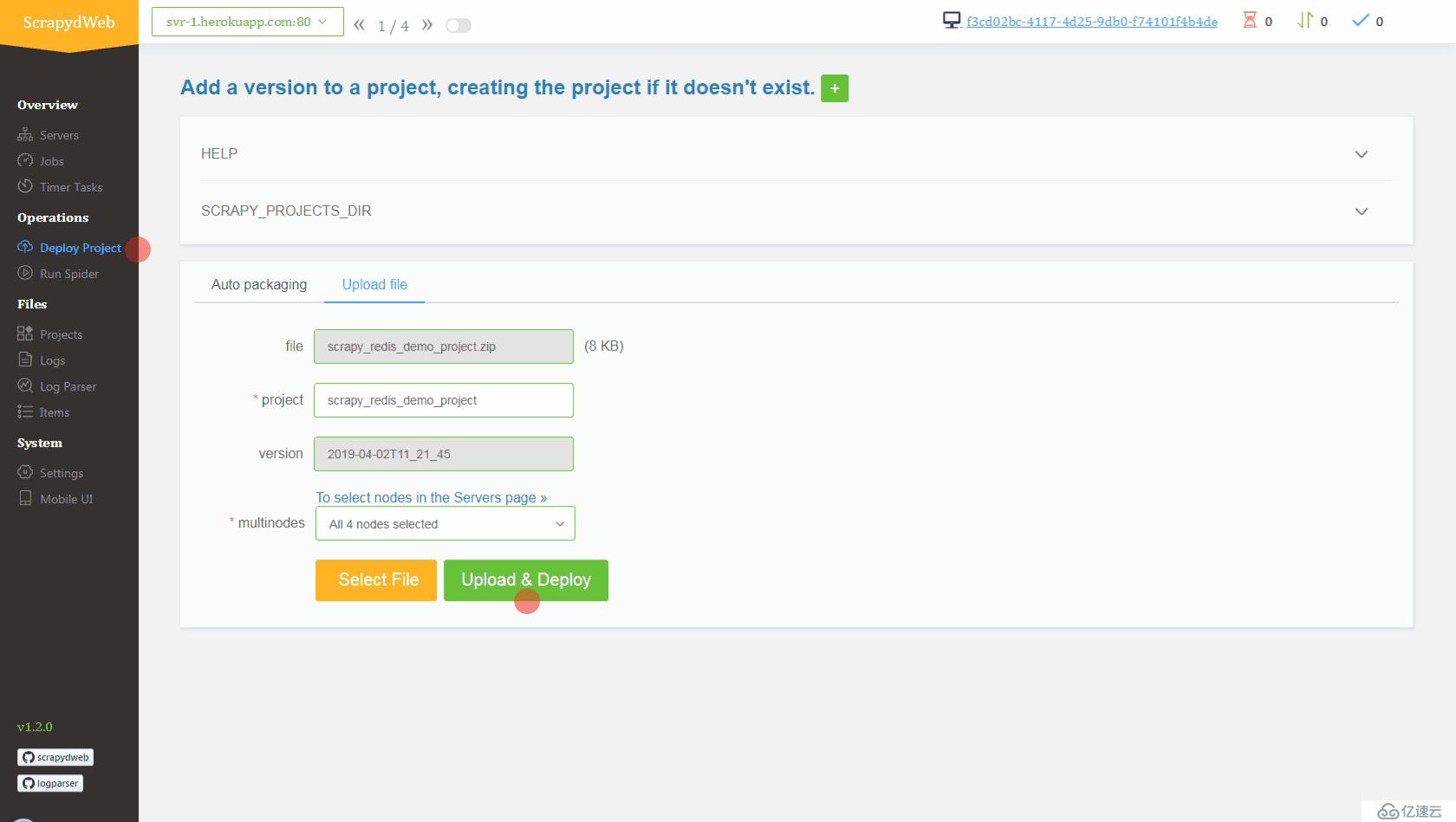

svr-1, svr-2, svr-3 和 svr-4myscrapydwebSCRAPYD_SERVER_2, VALUE 為 svr-2.herokuapp.com:80#group2pip install redis 命令即可。新開一個命令行提示符:

git clone https://github.com/my8100/scrapyd-cluster-on-heroku

cd scrapyd-cluster-on-herokuheroku login

# outputs:

# heroku: Press any key to open up the browser to login or q to exit:

# Opening browser to https://cli-auth.heroku.com/auth/browser/12345-abcde

# Logging in... done

# Logged in as username@gmail.com新建 Git 倉庫

cd scrapyd

git init

# explore and update the files if needed

git status

git add .

git commit -a -m "first commit"

git status部署 Scrapyd app

heroku apps:create svr-1

heroku git:remote -a svr-1

git remote -v

git push heroku master

heroku logs --tail

# Press ctrl+c to stop logs outputting

# Visit https://svr-1.herokuapp.com添加環境變量

# python -c "import tzlocal; print(tzlocal.get_localzone())"

heroku config:set TZ=Asia/Shanghai

# heroku config:get TZheroku config:set REDIS_HOST=your-redis-host

heroku config:set REDIS_PORT=your-redis-port

heroku config:set REDIS_PASSWORD=your-redis-passwordsvr-2,svr-3 和 svr-4新建 Git 倉庫

cd ..

cd scrapydweb

git init

# explore and update the files if needed

git status

git add .

git commit -a -m "first commit"

git status部署 ScrapydWeb app

heroku apps:create myscrapydweb

heroku git:remote -a myscrapydweb

git remote -v

git push heroku master添加環境變量

heroku config:set TZ=Asia/Shanghaiheroku config:set SCRAPYD_SERVER_1=svr-1.herokuapp.com:80

heroku config:set SCRAPYD_SERVER_2=svr-2.herokuapp.com:80#group1

heroku config:set SCRAPYD_SERVER_3=svr-3.herokuapp.com:80#group1

heroku config:set SCRAPYD_SERVER_4=svr-4.herokuapp.com:80#group2

mycrawler:start_urls 觸發爬蟲并查看結果In [1]: import redis # pip install redis

In [2]: r = redis.Redis(host='your-redis-host', port=your-redis-port, password='your-redis-password')

In [3]: r.delete('mycrawler_redis:requests', 'mycrawler_redis:dupefilter', 'mycrawler_redis:items')

Out[3]: 0

In [4]: r.lpush('mycrawler:start_urls', 'http://books.toscrape.com', 'http://quotes.toscrape.com')

Out[4]: 2

# wait for a minute

In [5]: r.lrange('mycrawler_redis:items', 0, 1)

Out[5]:

[b'{"url": "http://quotes.toscrape.com/", "title": "Quotes to Scrape", "hostname": "d6cf94d5-324e-4def-a1ab-e7ee2aaca45a", "crawled": "2019-04-02 03:42:37", "spider": "mycrawler_redis"}',

b'{"url": "http://books.toscrape.com/index.html", "title": "All products | Books to Scrape - Sandbox", "hostname": "d6cf94d5-324e-4def-a1ab-e7ee2aaca45a", "crawled": "2019-04-02 03:42:37", "spider": "mycrawler_redis"}']

my8100/scrapyd-cluster-on-heroku

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。