您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

怎么在python蜘蛛使用用pushplus對亞馬遜到貨動態推送進行監控?針對這個問題,這篇文章詳細介紹了相對應的分析和解答,希望可以幫助更多想解決這個問題的小伙伴找到更簡單易行的方法。

一、pushplus相關介紹

pushplus提供了免費的微信消息推送api,具體內容可以參考他的官網:pushplus(推送加)微信推送消息直達 (hxtrip.com)

我們需要用到的東西有,登陸后的個人Token(用于精準推送消息),如圖:

調用該接口可使用如下代碼,token為上面提到的你個人的token,titile對應推送標題,content對應推送內容,此代碼借鑒了官方demo

def post_push(token, title, content):

url = 'http://pushplus.hxtrip.com/send'

data = {

"token": token,

"title": title,

"content": content

}

body = json.dumps(data).encode(encoding='utf-8')

headers = {'Content-Type': 'application/json'}

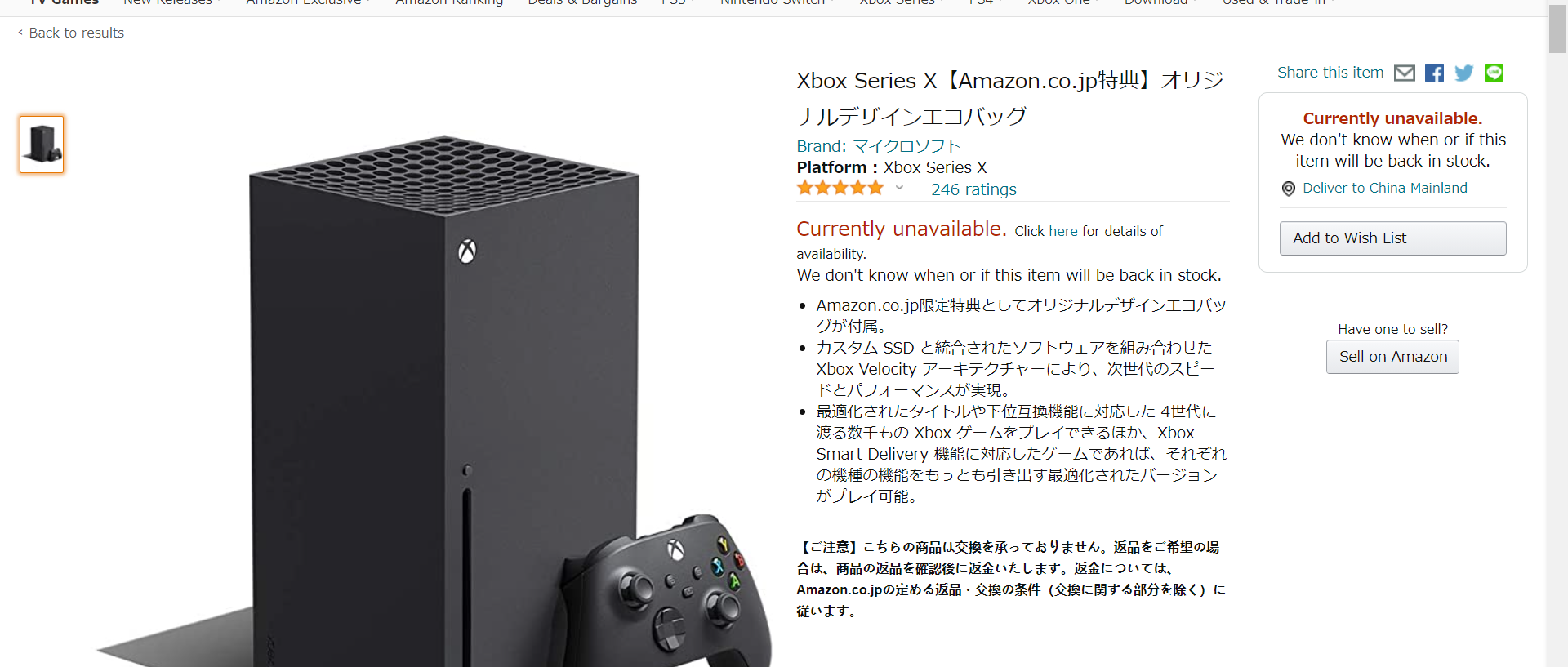

requests.post(url, data=body, headers=headers)不出意外的話,你在編寫代碼時,amazon應該處于無貨狀態(有貨直接就買了啊喂)!!!我們在此時打開amazon頁面,可以看到如下界面:

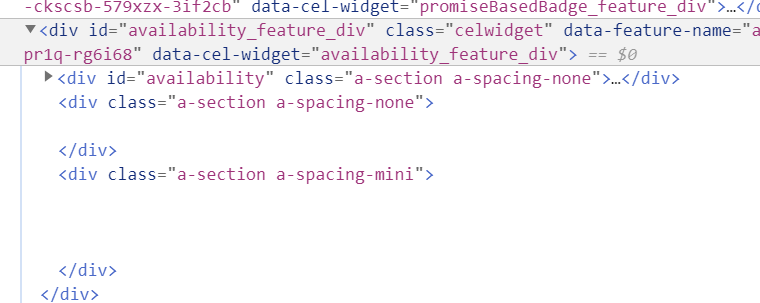

在新版Edge瀏覽器或者chrome下,按F12查看網頁源碼,選定中間Currently unavailable標識的區域(五顆星下面那個,最好覆蓋范圍大一點),能看到代碼如下:

有一個比較簡單的辦法,判斷amazon是否有補貨。我們可以抓取這一部分的html源碼,存進一個文件里(txt即可)。每過一定時間,重新抓取源碼,如果這些源碼變化了,那么基本上是網站更新了(補貨了)。不過有個小瑕疵,這種補貨也可能是亞馬遜第三方(黃牛)補貨- -

不過總歸是有了一個判斷上新的方法嘛;其實黃牛補貨很少的,德亞上好像看不到黃牛(我個人沒見過德亞上的第三方賣xsx的),日亞上基本沒有啥黃牛賣xbox

好了,接下來,我們看看如何實現相關功能

我們使用Requests+BeautfifulSoup來抓取<div id = 'availability_feature_div> </div>這個標簽內部的所有html源碼

headers = {

"User-Agent": "Mozilla/5.0 (Linux; Android 9; SM-A102U) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.93 Mobile Safari/537.36",

'Content-Type': 'application/json'

}

html = requests.get(url=self.url, headers=headers)

soup = BeautifulSoup(html.text, 'lxml')

html.close()

target = str(soup.find('div', id='availability_feature_div'))注意如果不加headers的話,amazon會檢測到爬蟲,不會給你返回完整html代碼。第7行把requests給close掉是因為,我在監測時開了兩個線程同時檢測日亞和德亞,如果不加這一句的話,會被amazon認為是我在攻擊網站,會拒絕我的網絡訪問

最終的target是被轉為str格式的相應html源碼,接下來只需要將其保存到文件,每隔一定時間再次爬蟲比對就行了

import json

import requests

from bs4 import BeautifulSoup

import filecmp

import time

import threading

class listenThread(threading.Thread):

def __init__(self, url, originFile, newFile, content):

threading.Thread.__init__(self)

self.url = url

self.originFile = originFile

self.newFile = newFile

self.content = content

def listen(self):

headers = {

"User-Agent": "Mozilla/5.0 (Linux; Android 9; SM-A102U) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.93 Mobile Safari/537.36",

'Content-Type': 'application/json'

}

html = requests.get(url=self.url, headers=headers)

soup = BeautifulSoup(html.text, 'lxml')

html.close()

target = str(soup.find('div', id='availability_feature_div'))

filetxt = open(self.originFile, 'w', encoding='utf-8')

filetxt.write(target)

filetxt.close()

while True:

target = str(soup.find('div', id='availability_feature_div'))

filetxt = open(self.newFile, 'w', encoding='utf-8')

filetxt.write(target)

filetxt.close()

if filecmp.cmp(self.originFile, self.newFile) == False:

post_push('這里輸你自己的token', 'xbox update', self.content)

fileAvail = open(self.originFile, 'w')

fileAvail.write(target)

fileAvail.close()

time.sleep(30)

def run(self):

self.listen()

def post_push(token, title, content):

url = 'http://pushplus.hxtrip.com/send'

data = {

"token": token,

"title": title,

"content": content

}

body = json.dumps(data).encode(encoding='utf-8')

headers = {'Content-Type': 'application/json'}

requests.post(url, data=body, headers=headers)

if __name__ == '__main__':

detect_url = 'https://www.amazon.co.jp/-/en/dp/B08GGKZ34Z/ref=sr_1_2?dchild=1&keywords=xbox&qid=1611674118&sr=8-2'

#url_special = 'https://www.amazon.co.jp/-/en/dp/B08GG17K5G/ref=sr_1_6?dchild=1&keywords=xbox%E3%82%B7%E3%83%AA%E3%83%BC%E3%82%BAx&qid=1611722050&sr=8-6'

url_germany = 'https://www.amazon.de/Microsoft-RRT-00009-Xbox-Series-1TB/dp/B08H93ZRLL/ref=sr_1_2?__mk_de_DE=%C3%85M%C3%85%C5%BD%C3%95%C3%91&dchild=1&keywords=xbox&qid=1611742161&sr=8-2'

xbox = listenThread(url=detect_url,originFile='avail.txt',newFile='avail_now.txt',content='日亞')

#xbox_sp = listenThread(url=detect_url,originFile='avail_sp.txt',newFile='avail_now_sp.txt')

xbox_germany = listenThread(url=url_germany,originFile='avail_sp.txt',newFile='avail_now_sp.txt',content='德亞')

xbox.start()

#xbox_sp.start()

xbox_germany.start()關于怎么在python蜘蛛使用用pushplus對亞馬遜到貨動態推送進行監控問題的解答就分享到這里了,希望以上內容可以對大家有一定的幫助,如果你還有很多疑惑沒有解開,可以關注億速云行業資訊頻道了解更多相關知識。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。