您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

#HIVE可以在任意節點搭建,實驗在master

鏈接:http://pan.baidu.com/s/1i4LCmAp 密碼:302x hadoop+hive下載

##原封不動的復制,必死無疑,請根據實際填寫相關參數和路徑

1、 Hive的基礎設施

a、基于已經搭建好的hadoop

b、下載hive版本,注意和hadoop對應起來

2、安裝hive

a、下載好的包解壓到/usr/local/命名為hive

tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /usr/local

cd /usr/local

mvapache-hive-1.2.1-bin hive

b、設置環境變量

vim/etc/profile

exportHIVE_HOME=/usr/local/hive

exportHIVE_CONF_DIR=/usr/local/conf

exportPATH=$PATH:$HIVE_HOME/bin

exportHIVE_LIB=$HIVE_HOME/lib

到此就可以啟動hive

[root@mycat ~]# hive

Logging initialized using configuration injar:file:/usr/local/hive/lib/hive-common-1.2.1.jar!/hive-log4j.properties

hive> show databases;

OK

default

Time taken: 1.096 seconds, Fetched: 1row(s)

默認情況下,Hive元數據保存在內嵌的Derby 數據庫中,只能允許一個會話連接,只適合簡單的測試。為了支持多用戶多會話,則需要一個獨立的元數據庫,我們使用 MySQL 作為元數據庫,Hive 內部對 MySQL 提供了很好的支持。

二、使用MySQL存儲元數據

1、啟動mysql5.6版本(操作過程略)

2、配置hive文件,配置文件在/usr/local/hive/conf/目錄下有.template的模板文件,復制為hive-env.sh

[root@mycat conf]# cp hive-env.sh.templatehive-env.sh

[root@mycat conf]# vim hive-env.sh

##這里的配置和/etc/profile重復,可以不配置,配置環境變量即可

1、環境變量

exportHADOOP_HEAPSIZE=1024

HADOOP_HOME=/usr/local/hadoop

export HIVE_CONF_DIR=/usr/local/hive/conf

export HIVE_AUX_JARS_PATH=/usr/local/hive/lib

2、復制一個從模版文件復制一個hive-site.xml的文件

cp /usr/local/hive/conf/hive-default.xml.template ./hive-site.xml

通過name標簽里的值找到value,修改值,配置文件下載:

http://down.51cto.com/data/2260702

##原封不動的復制,必死無疑,請根據實際填寫相關參數和路徑,標記紅色的注意修改自己的實際

<name>hive.metastore.warehouse.dir</name>

<value>/home/hive/warehouse</value>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://192.168.1.108:3306/hive?characterEncoding=UTF-8</value>

#需要在數據庫里添加存儲元數據的庫

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<name>javax.jdo.option.ConnectionPassword</name>

<value>mysql</value>

##連接數據庫的用戶名和密碼,授權用戶名和密碼

<name>hive.hwi.listen.port </name>

<value>9999</value>

<name>hive.exec.local.scratchdir</name>

<value>/home/hive</value>

<name>hive.downloaded.resources.dir</name>

<value>/home/hive/tmp</value>

<name>hive.querylog.location</name>

<value>/home/hive</value>

配置輸出的日志信息

hive.log.dir=/home/hive

hive.log.file=hive.log

log4j.appender.EventCounter=org.apache.hadoop.log.metrics.EventCounter

3、 根據配置創建HIVE存儲數據的目錄

mkdir /home/hive/tmp –p

4、 配置jdbc連接器

1、下載包并解壓

2、拷貝mysql-connector-java-5.1.6-bin.jar 到hive 的lib下面

若在操作刪除表的時候發現提示:

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. MetaException

則需要替換mysql-connector-java包的版本

鏈接:http://pan.baidu.com/s/1qXIGeSG 密碼:iykt 下載包

cp mysql-connector-java-5.1.6-bin.jar /usr/local/hive/lib/

頁面提示

http://192.168.1.114:50070/explorer.html#/home提示這個需要修改

Permission denied: user=dr.who, access=READ_EXECUTE,inode="/home":root:supergroup:drwx-wx-wx

在vim /usr/local/hadoop/etc/hadoop/hdfs-site.xml添加如下,后重啟

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

#配置完這些把namenode節點重啟生效

測試hive操作可以在mysql顯示及在HADOOP頁面也能展示出來

登陸hive

5.2創建內部表

內部表特點:數據加載到內部表中是,如果數據在本地會在將本地數據拷貝一份到內部LOCATION指定的目錄下,如果數據在hdfs上,則會將hdfs中的數據mv到內部表指定的LOCATION中。刪除內部表時,會刪除相應LOCATION下的數據。

create table neibu_table(id int);

show tables #進行查看

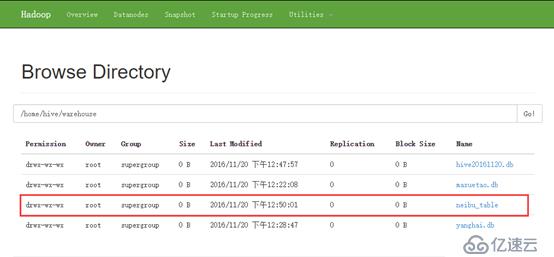

hive在hdfs中的默認位置是/user/hive/warehouse,該位置可以修改,是由配置文件hive-site.xml中屬性hive.metastore.warehouse.dir決定的,會在/home/hive/warehouse/testdb.db下創建student目錄。

通過瀏覽器可以查看

先來說下Hive中內部表與外部表的區別:(重點)

1)創建表時:創建內部表時,會將數據移動到數據倉庫指向的路徑;若創建外部表,僅記錄數據所在的路徑, 不對數據的位置做任何改變。

2)刪除表時:在刪除表的時候,內部表的元數據和數據會被一起刪除, 而外部表只刪除元數據,不刪除數據。這樣外部表相對來說更加安全些,數據組織也更加靈活,方便共享源數據。

另外需要注意的是傳統數據庫對表數據驗證是 schema on write(寫時模式),而 Hive 在load時是不檢查數據是否符合schema的,hive 遵循的是 schema on read(讀時模式),只有在讀的時候hive才檢查、解析具體的 數據字段、schema。

讀時模式的優勢是load data 非常迅速,因為它不需要讀取數據進行解析,僅僅進行文件的復制或者移動。

寫時模式的優勢是提升了查詢性能,因為預先解析之后可以對列建立索引,并壓縮,但這樣也會花費要多的加載時間。

1、內部表操作:

加載數據到表中方法:

##注意aa文件的數據要先創建好

hive> LOAD DATA LOCAL INPATH '/home/aa'INTO TABLE neibu_table;

Loading data to table default.neibu_table

Table default.neibu_table stats: [numFiles=1, totalSize=10]

OK

Time taken: 0.639 seconds

Select * from neibu_table

使用select* 不加條件時,不執行MapReduce,執行比較快;最后一行顯示的是null,原因是文件中有一行空格;

注意:內部表會將數據拷貝一份到表目錄下面,如果刪除內部表元數據,那么該元數據下面的數據也會被刪除;

第二種加載數據到student中的方法

注意bb.txt文件的路徑,并寫入一列數字;

執行命令hadoop fs -put bb.txt /home/hive/warehouse/neibu_table或者 hdfsdfs -put t /home/hive/warehouse/neibu_table

添加一個庫:create database hive20161120

2、分區表:將每個小時或每天的日志文件進行分區存儲,可以針對某個特定時間段做業務分析,而不必分析掃描所有數據;

創建表a20161120,有多個列的情況創建表,指定分隔符為\t

創建分區表:

CREATE TABLE fenqu(id int) PARTITIONED BY (d int);

LOAD DATA LOCAL INPATH 'bb.txt INTO TABLE fenquPARTITION (d=1);

LOAD DATA LOCAL INPATH 'bb2.txt' INTO TABLE fenquPARTITION (d=2);

3、 桶表

(表連接時候使用,根據桶的個數進行取模運算,將不同的數據放到不同的桶中)

創建桶類型的表

create table student4(id int) clustered by(id)into 4 buckets;

必須啟用桶表

set hive.enforce.bucketing = true;

插入數據,這里并沒有使用load,而是用的insert,insert加載數據使用了mapreduce。

insert into table student4 select id fromstudent3;

在hive 添加的表可以在mysql查看他的元數據信息,在配置問建立定義的庫下記錄所有所有相關的記錄

Eg:select * from TBLS;

4、外部表:

導入數據和內部表一樣 ,這里不做重復

hive> drop table outer_table;

OK

Time taken: 0.081 seconds

hive> show tables;

OK

Time taken: 0.023 seconds

hive> create external table outer_table(id int)

> ;

OK

Time taken: 0.037 seconds

hive> select * from outer_table

> ;

OK

1

2

3

4

5

6

7

8

9

10

Time taken: 0.044 seconds, Fetched: 10 row(s)

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。