溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這期內容當中小編將會給大家帶來有關python反爬蟲怎么利用sleep間隔實現,文章內容豐富且以專業的角度為大家分析和敘述,閱讀完這篇文章希望大家可以有所收獲。

步驟

要利用headers拉動請求,模擬成瀏覽器去訪問網站,跳過最簡單的反爬蟲機制。

獲取網頁內容,保存在一個字符串content中。

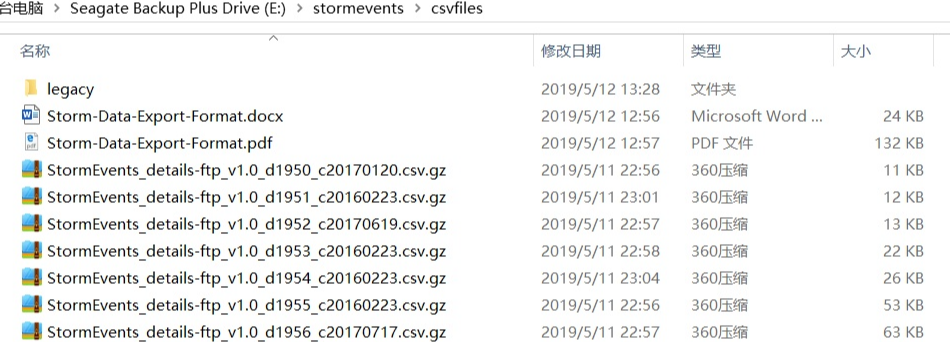

構造正則表達式,從content中匹配關鍵詞pattern獲取下載鏈接。需要注意的是,網頁中的關鍵詞出現了兩遍(如下圖),所以我們要利用set()函數清除重復元素。

第三步是遍歷set之后的結果,下載鏈接。

設置time.sleep(t),無sleep間隔的話,網站認定這種行為是攻擊,所以我們隔一段時間下載一個,反反爬蟲。

具體代碼

import urllib.request# url request

import re # regular expression

import os # dirs

import time

'''

url 下載網址

pattern 正則化的匹配關鍵詞

Directory 下載目錄

def BatchDownload(url,pattern,Directory):

# 拉動請求,模擬成瀏覽器去訪問網站->跳過反爬蟲機制

headers = {'User-Agent', 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.186 Safari/537.36'}

opener = urllib.request.build_opener()

opener.addheaders = [headers]

# 獲取網頁內容

content = opener.open(url).read().decode('utf8')

# 構造正則表達式,從content中匹配關鍵詞pattern

raw_hrefs = re.findall(pattern, content, 0)

# set函數消除重復元素

hset = set(raw_hrefs)

# 下載鏈接

for href in hset:

# 之所以if else 是為了區別只有一個鏈接的特別情況

if(len(hset)>1):

link = url + href[0]

filename = os.path.join(Directory, href[0])

print("正在下載",filename)

urllib.request.urlretrieve(link, filename)

print("成功下載!")

else:

link = url +href

filename = os.path.join(Directory, href)

# 無sleep間隔,網站認定這種行為是攻擊,反反爬蟲

time.sleep(1)

#BatchDownload('https://www1.ncdc.noaa.gov/pub/data/swdi/stormevents/csvfiles/',

# '(Storm-Data-Export-Format.docx)',

# 'E:\stormevents\csvfiles')

# '(Storm-Data-Export-Format.pdf)',

# '(StormEvents_details-ftp_v1.0_d(\d*)_c(\d*).csv.gz)',

# '(StormEvents_fatalities-ftp_v1.0_d(\d*)_c(\d*).csv.gz)',

# '(StormEvents_locations-ftp_v1.0_d(\d*)_c(\d*).csv.gz)',

#BatchDownload('https://www1.ncdc.noaa.gov/pub/data/swdi/stormevents/csvfiles/legacy/',

# '(ugc_areas.csv)',

# 'E:\stormevents\csvfiles\legacy')為了讓大家能夠清楚的知道整個反爬過程,這里小編把思路和代碼都羅列了出來。其中可以time.sleep(t)解除網站對于爬蟲的阻攔問題,著重標記了出來

上述就是小編為大家分享的python反爬蟲怎么利用sleep間隔實現了,如果剛好有類似的疑惑,不妨參照上述分析進行理解。如果想知道更多相關知識,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。