您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

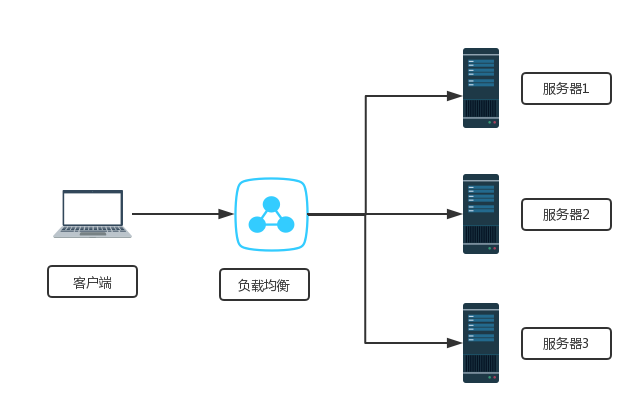

下文給大家帶來Deployment的概述及其使用場景,希望能夠給大家在實際運用中帶來一定的幫助,負載均衡涉及的東西比較多,理論也不多,網上有很多書籍,今天我們就用億速云在行業內累計的經驗來做一個解答。

Deployment是kubernetes 1.2引入的概念,用來解決Pod的編排問題。Deployment可以理解為RC的升級版(RC+Reolicat Set)。特點在于可以隨時知道Pod的部署進度,即對Pod的創建、調度、綁定節點、啟動容器完整過程的進度展示。

創建一個Deployment對象來生成對應的Replica Set并完成Pod副本的創建過程。

檢查Deployment的狀態來確認部署動作是否完成(Pod副本的數量是否達到預期值)。

更新Deployment以創建新的Pod(例如鏡像升級的場景)。

如果當前Deployment不穩定,回退到上一個Deployment版本。

掛起或恢復一個Deployment。

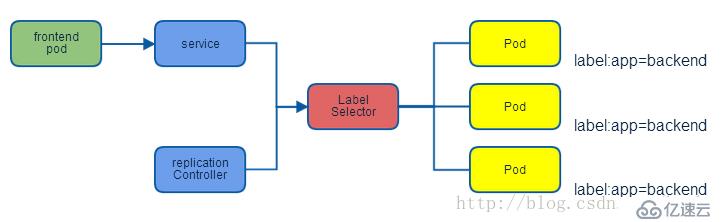

Service定義了一個服務的訪問入口地址,前端應用通過這個入口地址訪問其背后的一組由Pod副本組成的集群實例,Service與其后端的Pod副本集群之間是通過Label Selector來實現“無縫對接”。RC保證Service的Pod副本實例數目保持預期水平。

| IP類型 | 說明 |

|---|---|

| Node IP | Node節點的IP地址 |

| Pod IP | Pod的IP地址 |

| Cluster IP | Service的IP地址 |

| 主機 | IP地址 | 服務 |

|---|---|---|

| master | 192.168.1.21 | k8s |

| node01 | 192.168.1.22 | k8s |

| node02 | 192.168.1.23 | k8s |

基于https://blog.51cto.com/14320361/2464655 的實驗繼續進行

[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

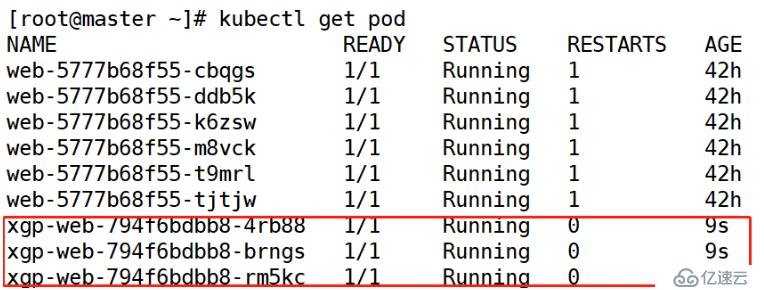

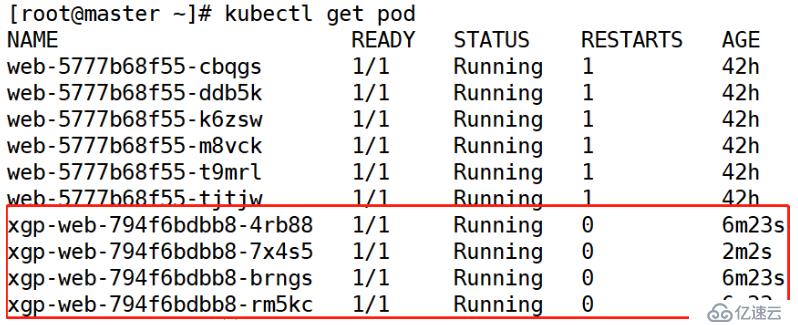

image: 192.168.1.21:5000/web:v1[root@master ~]# kubectl apply -f xgp.yaml --record[root@master ~]# kubectl get pod

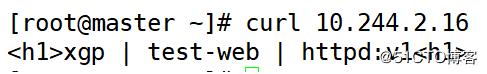

[root@master ~]# curl 10.244.2.16

[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 4

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v1[root@master ~]# kubectl apply -f xgp.yaml --recore[root@master ~]# kubectl get pod

副本數量加一,如果yaml文件的副本為0,則副本數量還是之前的狀態,并不會更新。

[root@master ~]# vim xgp-svc.yaml

kind: Service

apiVersion: v1

metadata:

name: xgp-svc

spec:

selector:

app: xgp-server

ports:

- protocol: TCP

port: 80

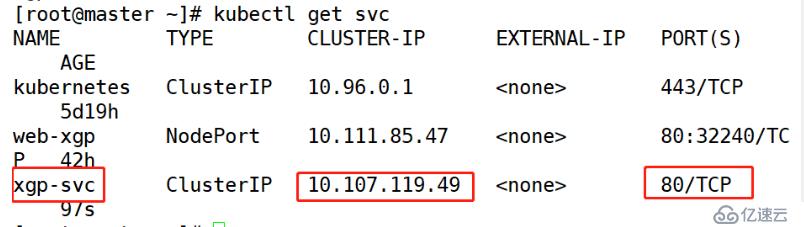

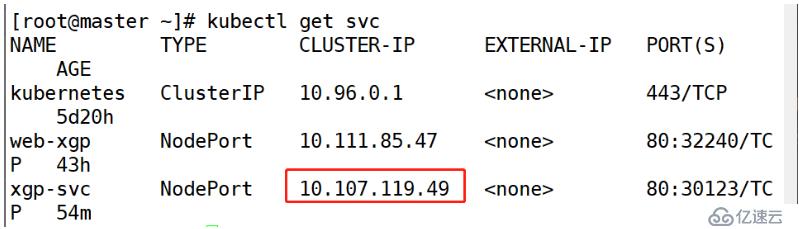

targetPort: 80[root@master ~]# kubectl apply -f xgp-svc.yaml [root@master ~]# kubectl get svc

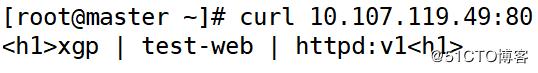

[root@master ~]# curl 10.107.119.49

[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v1

ports:

- containerPort: 80 #提示端口注意:在Delpoyment資源對象中,可以添加Port字段,但此字段僅供用戶查看,并不實際生效

[root@master ~]# kubectl apply -f xgp.yaml [root@master ~]# vim xgp-svc.yaml

kind: Service

apiVersion: v1

metadata:

name: xgp-svc

spec:

type: NodePort

selector:

app: xgp-server

ports:

- protocol: TCP

port: 80

targetPort: 80

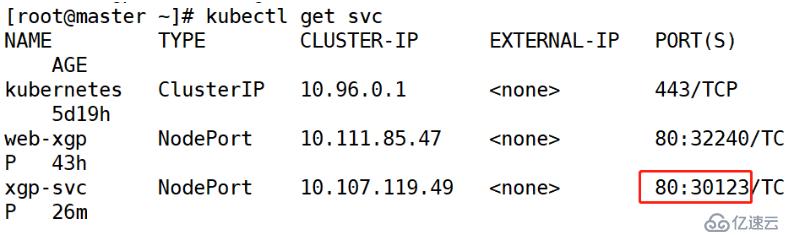

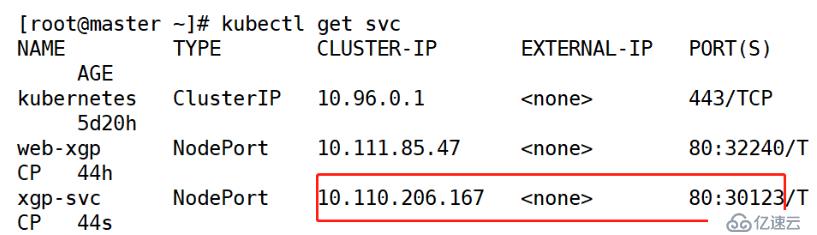

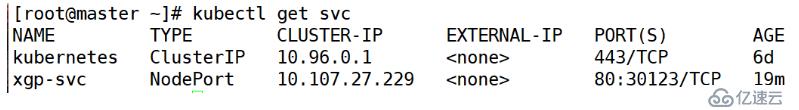

nodePort: 30123[root@master ~]# kubectl apply -f xgp-svc.yaml [root@master ~]# kubectl get svc

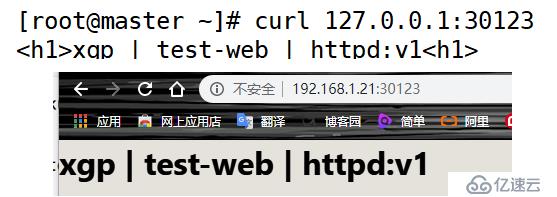

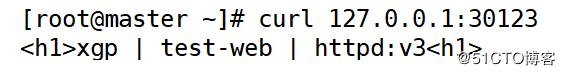

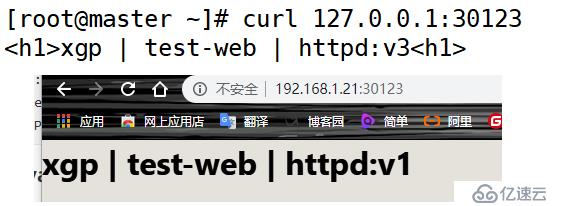

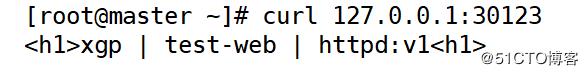

[root@master ~]# curl 127.0.0.1:30123

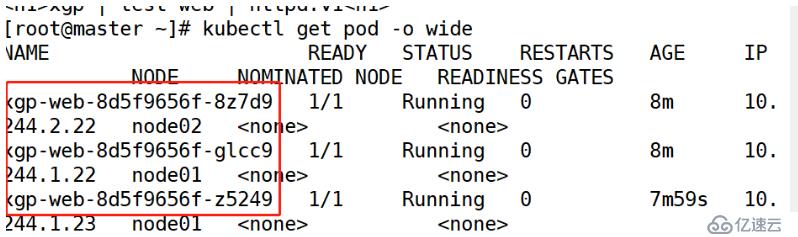

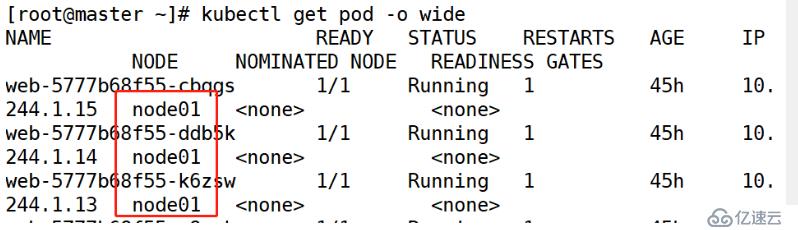

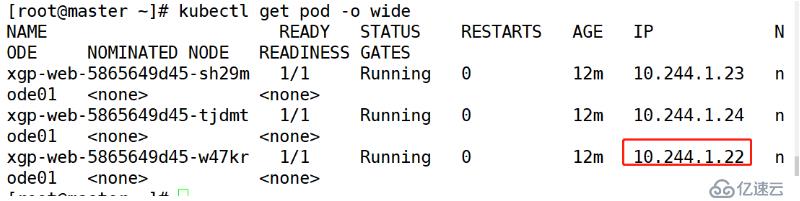

[root@master ~]# kubectl get pod -o wide

[root@master ~]# kubectl exec -it xgp-web-8d5f9656f-8z7d9 /bin/bash

//根據pod名稱進入pod之中root@xgp-web-8d5f9656f-8z7d9:/usr/local/apache2# echo xgp-v1 > htdocs/index.html

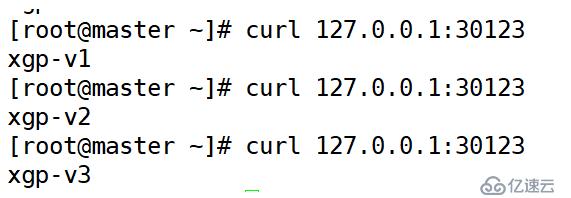

root@xgp-web-8d5f9656f-8z7d9:/usr/local/apache2# exit[root@master ~]# curl 127.0.0.1:30123

[root@master ~]# kubectl get svc

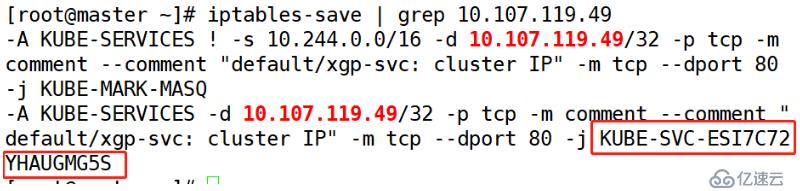

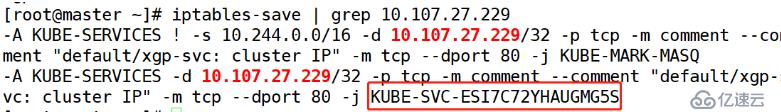

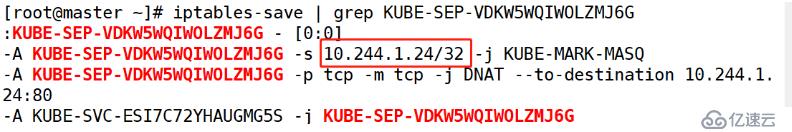

[root@master ~]# iptables-save

//查看已配置的規則SNAT:Source NAT(源地址轉換)

DNAT:Destination NAT(目標地址轉換)

MASQ:動態的源地址轉換

[root@master ~]# iptables-save | grep 10.107.119.49

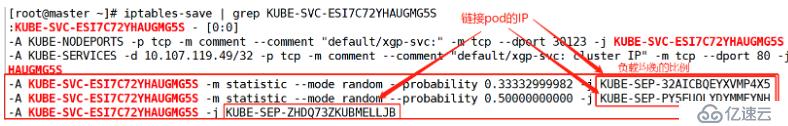

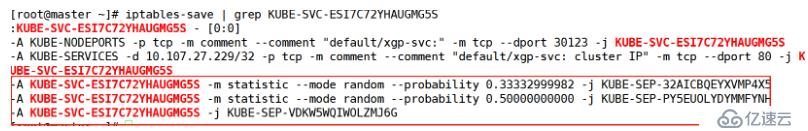

[root@master ~]# iptables-save | grep KUBE-SVC-ESI7C72YHAUGMG5S

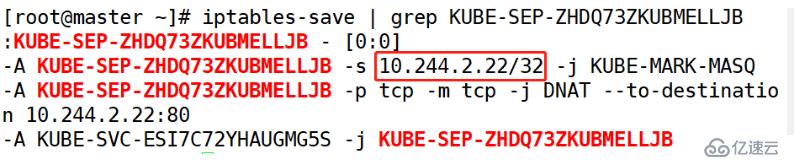

[root@master ~]# iptables-save | grep KUBE-SEP-ZHDQ73ZKUBMELLJB

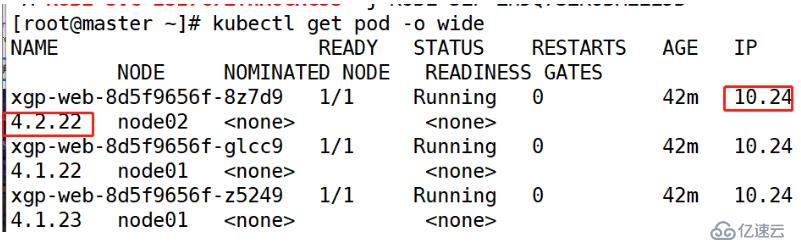

[root@master ~]# kubectl get pod -o wide

Service實現的負載均衡:默認使用的是iptables規則。IPVS

[root@master ~]# kubectl delete -f xgp.yaml

[root@master ~]# kubectl delete -f xgp-svc.yaml [root@master ~]# vim xgp1.yaml (三個文件名不相同)

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

revisionHistoryLimit: 10

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v1 (三臺版本不同)

ports:

- containerPort: 80此處3個yaml文件 指定不同版本的鏡像

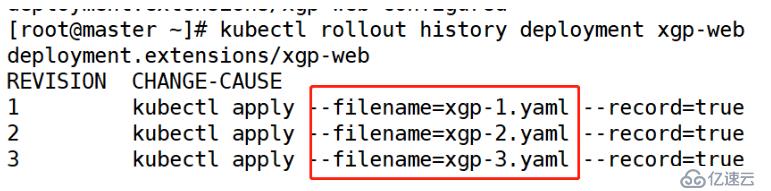

[root@master ~]# kubectl apply -f xgp-1.yaml --record

[root@master ~]# kubectl apply -f xgp-2.yaml --record

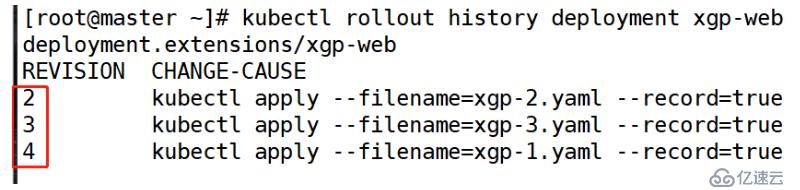

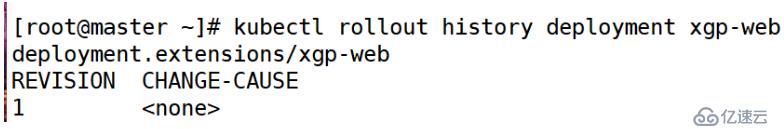

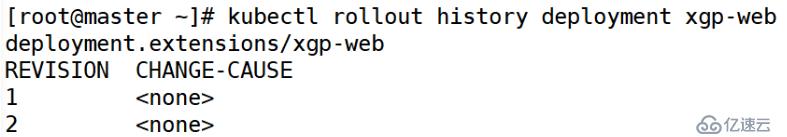

[root@master ~]# kubectl apply -f xgp-3.yaml --record [root@master ~]# kubectl rollout history deployment xgp-web

[root@master ~]# kubectl apply -f xgp-svc.yaml[root@master ~]# kubectl get svc

[root@master ~]# curl 127.0.0.1:30123

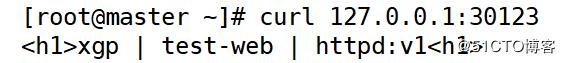

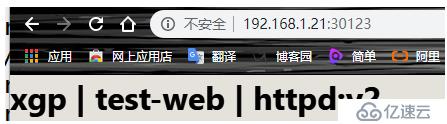

[root@master ~]# kubectl rollout undo deployment xgp-web --to-revision=1

//這里指定的是版本信息的編號[root@master ~]# curl 127.0.0.1:30123

[root@master ~]# kubectl rollout history deployment xgp-web

編號1已經被編號2替代,從而生的是一個新的編號4

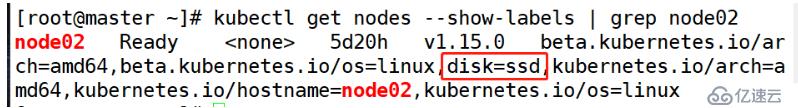

默認情況下,scheduler會將pod調度到所有可用的Node,不過有些情況我們希望將 Pod 部署到指定的 Node,比如將有大量磁盤 I/O 的 Pod 部署到配置了 SSD 的 Node;或者 Pod 需要 GPU,需要運行在配置了 GPU 的節點上。

kubernetes通過label來實現這個功能

label 是 key-value 對,各種資源都可以設置 label,靈活添加各種自定義屬性。比如執行如下命令標注 k8s-node1 是配置了 SSD 的節點

[root@master ~]# kubectl label nodes node02 disk=ssd[root@master ~]# kubectl get nodes --show-labels | grep node02

[root@master ~]# kubectl delete -f xgp-1.yaml

deployment.extensions "xgp-web" deleted

[root@master ~]# kubectl delete svc xgp-svc [root@master ~]# vim xgp-1.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

revisionHistoryLimit: 10

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v1

ports:

- containerPort: 80

nodeSelector: #添加節點選擇器

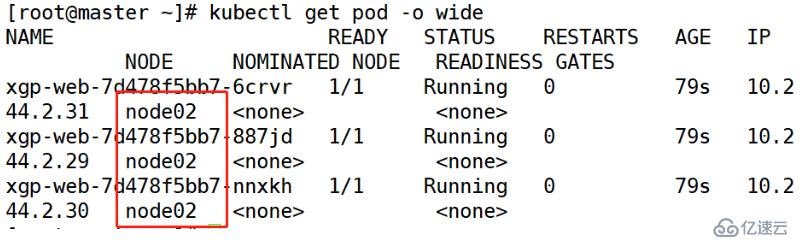

disk: ssd #和標簽內容一致[root@master ~]# kubectl apply -f xgp-1.yaml [root@master ~]# kubectl get pod -o wide

現在pod都在node02上運行

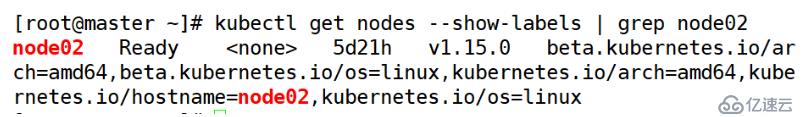

[root@master ~]# kubectl label nodes node02 disk-[root@master ~]# kubectl get nodes --show-labels | grep node02

沒有disk標簽了

[root@master ~]# kubectl label nodes node01 disk=ssd[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v1

ports:

- containerPort: 80

nodeSelector:

disk: ssd [root@master ~]# vim xgp-svc.yaml

kind: Service

apiVersion: v1

metadata:

name: xgp-svc

spec:

type: NodePort

selector:

app: xgp-server

ports:

- protocol: TCP

port: 80

targetPort: 80

nodePort: 30123[root@master ~]# kubectl apply -f xgp.yaml --recore

[root@master ~]# kubectl apply -f xgp-svc.yaml [root@master ~]# kubectl get pod -o wide

[root@master ~]# kubectl rollout history deployment xgp-web > pod.txt

[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v2 #修改版本為二

ports:

- containerPort: 80

nodeSelector:

disk: ssd[root@master ~]# kubectl apply -f xgp.yaml --record

[root@master ~]# kubectl rollout history deployment xgp-web > pod.txt

[root@master ~]# vim xgp.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: xgp-web

spec:

replicas: 3

template:

metadata:

labels:

app: xgp-server

spec:

containers:

- name: web

image: 192.168.1.21:5000/web:v3 #修改版本為二

ports:

- containerPort: 80

nodeSelector:

disk: ssd[root@master ~]# kubectl apply -f xgp.yaml --record

Service實現的負載均衡:默認使用的是iptables規則。IPVS

[root@master ~]# iptables-save | grep 10.107.27.229

//根據service的暴露IP,查看對應的iptabes規則

[root@master ~]# iptables-save | grep KUBE-SVC-ESI7C72YHAUGMG5S

這里顯示了各節點的負載比例

[root@master ~]# iptables-save | grep KUBE-SEP-VDKW5WQIWOLZMJ6G

[root@master ~]# kubectl get pod -o wide

[root@master ~]# kubectl rollout undo deployment xgp-web --to-revision=1

//這里指定的是版本信息的編號[root@master ~]# curl 127.0.0.1:30123

排錯思路

[root@master ~]# less /var/log/messages | grep kubelet [root@master ~]# kubectl logs -n kube-system kube-scheduler-master [root@master ~]# kubectl describe pod xgp-web-7d478f5bb7-bd4bj看了以上關于Deployment的概述及其使用場景,如果大家還有什么地方需要了解的可以在億速云行業資訊里查找自己感興趣的或者找我們的專業技術工程師解答的,億速云技術工程師在行業內擁有十幾年的經驗了。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。