您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家分享的是有關怎么用python3 urllib破解有道翻譯反爬蟲機制的內容。小編覺得挺實用的,因此分享給大家做個參考,一起跟隨小編過來看看吧。

1、簡單易用,與C/C++、Java、C# 等傳統語言相比,Python對代碼格式的要求沒有那么嚴格;2、Python屬于開源的,所有人都可以看到源代碼,并且可以被移植在許多平臺上使用;3、Python面向對象,能夠支持面向過程編程,也支持面向對象編程;4、Python是一種解釋性語言,Python寫的程序不需要編譯成二進制代碼,可以直接從源代碼運行程序;5、Python功能強大,擁有的模塊眾多,基本能夠實現所有的常見功能。

前言

最近在學習python 爬蟲方面的知識,網上有一博客專欄專門寫爬蟲方面的,看到用urllib請求有道翻譯接口獲取翻譯結果。發現接口變化很大,用md5加了密,于是自己開始破解。加上網上的其他文章找源碼方式并不是通用的,所有重新寫一篇記錄下。

爬取條件

要實現爬取的目標,首先要知道它的地址,請求參數,請求頭,響應結果。

進行抓包分析

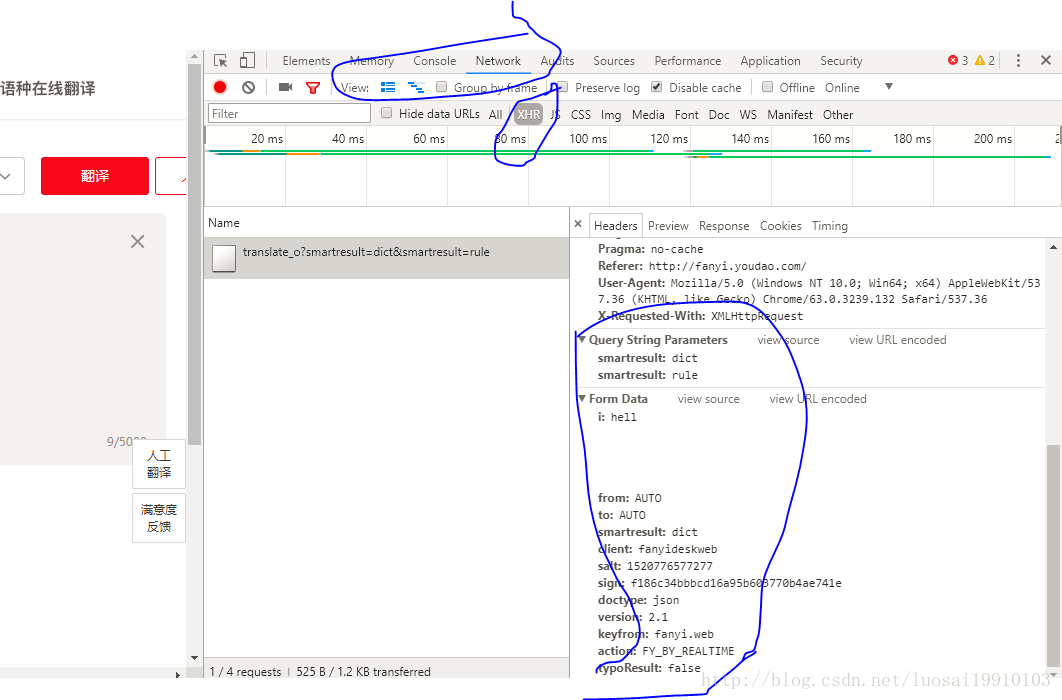

打開有道翻譯的鏈接:http://fanyi.youdao.com/。然后在按f12 點擊Network項。這時候就來到了網絡監聽窗口,在這個頁面中發送的所有網絡請求,都會在Network這個地方顯示出來,如果是空白的,點擊XHR。接著我們在翻譯的窗口輸入我們需要翻譯的文字,比如輸入hell。然后點擊自動翻譯按鈕,那么接下來在下面就可以看到瀏覽器給有道發送的請求,這里截個圖看看:

點擊鏈接,就可以看到整個請求的信息。包括請求頭,請求參數,響應結果。

這里面有一個問題就是參數進行了加密。我們需要知道這些參數是如何加密的。

破解加密難題

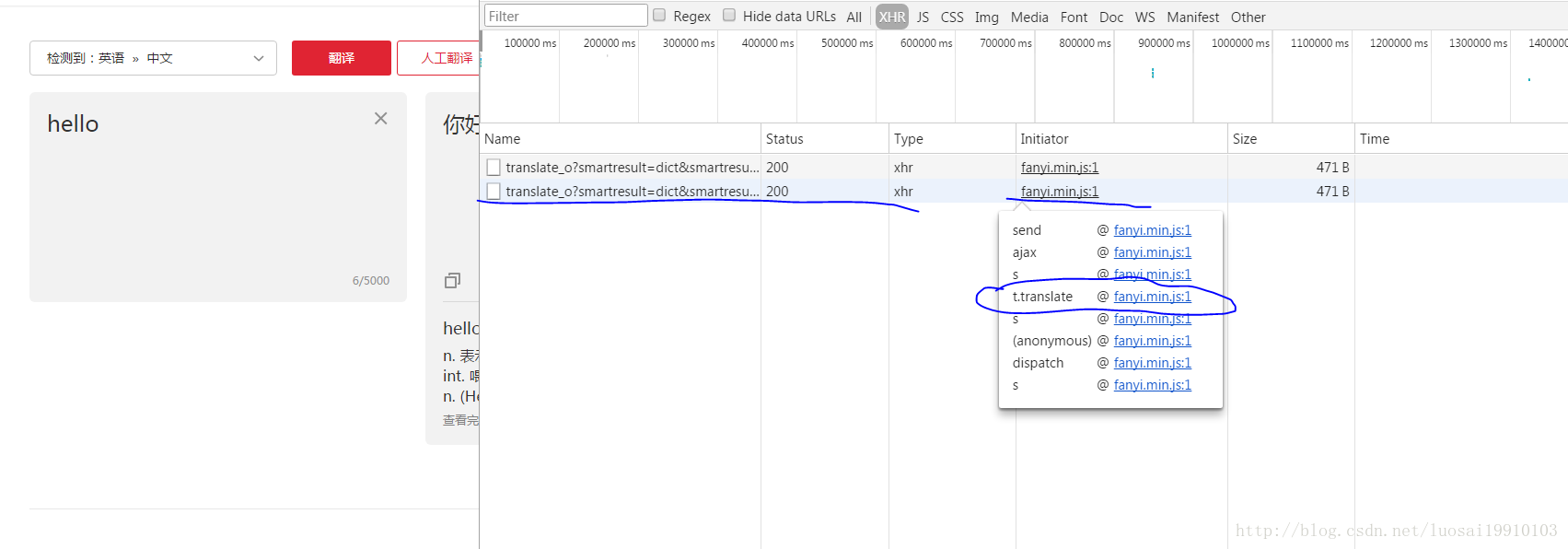

要想知道如何加密的,需要查看源碼。于是我們需要知道發起這個請求的js文件。在文件查找這個相關代碼。剛才我們監聽了網絡請求,可以看到發起請求的js文件。那么接下來查找發起請求的鏈路,鼠標浮到請求文件上,顯示了一系列執行方法,我們點擊跟業務相關的那個方法對應的文件鏈接,這里是t.translate 對應的連接。

點擊進入查看對應的源碼

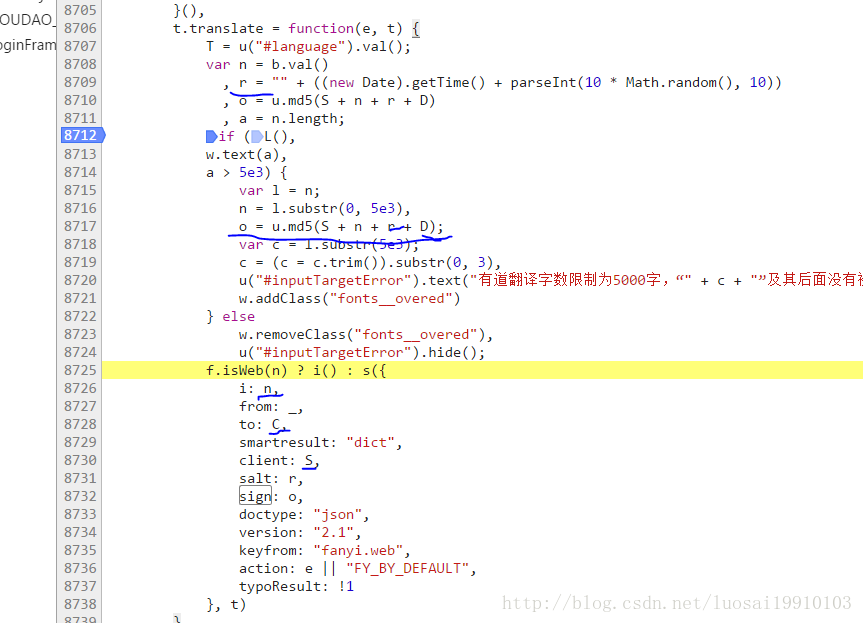

我們可以看到i,salt,sign是變量,其他的請求參數是常量。i是需要翻譯的字符串,salt是時間戳生成的13位,sign是S+n+r+D

也就S是client的值,也就是fanyideskweb. 我們查找D 這個常量,在底欄輸入框輸入 D = (空格D空格=空格;格式化后的代碼規范)點擊右邊的Aa讓搜索時大小寫敏感。回車查找到下一個,直到找到對應的值。

在上圖我們看到了_,C,S,D等常量。

于是你以為構建一個請求,傳好這些參數就ok了。別忘了,為了反爬蟲,都是會校驗請求頭。于是要模擬瀏覽器的請求頭。經過驗證只需要User-Agent,Referer,Cookie 三個請求頭。

實現代碼:

# -*- coding: utf-8 -*-

from urllib import request,parse

import json

import time

from hashlib import md5

'''

def dicToSortedStrParam(dic={}):

keyList = sorted(dic)

str =""

for i,key in enumerate(keyList):

if i==len(keyList)-1:

str += key +"="+ dic[key]

else:

str += key +"="+ dic[key] + "&"

pass

return str

'''

def create_md5(data):

md5_obj = md5()

md5_obj.update(data.encode("utf-8"))

return md5_obj.hexdigest()

if __name__ == "__main__":

request_url = "http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule"

translate = "hell"

c = "fanyideskweb"

data = {}

data["i"] = translate

data["from"] = "AUTO"

data["to"] = "AUTO"

data["smartresult"] = "dict"

data["client"] = c

data["doctype"] = "json"

data["version"] = "2.1"

data["keyfrom"] = "fanyi.web"

data["action"] = "FY_BY_REALTIME"

data["typoResult"] = "false"

salt = str(int(round(time.time(),3)*1000))

# 加密

data["salt"] = salt

# a = "rY0D^0'nM0}g5Mm1z%1G4" 網上別人的 也可以

a = "ebSeFb%=XZ%T[KZ)c(sy!"

sign = create_md5(c+translate+salt+a)

data["sign"] = sign

headers = {}

headers["User-Agent"] = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36"

# headers["Content-Type"] = "application/x-www-form-urlencoded; charset=UTF-8"

headers["Referer"] = "http://fanyi.youdao.com/"

# headers["Host"] = "fanyi.youdao.com"

# headers["Origin"]="http://fanyi.youdao.com"

headers["Cookie"]="OUTFOX_SEARCH_USER_ID=-948455480@10.169.0.83; " \

"JSESSIONID=aaajvZPcjhFWbgtIBPuiw; " \

"OUTFOX_SEARCH_USER_ID_NCOO=1148682548.6241577;" \

" fanyi-ad-id=41685; fanyi-ad-closed=1; ___rl__test__cookies="+salt

data = parse.urlencode(data).encode('utf-8')

request1 = request.Request(request_url,data,headers = headers)

response = request.urlopen(request1)

print(response.info())

#讀取信息并解碼

html = response.read().decode('utf-8')

print(html)

#使用JSON

translate_results = json.loads(html)

# 找到翻譯結果

translate_results = translate_results['translateResult'][0][0]['tgt']

# 打印翻譯信息

print("翻譯的結果是:%s" % translate_results)翻譯結果:

{"translateResult":[[{"tgt":"地獄","src":"hell"}]],"errorCode":0,"type":"en2zh-CHS","smartResult":{"entries":["","n. 地獄;究竟(作加強語氣詞);訓斥;黑暗勢力\r\n","vi. 過放蕩生活;飛馳\r\n","int. 該死;見鬼(表示驚奇、煩惱、厭惡、惱怒、失望等)\r\n"],"type":1}}

翻譯的結果是:地獄感謝各位的閱讀!關于“怎么用python3 urllib破解有道翻譯反爬蟲機制”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,讓大家可以學到更多知識,如果覺得文章不錯,可以把它分享出去讓更多的人看到吧!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。