您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要為大家展示了“Python中Tensor FLow怎么用”,內容簡而易懂,條理清晰,希望能夠幫助大家解決疑惑,下面讓小編帶領大家一起研究并學習一下“Python中Tensor FLow怎么用”這篇文章吧。

Tensor表示張量,是一種多維數組的數據結構。Flow代表流,是指張量之間通過計算而轉換的過程。TensorFLow通過一個計算圖的形式表示編程過程,數據在每個節點之間流動,經過節點加工之后流向下一個節點。

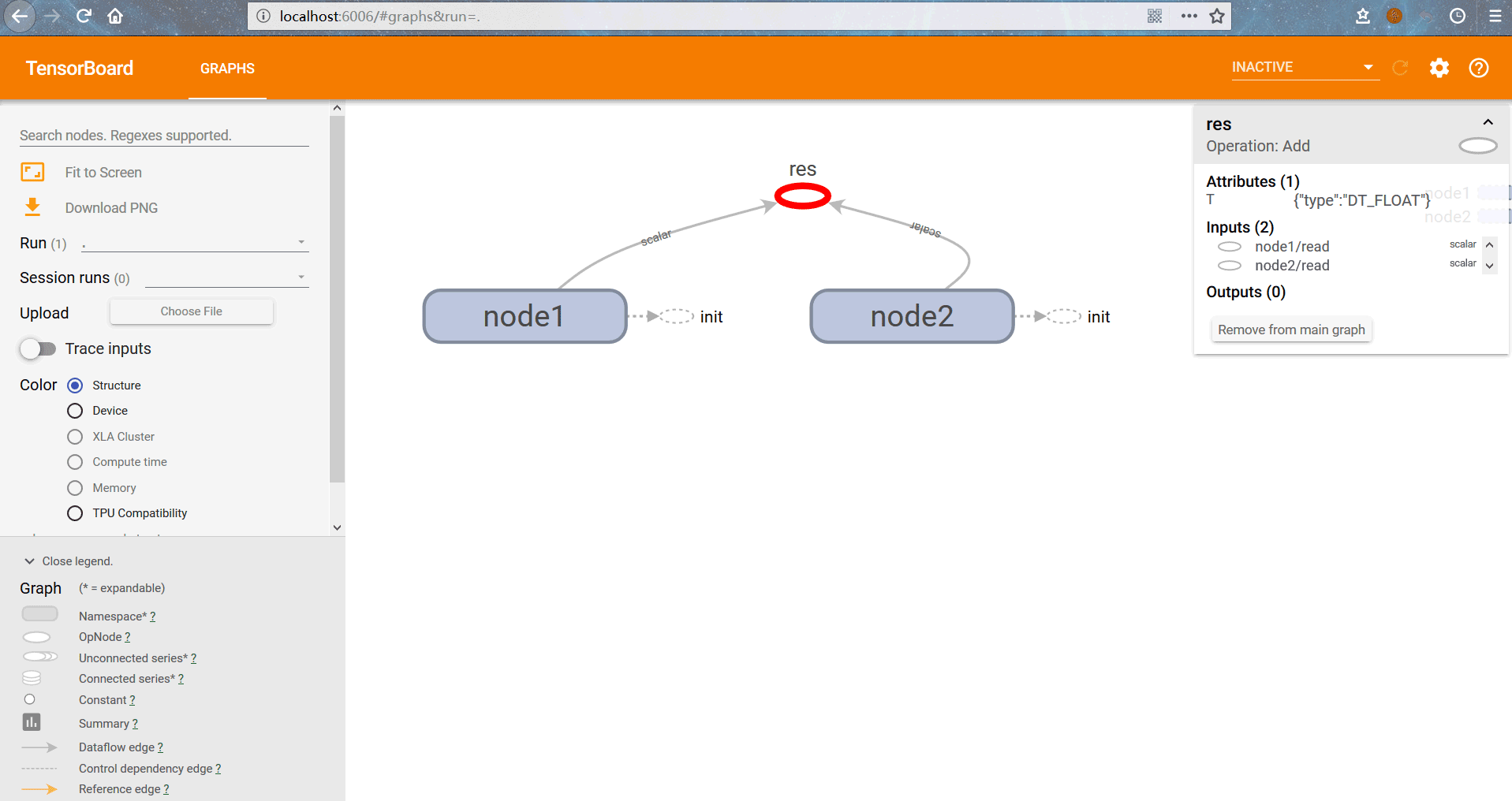

計算圖是一個有向圖,其組成如下:節點:代表一個操作。邊:代表節點之間的數據傳遞和控制依賴,其中實線代表兩個節點之間的數據傳遞關系,虛線代表兩個節點之間存在控制相關。

張量是所有數據的表示形式,可以將其理解為一個多維數組。零階張量就是標量(scalar),表示一個數,一階張量為一維數組,即向量(vector)。n階張量也就是n維數組。張量并不保存具體數字,它保存的是計算過程。

下面的例子是將節點1、2的值相加得到節點3。

import tensorflow as tf

node1=tf.constant(3.0,tf.float32,name='node1') #創建浮點數節點

node2=tf.constant(4.0,tf.float32,name='node2')

node3=tf.add(node1,node2) #節點三進行相加操作,源于節點1、2

ses=tf.Session()

print(node3) #輸出張量:Tensor("Add_3:0", shape=(), dtype=float32)

print(ses.run(node3)) #通過會話運行節點三,將節點1、2相加,輸出:7.0

ses.close() #不使用時,關閉會話直接print(node3)輸出的結果不是具體的值,而是張量結構。因為創建計算圖只是建立了計算模型,只有會話執行run()才能獲得具體結果。

Tensor("Add_3:0", shape=(), dtype=float32)中,Add表示節點名稱,3表示這是該節點的第3個輸出。shape表示張量的維度信息,()代表標量。dtype表示張量的類型,每個張量的類型唯一,如果不匹配會報錯,不帶小數點的默認類型為int32,帶小數點默認為float35。下面的例子為更復雜的張量類型:

tensor1=tf.constant([[[1,1,1],[1,2,1]],

[[2,1,1],[2,2,1]],

[[3,1,1],[3,2,1]],

[[4,1,1],[4,2,1]]],name='tensor1')

print(tensor1)

ss=tf.Session()

print(ss.run(tensor1)[3,0,0]) #訪問tensor1的具體元素

#輸出:Tensor("tensor1:0", shape=(4, 2, 3), dtype=int32) 4其中shape=(4,2,3)表示tensor1的最外層有4個數組,每個數組內有2個子數組,子數組由3個數字構成。可以通過多維數組的方式訪問其中的具體元素,[3,0,0]即為第四個數組中第一個子數組的第一個元素,4。

計算圖中還有的節點表示操作,例如加減乘除、賦初值等,操作有自己的屬性,需要在創建圖的時候就確定,操作之間有先后等依賴關系,通過圖的邊可以直觀地看出來。

會話(Session)擁有并管理TensorFLow的所有資源,通過Session運行計算才能得到結果,計算完成后記得關閉會話回收資源。下面是使用Session的流程:

#定義計算圖 tensor1=tf.constant([1,2,3]) #創建會話 ss=tf.Session() #利用會話進行計算操作 print(ss.run(tensor1)) #關閉會話 ss.close()

也可以通過python上下文管理器來使用Session,當退出上下文時會自動關閉Session并釋放資源

tensor1=tf.constant([1,2,3]) with tf.Session() as ss: #上下文管理器 print(ss.run(tensor1))

還可以通過指定默認會話,使用eval()獲取張量的值:

tensor1=tf.constant([1,2,3]) ss=tf.Session() with ss.as_default(): #指定默認會話 print(tensor1.eval())

在交互式環境下通過InteractiveSession()自動將生成的會話設為默認:

tensor1=tf.constant([1,2,3]) ss=tf.InteractiveSession() #自動注冊默認會話 print(tensor1.eval()) ss.close()

TensorFLow通過constant函數完成對常量的定義,可以為其賦初值與命名

a=tf.constant(10,'int_a')

而變量不僅需要定義,還需要經過初始化后才可以使用,初始化操作不僅需要定義,還需要執行

node1=tf.Variable(3.0,name='node1') #定義變量 node2=tf.Variable(4.0,name='node2') res=tf.add(node1,node2,name='res') ss=tf.Session() init=tf.global_variables_initializer() #定義全部變量的初始化操作 ss.run(init) #執行初始化操作 print(ss.run(res)) ss.close()

TensorFLow的變量一般不需要手動賦值,因為系統會在訓練過程中自動調整。如果不希望由模型自動賦值,可以在定義時指定屬性trainable=False,并通過assign函數來手動賦值

var1=tf.Variable(0,name='var') one=tf.constant(1) var2=tf.add(var1,one) #變量1加1得到變量2 update=tf.assign(var1,var2) #定義update操作,將變量2賦值給變量1 init=tf.global_variables_initializer() ss=tf.Session() ss.run(init) for _ in range(10): ss.run(update) #執行update操作 print(ss.run(var1)) ss.close() #輸出:1 2 3 4 5 6 7 8 9 10

在執行ss.run(update)操作時,由于update需要var1和var2依賴,而得到var2需要執行add操作,因此只需要run一個update就會觸發整個計算網絡。

有時在定義變量的時候,并不知道它的具體值,只有在運行的時候才輸入對應數值,而tensorflow中變量的定義需要賦初值,這時就需要使用占位符placeholder來進行定義,并在計算時傳入具體數值。一個簡單的使用例子:

node1=tf.placeholder(tf.float32,name='node1') #定義占位符,規定其類型、結構、名字

node2=tf.placeholder(tf.float32,name='node2')

m=tf.multiply(node1,node2,'multinode')

ss=tf.Session()

res=ss.run(m,feed_dict={node1:1.2,node2:3.4}) #在運行時通過feed_dict為占位符賦值

print(res)

ss.close()也可以把多個操作放到一次feed操作完成

node1=tf.placeholder(tf.float32,[3],name='node1') #第二個參數規定占位符的類型為3維數組

node2=tf.placeholder(tf.float32,[3],name='node2')

m=tf.multiply(node1,node2,'multinode')

s=tf.subtract(node1,node2,'subnode')

ss=tf.Session()

#將m,s兩個操作放到一起,并返回兩個結果

resm,ress=ss.run([m,s],feed_dict={node1:[1.0,2.0,4.0],node2:[3.0,5.0,6.0]})

print(resm) #輸出:[ 3. 10. 24.]

ss.close()TensorBoard是TensorFLow的可視化工具,通過程序運行中輸出的日志文件可視化地表示TensorFLow的運行狀態。其編程如下:

node1=tf.Variable(3.0,name='node1') node2=tf.Variable(4.0,name='node2') res=tf.add(node1,node2,name='res') ss=tf.Session() init=tf.global_variables_initializer() ss.run(init) print(ss.run(res)) ss.close() #清除default graph和其他節點 tf.reset_default_graph() #定義日志存放的默認路徑 logdir='D:\Temp\TensorLog' #生成writer將當前的計算圖寫入日志 writer=tf.summary.FileWriter(logdir,tf.get_default_graph()) writer.close()

TensorBoard已經隨Anaconda安裝完成,首先通過Anaconda Prompt進入日志文件的存放目錄,然后輸入tensorboard --logdir=D:\Temp\TensorLog,設定日志的存放路徑,完成之后在瀏覽器的localhost:6006端口就可以看到TensorBoard,也可以通過--port命令修改默認端口。

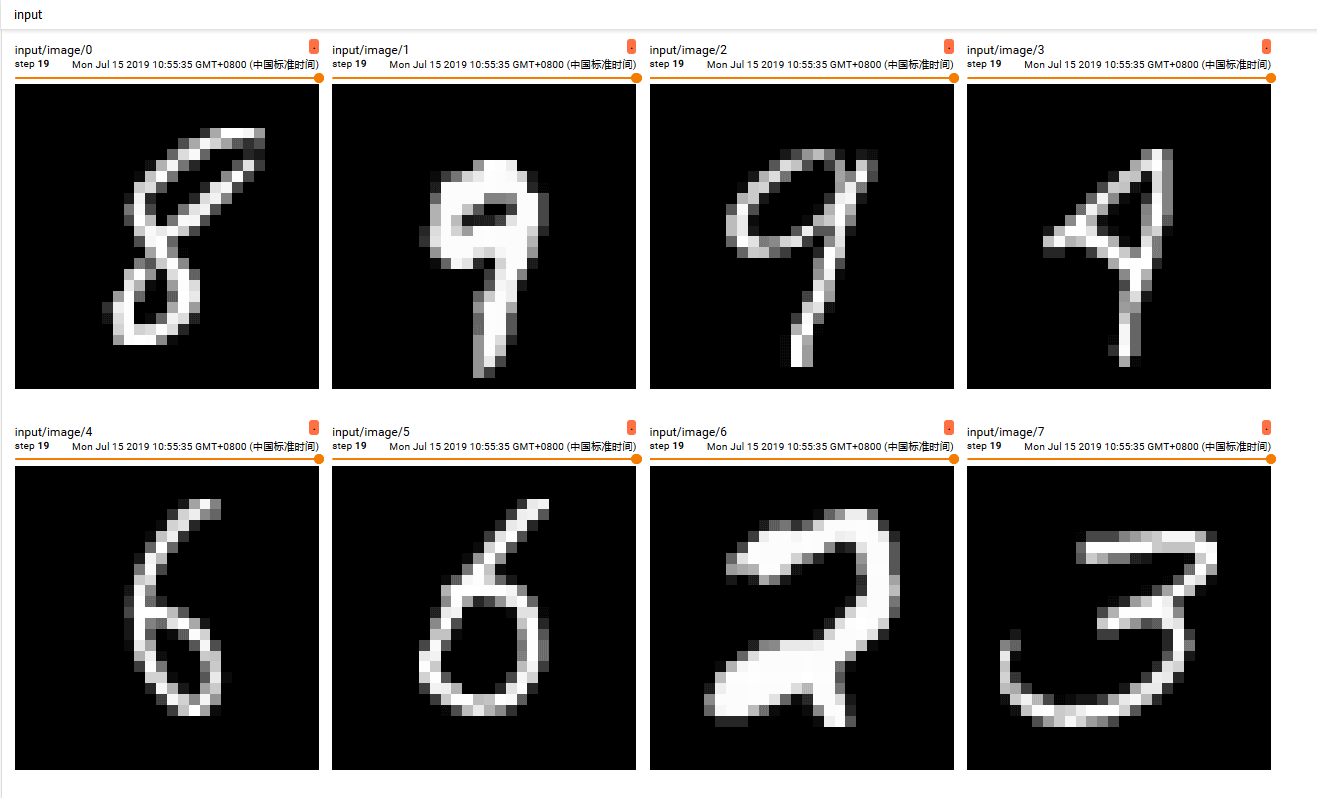

利用TensorBoard顯示圖片,通過summary.image()將格式化的圖片數據顯示,其中輸入的image_imput數據是四維格式,第一維表示一次輸入幾行數據,-1表示不確定。28,28,1表示圖片數據為28×28大小,且其色彩通道為1。

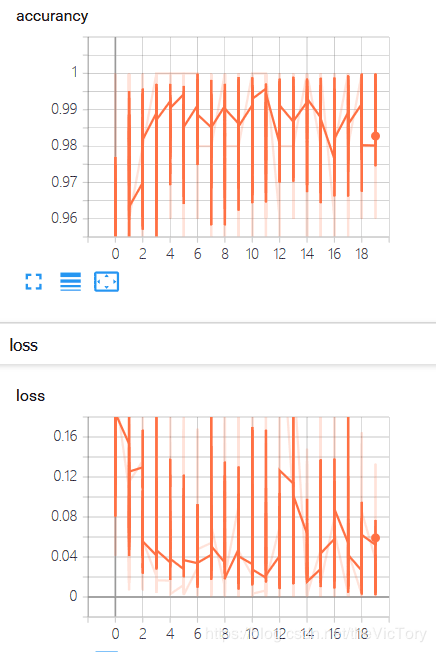

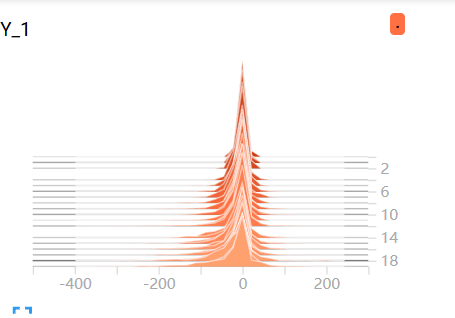

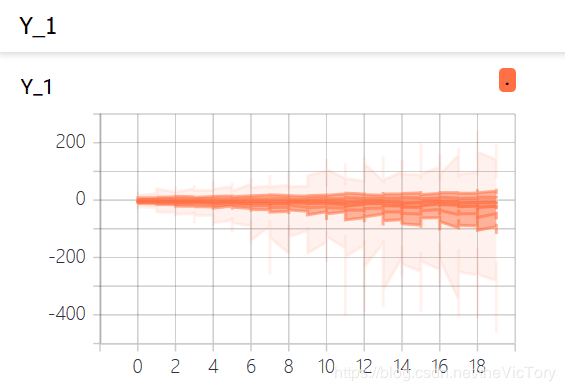

通過summary.histogram()可以顯示直方圖數據。通過summary.scalar()可以顯示標量數據。在所有summary定義完成后,可以通過summary.merge_all()函數定義一個匯總操作,將所有summary聚合起來。

在創建session后定義writer用于日志文件的寫入,在進行訓練時,每批次訓練都將執行一次merge操作,并將結果寫入日志。

如下為通過多層神經網絡解決MNIST手寫識別問題的例子,將其中的一些數據通過TensorBoard顯示出來:

#TensorBoard使用

#定義日志保存位置

log_dir='D:\Temp\MachineLearning\TensorLog'

#顯示圖片

image_input=tf.reshape(x,[-1,28,28,1])

tf.summary.image('input',image_input,10) #一次最多顯示圖片數:10

#顯示直方圖

tf.summary.histogram('Y',Y3)

#顯示標量loss

tf.summary.scalar('loss',loss_function)

tf.summary.scalar('accurancy',accuracy)

#定義匯總summary操作

merge_op=tf.summary.merge_all()

ss=tf.Session()

ss.run(tf.global_variables_initializer())

#定義writer

writer=tf.summary.FileWriter(log_dir,ss.graph)

for epoch in range(train_epochs):

for batch in range(batch_num): #分批次讀取數據進行訓練

xs,ys=mnist.train.next_batch(batch_size)

ss.run(optimizer,feed_dict={x:xs,y:ys})

#執行summary操作并將結果寫入日志文件

summary_str=ss.run(merge_op,feed_dict={x:xs,y:ys})

writer.add_summary(summary_str,epoch)

loss,acc=ss.run([loss_function,accuracy],\

feed_dict={x:mnist.validation.images,y:mnist.validation.labels})

print('第%2d輪訓練:損失為:%9f,準確率:%.4f'%(epoch+1,loss,acc))運行結果如下圖所示分別為圖片、accuracy、loss標量圖、Y1直方圖以及隨之生成的分布圖:

以上是“Python中Tensor FLow怎么用”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。