您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹了OpenCV光流Optical Flow怎么實現的相關知識,內容詳細易懂,操作簡單快捷,具有一定借鑒價值,相信大家閱讀完這篇OpenCV光流Optical Flow怎么實現文章都會有所收獲,下面我們一起來看看吧。

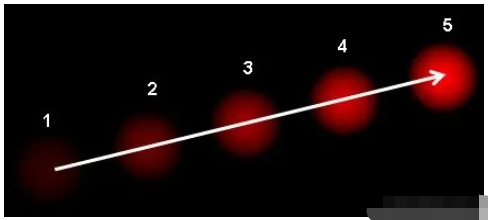

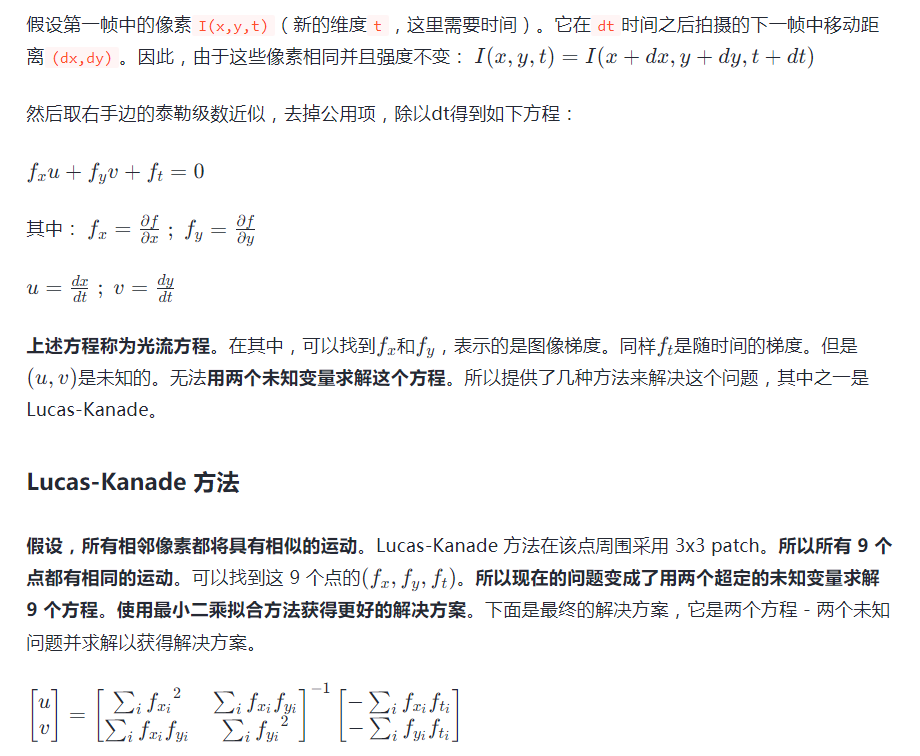

光流是由物體或相機的運動引起的圖像物體在兩個連續幀之間的明顯運動的模式。它是二維向量場,其中每個向量都是一個位移向量,顯示點從第一幀到第二幀的移動。如下圖所示。

它顯示了一個球在連續 5 幀中移動。箭頭表示其位移矢量。光流在以下領域有許多應用:

運動結構

視頻壓縮

視頻穩定

...

光流基于以下幾個假設:

對象的像素強度在連續幀之間不會改變

相鄰像素具有相似的運動

(用 Harris 角點檢測器檢查逆矩陣的相似性。它表示角點是更好的跟蹤點。)

所以從用戶的角度來看,這個想法很簡單,給出了一些要追蹤的要點,收到了這些點的光學流量矢量。但是,還有一些問題。到目前為止,正在處理的是小的動作,因此當有很大的動作時它失敗了。要處理這一點,需要使用金字塔。當在金字塔上采樣時,會消除小型動作,大的運動會變小。因此,通過在那里應用Lucas-Kanade,將光流與縮放合在一起了。

OpenCV的cv2.calcOpticalFlowPyrLK() 提供了所有這些功能。下面創建一個簡單的應用程序來跟蹤視頻中的某些點。為了確定點,使用cv2.goodFeaturesToTrack()。取第一幀,檢測其中的一些 Shi-Tomasi 角點,然后使用 Lucas-Kanade 光流迭代跟蹤這些點。對于函數cv2.calcOpticalFlowPyrLK(),傳遞前一幀、前面的點和下一幀。它返回之后的點以及一些狀態編號,如果找到之后的點,則值為 1,否則為零。在下一步中迭代地將這些點作為前面的點傳遞,迭代進行。

import cv2

import numpy as np

video_file = 'slow_traffic_small.mp4'

cap = cv2.VideoCapture(video_file)

# params for ShiTomasi corner detection

feature_params = dict( maxCorners = 100,

qualityLevel = 0.3,

minDistance = 7,

blockSize = 7 )

# Parameters for lucas kanade optical flow

lk_params = dict(

winSize = (15, 15),

maxLevel = 2,

criteria = (cv2.TERM_CRITERIA_EPS | cv2.TERM_CRITERIA_COUNT, 10, 0.03))

# create some random colors

color = np.random.randint(0, 255, (100, 3))

# Take first frame and find corners in it

ret, old_frame = cap.read()

old_gray = cv2.cvtColor(old_frame, cv2.COLOR_BGR2GRAY)

p0 = cv2.goodFeaturesToTrack(old_gray, mask=None, **feature_params)

# create a mask image for drawing purpose

mask = np.zeros_like(old_frame)

while True:

ret, frame = cap.read()

if ret:

frame_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# calculate optical flow

p1, st, err = cv2.calcOpticalFlowPyrLK(old_gray, frame_gray, p0, None, **lk_params)

# Select good points

if p1 is not None:

good_new = p1[st==1]

good_old = p0[st==1]

# draw the tracks

for i,(new, old) in enumerate(zip(good_new, good_old)):

a, b = new.ravel()

c, d = old.ravel()

mask = cv2.line(mask, (int(a), int(b)), (int(c), int(d)), color[i].tolist(), 2)

frame = cv2.circle(frame, (int(a), int(b)), 5, color[i].tolist(), -1)

img = cv2.add(frame,mask)

cv2.imshow('frame',img)

k = cv2.waitKey(30) & 0xff

if k == 27:

cv2.destroyAllWindows()

break

# Now update the previous frame and previous points

old_gray = frame_gray.copy()

p0 = good_new.reshape(-1,1,2)

else:

cv2.destroyAllWindows()

break上述代碼沒有檢查下一個關鍵點的正確程度。因此,即使圖像中任何一個特征點消失,光流也有可能找到下一個看起來可能靠近它的點。實際上, 對于穩健的跟蹤,角點應該在特定的時間間隔內檢測點。OpenCV sample提出了這樣一個例子,它每 5 幀找到一次特征點,還運行對光流點的向后檢查,只選擇好的點 )。

Lucas-Kanade 方法計算稀疏特征集的光流(在示例中,使用 Shi-Tomasi 算法檢測到的角點)。OpenCV 提供了另一種算法來尋找密集光流。它計算幀中所有點的光流。它基于 Gunner Farneback 的算法,該算法在 Gunner Farneback 于 2003 年在“Two-Frame Motion Estimation Based on Polynomial Expansion”中進行了解釋。

下面的示例顯示了如何使用上述算法找到密集光流。首先得到一個帶有光流向量(u,v)(u,v)(u,v)的 2通道向量,找到它們的大小和方向。對結果進行顏色編碼以實現更好的可視化。方向對應于圖像的色調值(Hue),幅度對應于值屏幕。代碼如下:

import cv2

import numpy as np

cap = cv2.VideoCapture("vtest.avi")

ret, frame1 = cap.read()

frame1_gray = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(frame1)

hsv[...,1] = 255

while(1):

ret, frame2 = cap.read()

if ret:

frame2_gray = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

flow = cv2.calcOpticalFlowFarneback(frame1_gray, frame2_gray, None, 0.5, 3, 15, 3, 5, 1.2, 0)

mag, ang = cv2.cartToPolar(flow[...,0], flow[...,1])

hsv[...,0] = ang*180/np.pi/2

hsv[...,2] = cv2.normalize(mag, None, 0, 255, cv2.NORM_MINMAX)

bgr = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

cv2.imshow('frame2', bgr)

k = cv2.waitKey(30) & 0xff

if k == 27:

cv2.destroyAllWindows()

break

elif k == ord('s'):

cv2.imwrite('opticalfb.png',frame2)

cv2.imwrite('opticalhsv.png',bgr)

frame1_gray = frame2_gray

else:

cv2.destroyAllWindows()

break關于“OpenCV光流Optical Flow怎么實現”這篇文章的內容就介紹到這里,感謝各位的閱讀!相信大家對“OpenCV光流Optical Flow怎么實現”知識都有一定的了解,大家如果還想學習更多知識,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。