您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“怎么使用Python處理文本數據”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

實驗目的

熟悉python的基本數據結構,以及文件的輸入與輸出。

實驗數據

利用xxxx年xx機器學習會議的評測數據和評測任務,數據包括訓練集和測試集,評測任務為通過給定的訓練數據,預測測試集中的關系是正例還是負例,在每個樣本最后給出1或者0。

數據描述如下,第一列為關系類型,第二列和第三列為人名,第四列是標題,第五列是關系為正例還是負例,1為正例,0為負例;第六列表示訓練集。

| 事件 | 人物1 | 人物2 | 標題 | 關系(0 or 1) | 訓練集 |

|---|

測試集描述如下圖,格式基本與訓練集類似,唯一不同的是第五列沒有關系是正例還是負例的標記。

| 關系 | 人物1 | 人物2 | 事件 |

|---|

實驗內容

對訓練集數據進行處理,只留下前面五列,輸出文本命名為exp1_1.txt。

在第一步得到的數據的基礎上對19類關系進行分類,生成的文本存放在exp1_train文件夾下,按照關系類別出現的順序,第一個關系類別的數據存放在1.txt中,第二個關系類別存放在2.txt中,直到19.txt。

測試集按照訓練集的19個類別的順序將各個樣本按照關系類別歸類,即相同關系類型的數據放到一個文本文件中,同樣生成19個類別的測試文件,格式仍舊和測試文件保持一致。存放在exp1_test文件夾下,每個類別的文件仍舊命名為1_test.txt,2_test.txt…同時對每個樣本在原測試集中出現的位置進行記錄,和19個測試文件一一對應起來。比如第一類“傳聞不和”的每個樣本在原文中處于第幾行,在索引文件中進行記錄,保存在文件index1.txt,index2.txt….

解題思路

1.第一題是考察我們文件操作與列表的知識,主要考察的難點是對new文件的讀取,根據要求處理后在生成一個txt文件,讓我們看一下具體的代碼實現:

import os

# 創建一個列表用來存儲新的內容

list = []

with open("task1.trainSentence.new", "r",encoding='xxx') as file_input: # 打開.new文件,xxx根據自己的編碼格式填寫

with open("exp1_1.txt", "w", encoding='xxx') as file_output: # 打開exp1_1.txt,xxx根據自己的編碼格式填寫文件如果沒有就創建一個

for Line in file_input: # 遍歷每一行的文件

arr = Line.split('\t') # 以\t為分隔符讀取

if arr[0] not in list: # if the word is not in the list

list.append(arr[0]) # add the word to the list

file_output.write(arr[0]+"\t"+arr[1]+"\t"+arr[2]+"\t"+arr[3]+"\t"+arr[4]+"\n") # write the line to the file

file_input.close() #關閉.new文件

file_output.close() #關閉創建的txt文件2.第二題依舊考察了文件操作,在題目一生成的文件基礎上,按照同一類型的事件對事件進行分類,是否能高效的分組需要利用循環條件來解決,我們來看看具體的

代碼實現

import os

file_1 = open("exp1_1.txt", encoding='xxx') # 打開文件,xxx根據自己的編碼格式填寫

os.mkdir("exp1_train") # 創建目錄

os.chdir("exp1_train") # 修改進程的工作目錄(使用該目錄)

a = file.readline() # 按行讀取exp1_1.txt文件

arr = a.split("\t") # 按\t間隔符作為分割

b = 1 #設置分組文件的序列

file_2 = open("{}.txt".format(b), "w", encoding="xxx") # 打開文件,xxx根據自己的編碼格式填寫

for line in file_1: # 按行讀取文件

arr_1 = line.split("\t") # 按\t間隔符作為分割

if arr[0] != arr_1[0]: # 如果讀取文件的第一列內容與存入新文件的第一列類型不同

file_2.close() # 關掉該文件

b += 1 # 文件序列加一

f_2 = open("{}.txt".format(b), "w", encoding="xxx") # 創建新文件,以另一種類型分類,xxx根據自己的編碼格式填寫

arr = line.split("\t") # 按\t間隔符作為分割

f_2.write(arr[0]+"\t"+arr[1]+"\t"+arr[2]+"\t"+arr[3]+"t"+arr[4]+"\t""\n") # 將相同類型的文件寫入

f_1.close() # 關閉題目一創建的exp1_1.txt文件

f_2.close() # 關閉創建的最后一個類型的文件3.將訓練集的19個類別按照人物的關系進行進一步的分類,我們可以通過字典對數據進行遍歷,查找關系,把關系相同的內容放到一個文件夾中,不同則新建一個。

import os

with open("exp1_1.txt", encoding='xxx') as file_in1: # 打開文件,xxx根據自己的編碼格式填寫

i = 1 # 類型序列

arr2 = {} # 創建字典

for line in file_in1: # 按行遍歷

arr3 = line[0:2] # 讀取關系

if arr3 not in arr2.keys():

arr2[arr3] = i

i += 1 # 類型+1

file_in = open("task1.test.new") # 打開文件task1.test.new

os.mkdir("exp1_test") # 創建目錄

os.chdir("exp1_test") # 修改進程的工作目錄(使用該目錄)

for line in file_in:

arr = line[0:2]

with open("{}_test.txt".format(arr2[arr]), "a", encoding='xxx') as file_out:

arr = line.split('\t')

file_out.write(line)

i = 1

file_in.seek(0)

os.mkdir("exp1_index")

os.chdir("exp1_index")

for line in file_in:

arr = line[0:2]

with open("index{}.txt".format(arr2[arr]), "a", encoding='xxx') as file_out:

arr = line.split('\t')

line = line[0:-1]

file_out.write(line + '\t' + "{}".format(i) + "\n")

i += 1實驗目的

熟悉python的基本數據結構,以及文件的輸入與輸出。

實驗數據

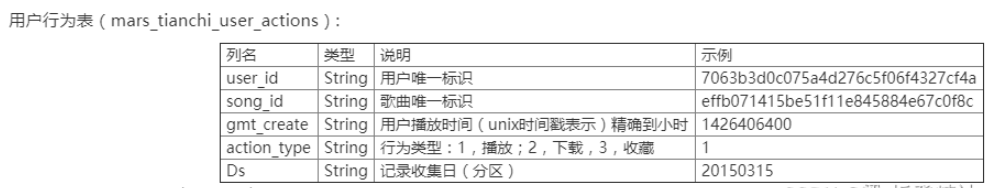

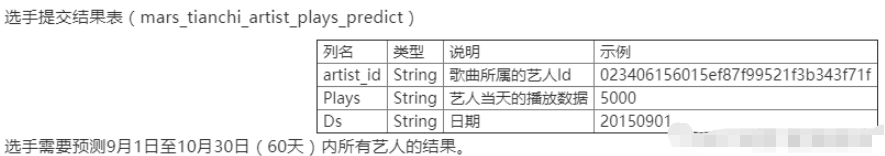

xxxx年xx天池大賽,也是中國高校第x屆大數據挑戰賽的數據。數據包括兩個表,分別是用戶行為表mars_tianchi_user_actions.csv和歌曲藝人表mars_tianchi_songs.csv。大賽開放抽樣的歌曲藝人數據,以及和這些藝人相關的6個月內(20150301-20150831)的用戶行為歷史記錄。選手需要預測藝人隨后2個月,即60天(20150901-20151030)的播放數據。

實驗內容

對歌曲藝人數據mars_tianchi_songs進行處理,統計出藝人的個數以及每個藝人的歌曲數量。輸出文件格式為exp2_1.csv,第一列為藝人的ID,第二列為該藝人的歌曲數目。最后一行輸出藝人的個數。

將用戶行為表和歌曲藝人表以歌曲song_id作為關聯,合并為一個大表。各列名稱為第一到第五列與用戶行為表的列名一致,第六到第十列為歌曲藝人表中的第二列到第六列的列名。輸出文件名為exp2_2.csv。

按照藝人統計每個藝人每天所有歌曲的播放量,輸出文件為exp2_3.csv,各個列名為藝人id,日期Ds,歌曲播放總量。注意:這里只統計歌曲的播放量,不包括下載和收藏的數量。

解題思路:(利用pandas庫)

1.

(1)利用.drop_duplicates() 刪除重復值

(2)利用.loc[:,‘artist_id’].value_counts() 求出歌手重復次數,即每個歌手的歌曲數目

(3)利用.loc[:,‘songs_id’].value_counts() 求出歌曲沒有重復

import pandas as pd

data = pd.read_csv(r"C:\mars_tianchi_songs.csv") # 讀取數據

Newdata = data.drop_duplicates(subset=['artist_id']) # 刪除重復值

artist_sum = Newdata['artist_id'].count()

#artistChongFu_count = data.duplicated(subset=['artist_id']).count() artistChongFu_count = data.loc[:,'artist_id'].value_counts() 重復次數,即每個歌手的歌曲數目

songChongFu_count = data.loc[:,'songs_id'].value_counts() # 沒有重復(歌手)

artistChongFu_count.loc['artist_sum'] = artist_sum # 沒有重復(歌曲)artistChongFu_count.to_csv('exp2_1.csv') # 輸出文件格式為exp2_1.csv利用merge()合并兩個表

import pandas as pd import os

data = pd.read_csv(r"C:\mars_tianchi_songs.csv")

data_two = pd.read_csv(r"C:\mars_tianchi_user_actions.csv")

num=pd.merge(data_two, data) num.to_csv('exp2_2.csv')利用groupby()[].sum()進行重復性相加

import pandas as pd

data =pd.read_csv('exp2_2.csv')

DataCHongfu = data.groupby(['artist_id','Ds'])['gmt_create'].sum()#重復項相加DataCHongfu.to_csv('exp2_3.csv')“怎么使用Python處理文本數據”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。