您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要講解了“Python內建類型str源碼分析”,文中的講解內容簡單清晰,易于學習與理解,下面請大家跟著小編的思路慢慢深入,一起來研究和學習“Python內建類型str源碼分析”吧!

計算機存儲的基本單位是字節,由8個比特位組成。由于英文只由26個字母加若干符號組成,因此英文字符可以直接用字節來保存。但是其他語言(例如中日韓等),由于字符眾多,不得不使用多個字節來進行編碼。

隨著計算機技術的傳播,非拉丁文字符編碼技術不斷發展,但是仍然存在兩個比較大的局限性:

不支持多語言:一種語言的編碼方案不能用于另外一種語言

沒有統一標準:例如中文就有GBK、GB2312、GB18030等多種編碼標準

由于編碼方式不統一,開發人員就需要在不同編碼之間來回轉換,不可避免地會出現很多錯誤。為了解決這類不統一問題,Unicode標準被提出了。Unicode對世界上大部分文字系統進行整理、編碼,讓計算機可以用統一的方式處理文本。Unicode目前已經收錄了超過14萬個字符,天然地支持多語言。(Unicode的uni就是“統一”的詞根)

Python在3之后,str對象內部改用Unicode表示,因此在源碼中成為Unicode對象。使用Unicode表示的好處是:程序核心邏輯統一使用Unicode,只需在輸入、輸出層進行解碼、編碼,可最大程度地避免各種編碼問題。

圖示如下:

問題:由于Unicode收錄字符已經超過14萬個,每個字符至少需要4個字節來保存(這里應該是因為2個字節不夠,所以才用4個字節,一般不會使用3個字節)。而英文字符用ASCII碼表示僅需要1個字節,使用Unicode反而會使頻繁使用的英文字符的開銷變為原來的4倍。

首先我們來看一下Python中不同形式的str對象的大小差異:

>>> sys.getsizeof('ab') - sys.getsizeof('a')

1

>>> sys.getsizeof('一二') - sys.getsizeof('一')

2

>>> sys.getsizeof('????????') - sys.getsizeof('????')

4由此可見,Python內部對Unicode對象進行了優化:根據文本內容,選擇底層存儲單元。

Unicode對象底層存儲根據文本字符的Unicode碼位范圍分成三類:

PyUnicode_1BYTE_KIND:所有字符碼位在U+0000到U+00FF之間

PyUnicode_2BYTE_KIND:所有字符碼位在U+0000到U+FFFF之間,且至少有一個字符的碼位大于U+00FF

PyUnicode_1BYTE_KIND:所有字符碼位在U+0000到U+10FFFF之間,且至少有一個字符的碼位大于U+FFFF

對應枚舉如下:

enum PyUnicode_Kind {

/* String contains only wstr byte characters. This is only possible

when the string was created with a legacy API and _PyUnicode_Ready()

has not been called yet. */

PyUnicode_WCHAR_KIND = 0,

/* Return values of the PyUnicode_KIND() macro: */

PyUnicode_1BYTE_KIND = 1,

PyUnicode_2BYTE_KIND = 2,

PyUnicode_4BYTE_KIND = 4

};根據不同的分類,選擇不同的存儲單元:

/* Py_UCS4 and Py_UCS2 are typedefs for the respective unicode representations. */ typedef uint32_t Py_UCS4; typedef uint16_t Py_UCS2; typedef uint8_t Py_UCS1;

對應關系如下:

| 文本類型 | 字符存儲單元 | 字符存儲單元大小(字節) |

|---|---|---|

| PyUnicode_1BYTE_KIND | Py_UCS1 | 1 |

| PyUnicode_2BYTE_KIND | Py_UCS2 | 2 |

| PyUnicode_4BYTE_KIND | Py_UCS4 | 4 |

由于Unicode內部存儲結構因文本類型而異,因此類型kind必須作為Unicode對象公共字段進行保存。Python內部定義了一些標志位,作為Unicode公共字段:(介于筆者水平有限,這里的字段在后續內容中不會全部介紹,大家后續可以自行了解。抱拳~)

interned:是否為interned機制維護

kind:類型,用于區分字符底層存儲單元大小

compact:內存分配方式,對象與文本緩沖區是否分離

asscii:文本是否均為純ASCII

通過PyUnicode_New函數,根據文本字符數size以及最大字符maxchar初始化Unicode對象。該函數主要是根據maxchar為Unicode對象選擇最緊湊的字符存儲單元以及底層結構體:(源碼比較長,這里就不列出了,大家可以自行了解,下面以表格形式展現)

| maxchar < 128 | 128 <= maxchar < 256 | 256 <= maxchar < 65536 | 65536 <= maxchar < MAX_UNICODE | |

|---|---|---|---|---|

| kind | PyUnicode_1BYTE_KIND | PyUnicode_1BYTE_KIND | PyUnicode_2BYTE_KIND | PyUnicode_4BYTE_KIND |

| ascii | 1 | 0 | 0 | 0 |

| 字符存儲單元大小(字節) | 1 | 1 | 2 | 4 |

| 底層結構體 | PyASCIIObject | PyCompactUnicodeObject | PyCompactUnicodeObject | PyCompactUnicodeObject |

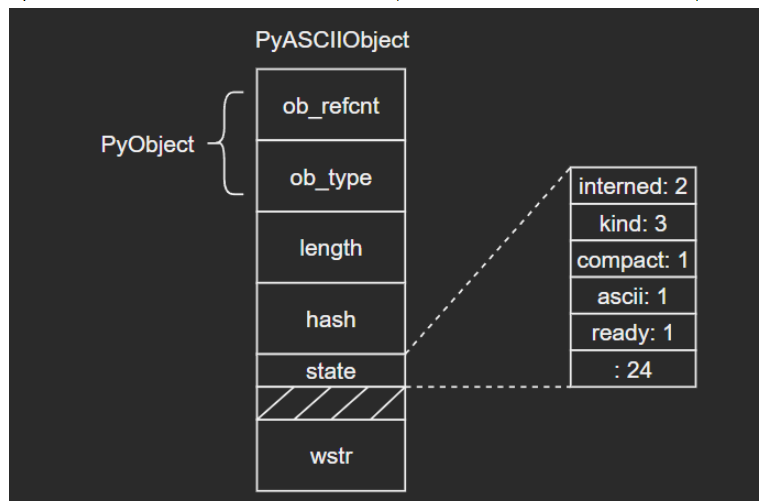

C源碼:

typedef struct {

PyObject_HEAD

Py_ssize_t length; /* Number of code points in the string */

Py_hash_t hash; /* Hash value; -1 if not set */

struct {

unsigned int interned:2;

unsigned int kind:3;

unsigned int compact:1;

unsigned int ascii:1;

unsigned int ready:1;

unsigned int :24;

} state;

wchar_t *wstr; /* wchar_t representation (null-terminated) */

} PyASCIIObject;源碼分析:

length:文本長度

hash:文本哈希值

state:Unicode對象標志位

wstr:緩存C字符串的一個wchar_t指針,以“\0”結束(這里和我看的另一篇文章講得不太一樣,另一個描述是:ASCII文本緊接著位于PyASCIIObject結構體后面,我個人覺得現在的這種說法比較準確,畢竟源碼結構體后面沒有別的字段了)

圖示如下:

(注意這里state字段后面有一個4字節大小的空洞,這是結構體字段內存對齊造成的現象,主要是為了優化內存訪問效率)

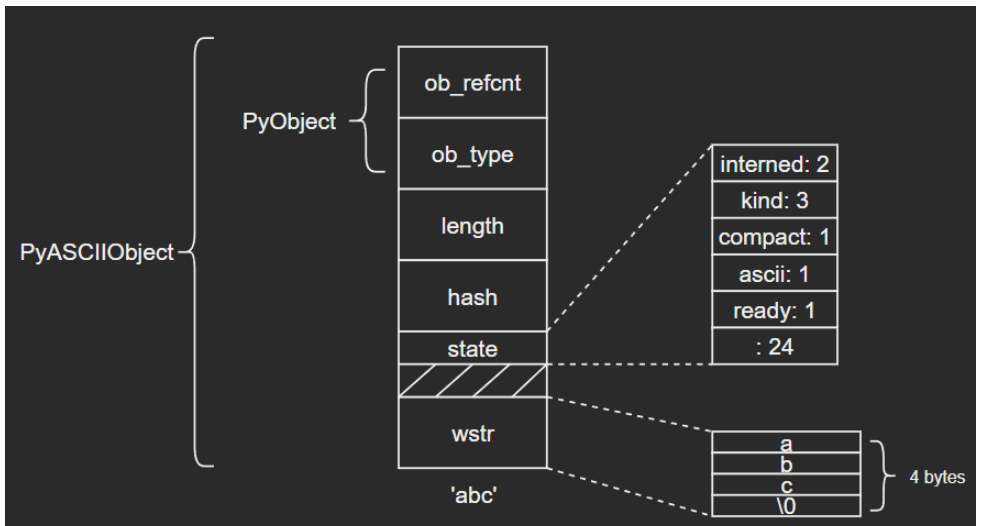

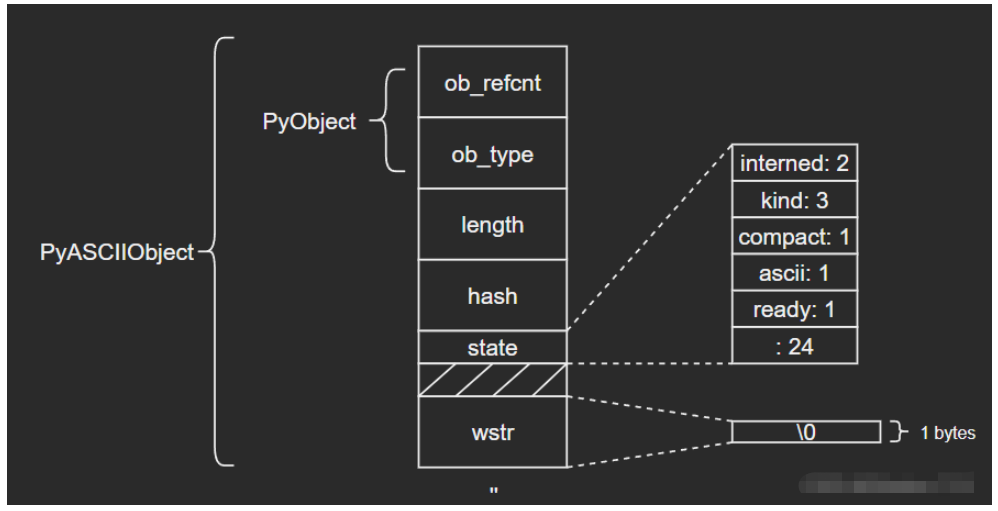

ASCII文本由wstr指向,以’abc’和空字符串對象’'為例:

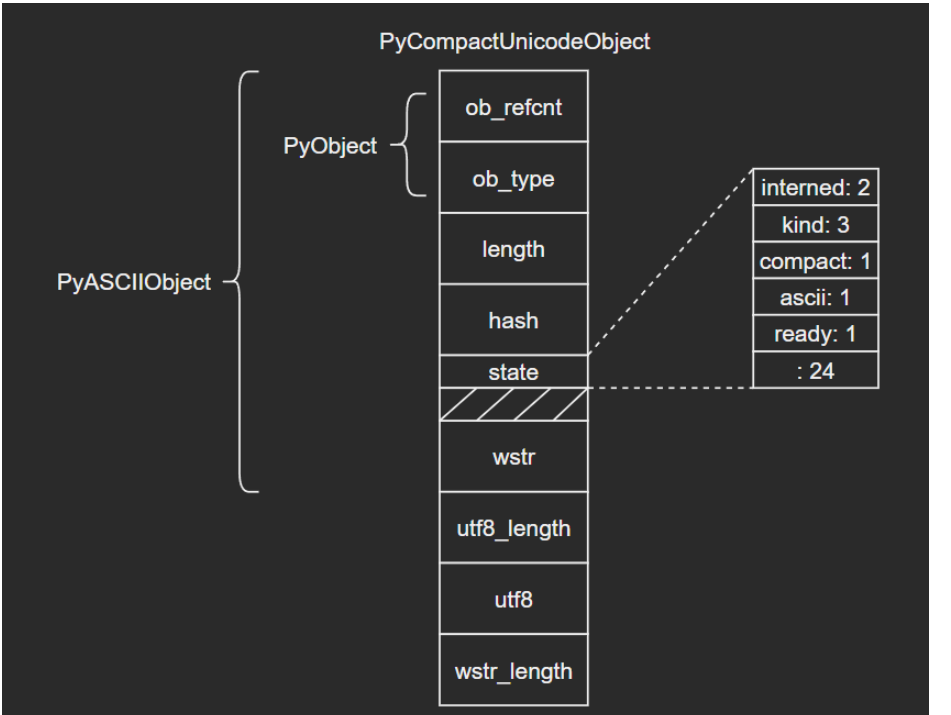

如果文本不全是ASCII,Unicode對象底層便由PyCompactUnicodeObject結構體保存。C源碼如下:

/* Non-ASCII strings allocated through PyUnicode_New use the

PyCompactUnicodeObject structure. state.compact is set, and the data

immediately follow the structure. */

typedef struct {

PyASCIIObject _base;

Py_ssize_t utf8_length; /* Number of bytes in utf8, excluding the

* terminating \0. */

char *utf8; /* UTF-8 representation (null-terminated) */

Py_ssize_t wstr_length; /* Number of code points in wstr, possible

* surrogates count as two code points. */

} PyCompactUnicodeObject;PyCompactUnicodeObject在PyASCIIObject的基礎上增加了3個字段:

utf8_length:文本UTF8編碼長度

utf8:文本UTF8編碼形式,緩存以避免重復編碼運算

wstr_length:wstr的“長度”(這里所謂的長度沒有找到很準確的說法,筆者也不太清楚怎么能打印出來,大家可以自行研究下)

注意到,PyASCIIObject中并沒有保存UTF8編碼形式,這是因為ASCII本身就是合法的UTF8,這也是ASCII文本底層由PyASCIIObject保存的原因。

結構圖示:

PyUnicodeObject則是Python中str對象的具體實現。C源碼如下:

/* Strings allocated through PyUnicode_FromUnicode(NULL, len) use the

PyUnicodeObject structure. The actual string data is initially in the wstr

block, and copied into the data block using _PyUnicode_Ready. */

typedef struct {

PyCompactUnicodeObject _base;

union {

void *any;

Py_UCS1 *latin1;

Py_UCS2 *ucs2;

Py_UCS4 *ucs4;

} data; /* Canonical, smallest-form Unicode buffer */

} PyUnicodeObject;在日常開發時,要結合實際情況注意字符串拼接前后的內存大小差別:

>>> import sys >>> text = 'a' * 1000 >>> sys.getsizeof(text) 1049 >>> text += '????' >>> sys.getsizeof(text) 4080

如果str對象的interned標志位為1,Python虛擬機將為其開啟interned機制,

源碼如下:(相關信息在網上可以看到很多說法和解釋,這里筆者能力有限,暫時沒有找到最確切的答案,之后補充。抱拳~但是我們通過分析源碼應該是能看出一些門道的)

/* This dictionary holds all interned unicode strings. Note that references

to strings in this dictionary are *not* counted in the string's ob_refcnt.

When the interned string reaches a refcnt of 0 the string deallocation

function will delete the reference from this dictionary.

Another way to look at this is that to say that the actual reference

count of a string is: s->ob_refcnt + (s->state ? 2 : 0)

*/

static PyObject *interned = NULL;

void

PyUnicode_InternInPlace(PyObject **p)

{

PyObject *s = *p;

PyObject *t;

#ifdef Py_DEBUG

assert(s != NULL);

assert(_PyUnicode_CHECK(s));

#else

if (s == NULL || !PyUnicode_Check(s))

return;

#endif

/* If it's a subclass, we don't really know what putting

it in the interned dict might do. */

if (!PyUnicode_CheckExact(s))

return;

if (PyUnicode_CHECK_INTERNED(s))

return;

if (interned == NULL) {

interned = PyDict_New();

if (interned == NULL) {

PyErr_Clear(); /* Don't leave an exception */

return;

}

}

Py_ALLOW_RECURSION

t = PyDict_SetDefault(interned, s, s);

Py_END_ALLOW_RECURSION

if (t == NULL) {

PyErr_Clear();

return;

}

if (t != s) {

Py_INCREF(t);

Py_SETREF(*p, t);

return;

}

/* The two references in interned are not counted by refcnt.

The deallocator will take care of this */

Py_REFCNT(s) -= 2;

_PyUnicode_STATE(s).interned = SSTATE_INTERNED_MORTAL;

}可以看到,源碼前面還是做一些基本的檢查。我們可以看一下37行和50行:將s添加到interned字典中時,其實s同時是key和value(這里我不太清楚為什么會這樣做),所以s對應的引用計數是+2了的(具體可以看PyDict_SetDefault()的源碼),所以在50行時會將計數-2,保證引用計數的正確。

考慮下面的場景:

>>> class User:

def __init__(self, name, age):

self.name = name

self.age = age

>>> user = User('Tom', 21)

>>> user.__dict__

{'name': 'Tom', 'age': 21}由于對象的屬性由dict保存,這意味著每個User對象都要保存一個str對象‘name’,這會浪費大量的內存。而str是不可變對象,因此Python內部將有潛在重復可能的字符串都做成單例模式,這就是interned機制。Python具體做法就是在內部維護一個全局dict對象,所有開啟interned機制的str對象均保存在這里,后續需要使用的時候,先創建,如果判斷已經維護了相同的字符串,就會將新創建的這個對象回收掉。

示例:

由不同運算生成’abc’,最后都是同一個對象:

>>> a = 'abc' >>> b = 'ab' + 'c' >>> id(a), id(b), a is b (2752416949872, 2752416949872, True)

感謝各位的閱讀,以上就是“Python內建類型str源碼分析”的內容了,經過本文的學習后,相信大家對Python內建類型str源碼分析這一問題有了更深刻的體會,具體使用情況還需要大家實踐驗證。這里是億速云,小編將為大家推送更多相關知識點的文章,歡迎關注!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。