您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“如何解決MyBatis原生批量插入的坑”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

首先,我們來看一下 MyBatis 原生批量插入中的坑,當我們批量插入 10 萬條數據時,實現代碼如下:

import com.example.demo.model.User;

import com.example.demo.service.impl.UserServiceImpl;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import java.util.ArrayList;

import java.util.List;

@SpringBootTest

class UserControllerTest {

// 最大循環次數

private static final int MAXCOUNT = 100000;

@Autowired

private UserServiceImpl userService;

/**

* 原生自己拼接 SQL,批量插入

*/

@Test

void saveBatchByNative() {

long stime = System.currentTimeMillis(); // 統計開始時間

List<User> list = new ArrayList<>();

for (int i = 0; i < MAXCOUNT; i++) {

User user = new User();

user.setName("test:" + i);

user.setPassword("123456");

list.add(user);

}

// 批量插入

userService.saveBatchByNative(list);

long etime = System.currentTimeMillis(); // 統計結束時間

System.out.println("執行時間:" + (etime - stime));

}

}核心文件 UserMapper.xml 中的實現代碼如下:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.example.demo.mapper.UserMapper">

<insert id="saveBatchByNative">

INSERT INTO `USER`(`NAME`,`PASSWORD`) VALUES

<foreach collection="list" separator="," item="item">

(#{item.name},#{item.password})

</foreach>

</insert>

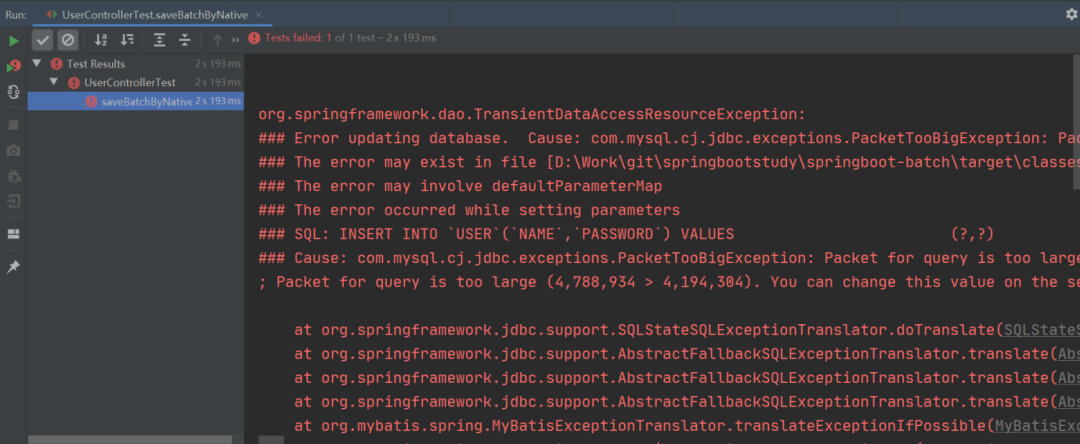

</mapper>當我們開心地運行以上程序時,就出現了以下的一幕:

沃,程序竟然報錯了!

這是因為使用 MyBatis 原生批量插入拼接的插入 SQL 大小是 4.56M,而默認情況下 MySQL 可以執行的最大 SQL 為 4M,那么在程序執行時就會報錯了。

以上的問題就是因為批量插入時拼接的 SQL 文件太大了,所以導致 MySQL 的執行報錯了。那么我們第一時間想到的解決方案就是將大文件分成 N 個小文件,這樣就不會因為 SQL 太大而導致執行報錯了。也就是說,我們可以將待插入的 List 集合分隔為多個小 List 來執行批量插入的操作,而這個操作過程就叫做 List 分片。

有了處理思路之后,接下來就是實操了,那如何對集合進行分片操作呢?

分片操作的實現方式有很多種,這個我們后文再講,接下來我們使用最簡單的方式,也就是 Google 提供的 Guava 框架來實現分片的功能。

要實現分片功能,第一步我們先要添加 Guava 框架的支持,在 pom.xml 中添加以下引用:

<!-- google guava 工具類 --> <!-- https://mvnrepository.com/artifact/com.google.guava/guava --> <dependency> <groupId>com.google.guava</groupId> <artifactId>guava</artifactId> <version>31.0.1-jre</version> </dependency>

接下來我們寫一個小小的 demo,將以下 7 個人名分為 3 組(每組最多 3 個),實現代碼如下:

import com.google.common.collect.Lists;

import java.util.Arrays;

import java.util.List;

/**

* Guava 分片

*/

public class PartitionByGuavaExample {

// 原集合

private static final List<String> OLD_LIST = Arrays.asList(

"唐僧,悟空,八戒,沙僧,曹操,劉備,孫權".split(","));

public static void main(String[] args) {

// 集合分片

List<List<String>> newList = Lists.partition(OLD_LIST, 3);

// 打印分片集合

newList.forEach(i -> {

System.out.println("集合長度:" + i.size());

});

}

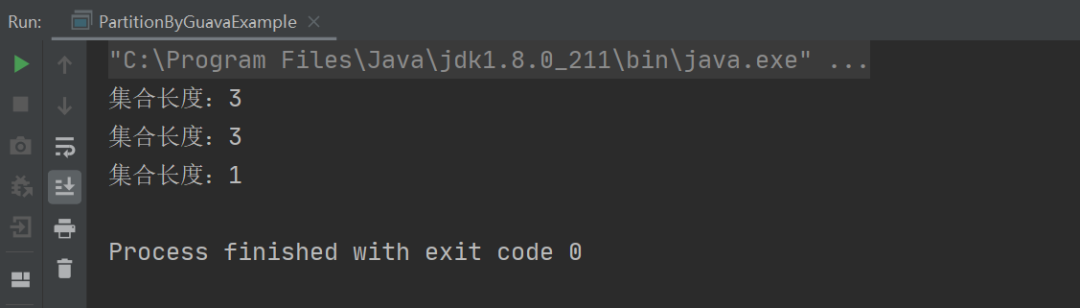

}以上程序的執行結果如下:

從上述結果可以看出,我們只需要使用 Guava 提供的 Lists.partition 方法就可以很輕松的將一個集合進行分片了。

那接下來,就是改造我們的 MyBatis 批量插入代碼了,具體實現如下:

@Test

void saveBatchByNativePartition() {

long stime = System.currentTimeMillis(); // 統計開始時間

List<User> list = new ArrayList<>();

// 構建插入數據

for (int i = 0; i < MAXCOUNT; i++) {

User user = new User();

user.setName("test:" + i);

user.setPassword("123456");

list.add(user);

}

// 分片批量插入

int count = (int) Math.ceil(MAXCOUNT / 1000.0); // 分為 n 份,每份 1000 條

List<List<User>> listPartition = Lists.partition(list, count);

// 分片批量插入

for (List<User> item : listPartition) {

userService.saveBatchByNative(item);

}

long etime = System.currentTimeMillis(); // 統計結束時間

System.out.println("執行時間:" + (etime - stime));

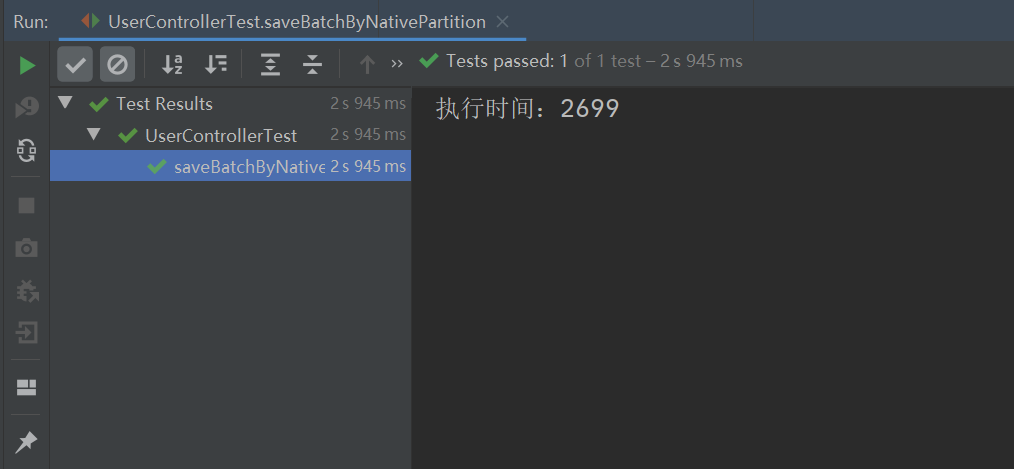

}執行以上程序,最終的執行結果如下:

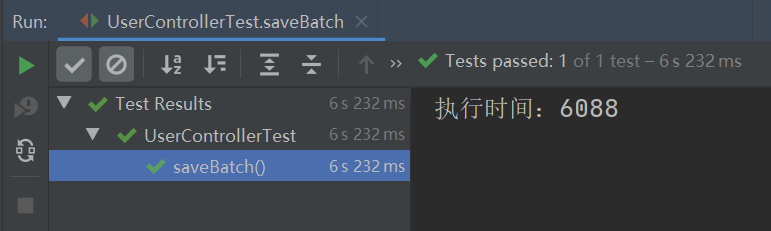

從上圖可以看出,之前批量插入時的異常報錯不見了,并且此實現方式的執行效率竟比 MyBatis Plus 的批量插入的執行效率要高,MyBatis Plus 批量插入 10W 條數據的執行時間如下:

“如何解決MyBatis原生批量插入的坑”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。