您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

今天就跟大家聊聊有關Hadoop集群怎么構建,可能很多人都不太了解,為了讓大家更加了解,小編給大家總結了以下內容,希望大家根據這篇文章可以有所收獲。

Apache tarball 二進制包 安裝靈活,工作量大

Packages 各個Linux 發行版提供的包

集群管理工具 Cloudera Manager 和Apache Ambari

Hadoop 運行在商業硬件上

商業硬件并不等同于低端硬件

也不推薦使用大型的數據庫級別的機器,性價比太低。

一般使用多核CPU和多磁盤

HDFS namenode 節點采用RAID, datanode 不建議使用RAID

集群規模

你的集群需要增長得多快?

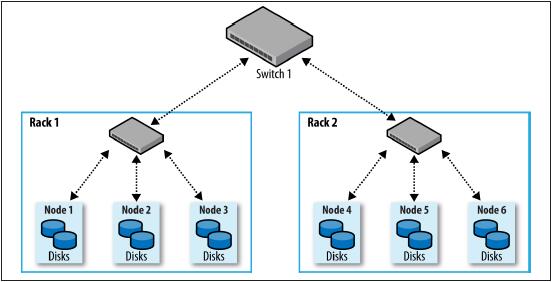

網絡拓撲

DNSToSwitchMapping

安裝Java

創建Unix 用戶賬號

解壓,額,最好不要放在home 目錄,因為home目錄可能掛載在NFS上

SSH 配置(分布式shell,公鑰共享)

配置Hadoop

格式化HDFS文件系統

啟動和停止守護進程

創建用戶目錄

在本地機器上啟動一個資源管理器

在slaves 文件列舉的每臺機器上啟動一個節點管理器

在每臺機器上啟動一個namenode, 這些機器由執行hdfs getconf -namenodes 得到的返回值所缺東

在slaves 文件列舉的每臺機器上啟動一個datanode

在每臺機器上啟動一個輔助namenode,這些機器由執行 hdfs getconf -secondarynamenodes 得到的返回值所確定

start-dfs.sh

start-yarn.sh

此時是給目錄設置空間限制的好時機

最好創建特定的Unix 用戶賬號以區分各Hadoop進程,及區分同一機器上的其他服務

HDFS,MapReduce 和YARN服務通常作為獨立的用戶運行,分別命名為hdfs,mapred 和yarn.他們都屬于同一hadoop組

安裝hadoop

hadoop 分發包 etc/hadoop

HADOOP_CONF_DIR

hadoop-env.sh mapred-env.sh yarn-env.sh core-site.xml hdfs-site.xml mapred-site.xml yarn-site.xml slaves hadoop-metrics2.properties log4j.properties hadoop-policy.xml

配置管理

集群的每個節點都各自保存一系列配置文件,推薦使用控制

環境設置

fs.defaultFS dfs.namenode.name.dir dfs.datanode.data.dir dfs.namenode.checkpoint.dir

守護進程1000MB yarn.nodemanager.resource.memory-mb

每個進程占用一個核

Hadoop守護進程的地址和端口號

yarn 和MapReduce 中的CPU設置

默認情況下,HDFS存儲目錄放在 hadoop.tmp.dir 屬性設置的目錄下(/tmp/hadoop-${user.name}),需要手動更改

yarn 和MapReduce中的內存設置

內存堆大小 默認各個守護進程分配1000MB內存

系統日志文件

SSH設置

hadoop 守護進程的一些關鍵屬性

hadoop其他屬性

緩沖區 大小 4kB

HDFS 塊 128MB

回收站(額,神奇的東東)

kerberos

委托令牌

看完上述內容,你們對Hadoop集群怎么構建有進一步的了解嗎?如果還想了解更多知識或者相關內容,請關注億速云行業資訊頻道,感謝大家的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。