您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要講解了“Tensorflow數據并行多GPU處理方法”,文中的講解內容簡單清晰,易于學習與理解,下面請大家跟著小編的思路慢慢深入,一起來研究和學習“Tensorflow數據并行多GPU處理方法”吧!

如果我們用C++編寫程序只能應用在單個CPU核心上,當需要并行運行在多個GPU上時,我們需要從頭開始重新編寫程序。但是Tensorflow并非如此。因其具有符號性,Tensorflow可以隱藏所有這些復雜性,可輕松地將程序擴展到多個CPU和GPU。

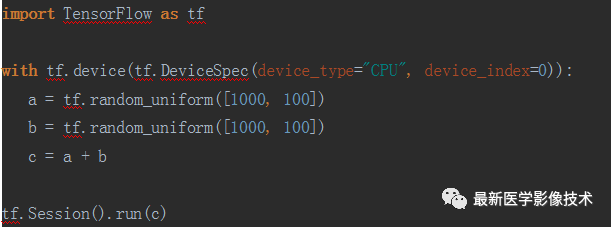

例如在CPU上對兩個向量相加示例。

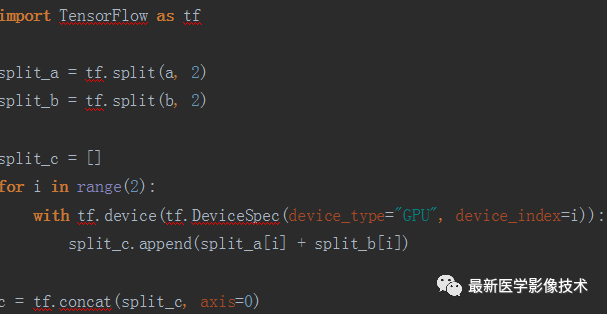

同樣也可以在GPU上完成。

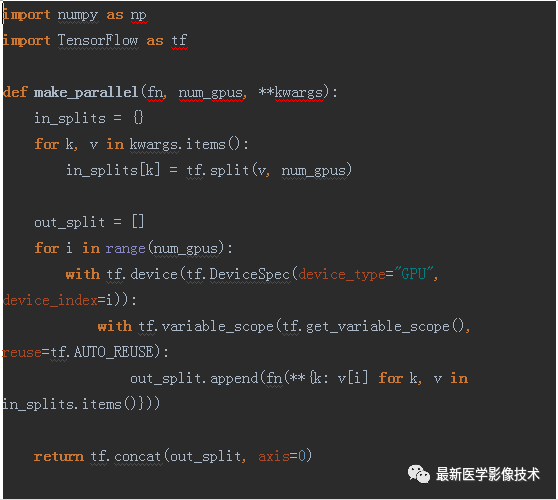

讓我們以更一般的形式重寫它。

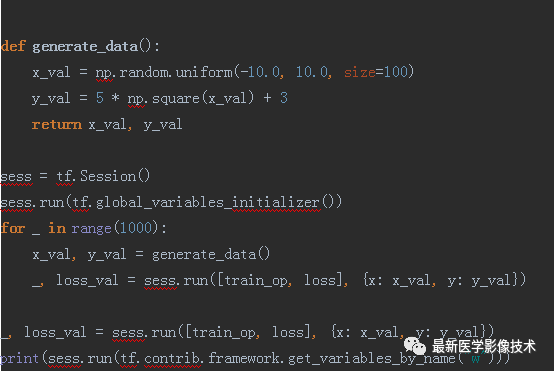

上面就是用2塊GPU并行訓練來擬合一元二次函數。注意:當用多塊GPU時,模型的權重參數是被每個GPU同時共享的,所以在定義的時候我們需要使用tf.get_variable(),它和其他定義方式區別,我在之前文章里有講解過,在這里我就不多說了。大家自己親手試試吧。

感謝各位的閱讀,以上就是“Tensorflow數據并行多GPU處理方法”的內容了,經過本文的學習后,相信大家對Tensorflow數據并行多GPU處理方法這一問題有了更深刻的體會,具體使用情況還需要大家實踐驗證。這里是億速云,小編將為大家推送更多相關知識點的文章,歡迎關注!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。