您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

部署主節點以及安裝服務請看上

https://blog.51cto.com/6989066/2173573

(八)節點的擴展(以HDFS為例)

① 從節點的準備工作

?安裝一臺新的Linux

從節點只需要安裝l Server With GUI

l Development Tools,不需要安裝MariaDB Server

?關閉防火墻

systemctl stop firewalld.service

systemctl disable firewalld.service

?配置主機名:編輯/etc/hosts文件(主節點也需要加入從節點的信息)

?配置免密碼登錄(各個節點之間,都需要配置)

?安裝JDK

?掛載光盤:mount /dev/cdrom /mnt

?刪除原來的所有repo文件

?創建yum的源文件: vi /etc/yum.repos.d/my.repo

[centos-yum]

baseurl=file:///mnt

enabled=1

gpgcheck=0

?開啟NTP服務

所有節點都需要操作

yum install ntp

systemctl is-enabled ntpd

systemctl enable ntpd

systemctl start ntpd

?在新節點上創建目錄:mkdir -p /var/lib/ambari-agent/data

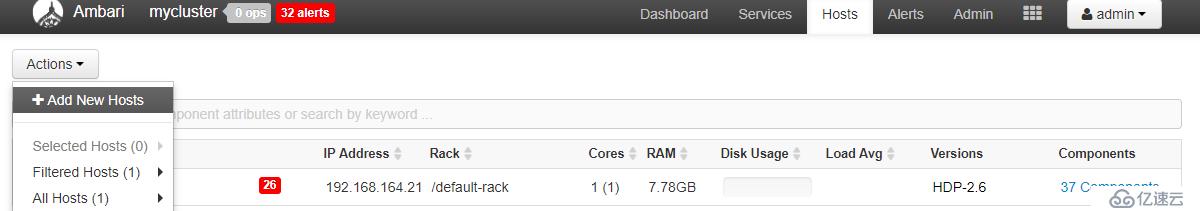

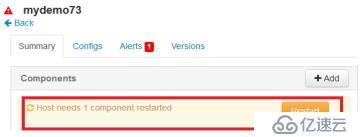

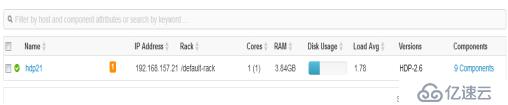

② 添加一個新的節點,如下圖所示:

PS:截圖的時候所有Ambari服務已經停了,所以有很多alerts

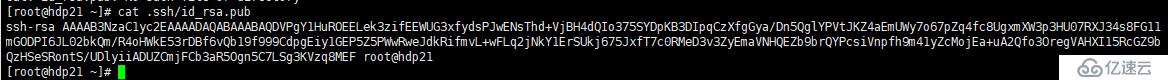

③ 配置新節點的主機信息和私鑰文件

主機名與linux虛擬機host保持一致

私鑰在.ssh/id_rsa目錄,可用cat .ssh/id_rsa.pub查看

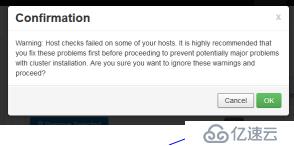

④ 確認主機信息 ![]

![]

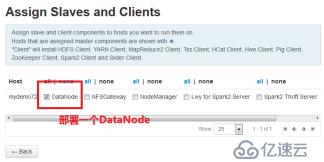

⑤ 部署一個新的DataNode到新的節點

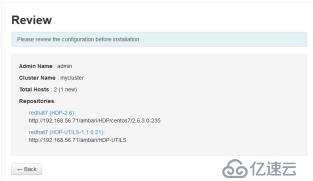

⑥ 確認部署信息,并部署

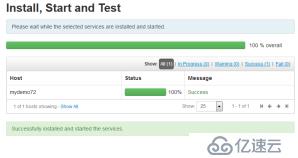

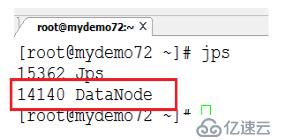

⑦ 部署成功,并在從節點上執行jps命令檢查新的DataNode

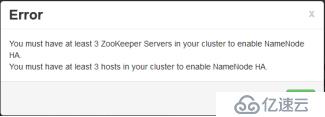

九)啟用HA(以NameNode為例)

① 按照上一節的步驟,在集群中再添加一個新的節點,并部署DataNode。

② 將ZooKeeper服務部署到三個節點上,并啟動。

選擇:“Service Actions” ---> “Add ZooKeeper Server”

③ 重啟所有的ZooKeeper服務

注意:如果遇到有的節點無法啟動,在Console上重啟所有的服務。正常情況下,應該是所有服務都能正常啟動。

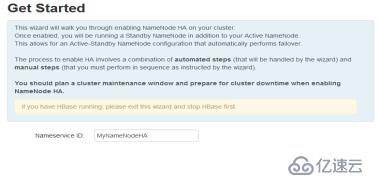

④ 為HDFS NameNode添加HA的服務

⑤ 輸入一個NameService

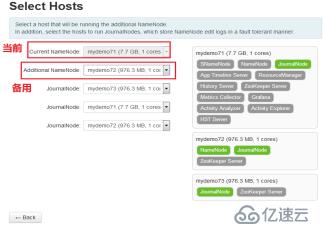

⑥ 配置NameNode HA

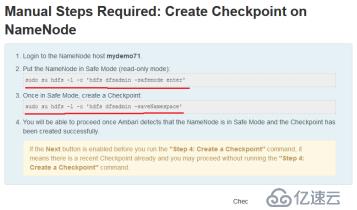

⑦ 檢查配置信息

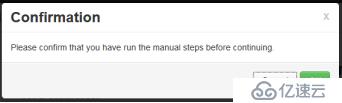

⑧ 需要手動配置的內容,執行下面的命令:

1.Login to the NameNode host mydemo71.

2.Put the NameNode in Safe Mode (read-only mode):

a)sudo su hdfs -l -c 'hdfs dfsadmin -safemode enter'

3.Once in Safe Mode, create a Checkpoint:

a)sudo su hdfs -l -c 'hdfs dfsadmin -saveNamespace'

4.You will be able to proceed once Ambari detects that the NameNode is in Safe Mode and the Checkpoint has been created successfully.

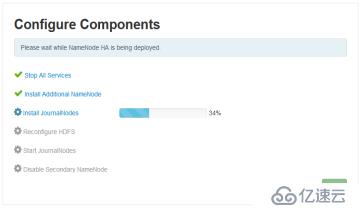

⑨ 開始進行HA的配置:

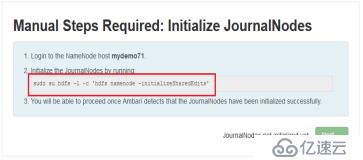

⑩ 需要手動配置的內容,執行下面的命令:

sudo su hdfs -l -c 'hdfs namenode -initializeSharedEdits'

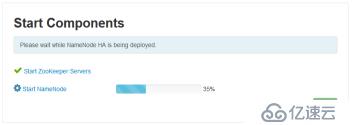

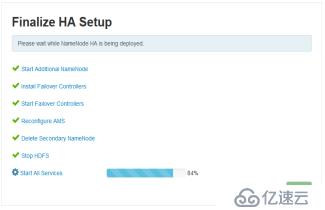

? 啟動HA

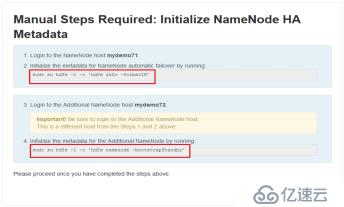

? 需要手動配置的內容,執行下面的命令:

? 進行最后的安裝配置

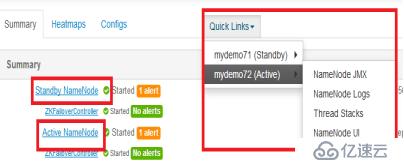

? 驗證HA:(非必需步驟)如果一個NameNode宕機,驗證是否會進行自動的切換。

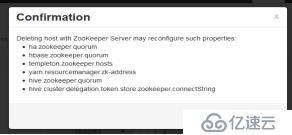

(十)刪除節點和服務(非必要步驟,有實際需求時再刪除)

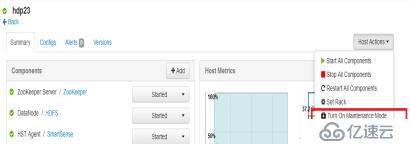

(1)停止要刪除節點(hdp23)上的所有服務

(3)刪除HDFS、Yarn、MapReduce2服務

(4)刪除節點hdp22,只保留hdp21 ![]

![]

(5)停止所有服務,并將hdp21的內存改為8g(可選步驟)

注意:由于需要重啟虛擬機,一定要重新掛載光盤

6)重新部署HDFS、Yarn、MapReduce2服務。注意清空下面的目錄:

namenode /root/training/bigdata/namenode

datanode /root/training/bigdata/datanode

yarn.nodemanager.local-dirs /root/training/bigdata/nodemanager/local

yarn.nodemanager.log-dirs /root/training/bigdata/nodemanager/log

所有密碼 password

十一)安裝部署其他服務(內存8g)

注意:一定保證httpd service和yum的源可用。

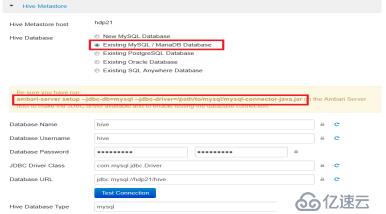

(1)部署Hive和Pig

注意:

?Hive的執行引擎需要選擇:MapReduce,如下圖

(2)部署Flume和Sqoop:很簡單。

(3)部署Spark:很簡單。

(4)部署Kafka:很簡單。

(5)部署Storm:很簡單。

(6)部署Mahout:很簡單。

到這里HDP的部署工作就完成了,如果你有任何意見或者建議,歡迎你在下方留言。

如果這篇博客有幫到你,歡迎你點個贊哦!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。