溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹“怎么用python爬蟲豆瓣電影數據”,在日常操作中,相信很多人在怎么用python爬蟲豆瓣電影數據問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”怎么用python爬蟲豆瓣電影數據”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

import os

import time

import requests

from bs4 import BeautifulSoup

#num獲取num頁 國內高匿ip的網頁中代理數據def

fetch_proxy(num):

#修改當前工作文件夾

os.chdir(r'/Users/apple888/PycharmProjects/proxy IP')

api = 'http://www.xicidaili.com/nn/{}'

header = {'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS

X 10_12_3) AppleWebKit/537.36 (KHTML,

like Gecko) Chrome/56.0.2924.87 Safari/537.36'}

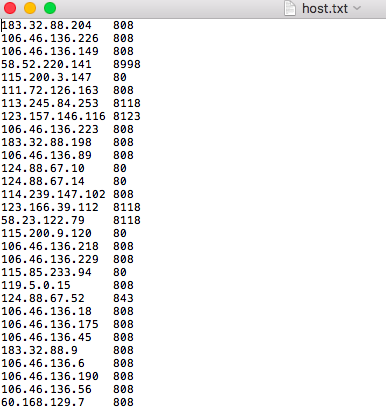

fp = open('host.txt', 'a+', encoding=('utf-8'))

for i in range(num+1):

api = api.format(1)

respones = requests.get(url=api, headers=header)

soup = BeautifulSoup(respones.text, 'lxml')

container = soup.find_all(name='tr',attrs={'class':'odd'})

for tag in container:

try:

con_soup = BeautifulSoup(str(tag),'lxml')

td_list = con_soup.find_all('td')

ip = str(td_list[1])[4:-5]

port = str(td_list[2])[4:-5]

IPport = ip + '\t' + port + '\n'

fp.write(IPport)

except Exception as e:

print('No IP!')

time.sleep(1)

fp.close()我們準備抓 國內高匿代理IP網 的十個頁面的代理

但是有代理IP還不行,因為我們不知道這代理能不能用,是否有效。

import os

import time

import requests

from bs4 import BeautifulSoup

def test_proxy():

N = 1

os.chdir(r'/Users/apple888/PycharmProjects/proxy IP')

url = 'https://www.baidu.com'

fp = open('host.txt', 'r')

ips = fp.readlines()

proxys = list()

for p in ips:

ip = p.strip('\n').split('\t')

proxy = 'http:\\' + ip[0] + ':' + ip[1]

proxies = {'proxy': proxy}

proxys.append(proxies)

for pro in proxys:

try:

s = requests.get(url, proxies=pro)

print('第{}個ip:{} 狀態{}'.format(N,pro,s.status_code)) except Exception as e:

print(e)

N+=1

到此,關于“怎么用python爬蟲豆瓣電影數據”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。