您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下spark運行模式得示例分析,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

運行Spark最簡單的方法是通過Local模式(即偽分布式模式)。

運行命令為:./bin/run-example org.apache.spark.examples.SparkPi local

Standalone模式下,集群啟動時包括Master與Worker,其中Master負責接收客戶端提交的作業,管理Worker。提供了Web展示集群與作業信息。

提交作業有兩種方式,分別是Driver(作業的master,負責作業的解析、生成stage并調度task到,包含DAGScheduler)運行在Worker上,Driver運行在客戶端。接下來分別介紹兩種方式的作業運行原理。

通過org.apache.spark.deploy.Client類執行作業,作業運行命令如下:

./bin/spark-class org.apache.spark.deploy.Client launch spark://host:port file:///jar_url org.apache.spark.examples.SparkPi spark://host:port

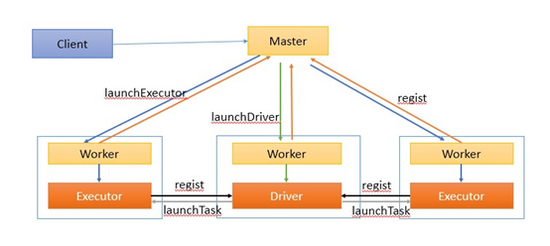

作業執行流如圖1所示。

圖1

作業執行流程描述:

客戶端提交作業給Master

Master讓一個Worker啟動Driver,即SchedulerBackend。Worker創建一個DriverRunner線程,DriverRunner啟動SchedulerBackend進程。

另外Master還會讓其余Worker啟動Exeuctor,即ExecutorBackend。Worker創建一個ExecutorRunner線程,ExecutorRunner會啟動ExecutorBackend進程。

ExecutorBackend啟動后會向Driver的SchedulerBackend注冊。SchedulerBackend進程中包含DAGScheduler,它會根據用戶程序,生成執行計劃,并調度執行。對于每個stage的task,都會被存放到TaskScheduler中,ExecutorBackend向SchedulerBackend匯報的時候把TaskScheduler中的task調度到ExecutorBackend執行。

所有stage都完成后作業結束。

直接執行Spark作業,作業運行命令如下(示例):

./bin/run-example org.apache.spark.examples.SparkPi spark://host:port

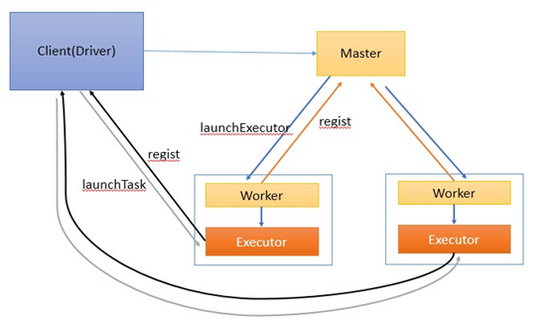

作業執行流如圖2所示。

圖2

作業執行流程描述:

客戶端啟動后直接運行用戶程序,啟動Driver相關的工作:DAGScheduler和BlockManagerMaster等。

客戶端的Driver向Master注冊。

Master還會讓Worker啟動Exeuctor。Worker創建一個ExecutorRunner線程,ExecutorRunner會啟動ExecutorBackend進程。

ExecutorBackend啟動后會向Driver的SchedulerBackend注冊。Driver的DAGScheduler解析作業并生成相應的Stage,每個Stage包含的Task通過TaskScheduler分配給Executor執行。

所有stage都完成后作業結束。

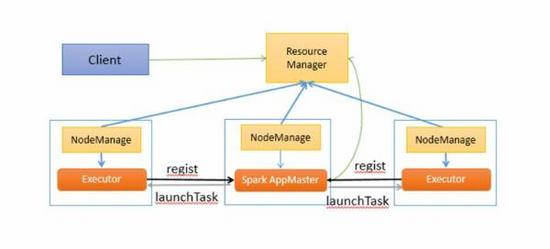

這里Spark AppMaster相當于Standalone模式下的SchedulerBackend,Executor相當于standalone的ExecutorBackend,spark AppMaster中包括DAGScheduler和YarnClusterScheduler。

以上是“spark運行模式得示例分析”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。