您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家分享的是有關windows安裝spark及PyCharm IDEA調試TopN的示例分析的內容。小編覺得挺實用的,因此分享給大家做個參考,一起跟隨小編過來看看吧。

安裝spark第一步就是安裝jdk(無論windows還是linux),spark執行依賴jdk。在oracle官網上下載jdk,這里我選擇的是8u74 windows x64版本,你也可以根據自己的需求下載,jdk的安裝在此不表,無非就是下一步,選安裝路徑什么的。

在Apache Spark?官方網站下載spark,選擇spark-1.6.0-bin-hadoop2.6.tgz。

添加spark環境變量,在PATH后面追加:

%SPARK_HOME%\bin

%SPARK_HOME%\sbin

windows 環境下的spark搭建完畢!!!

注意此處有坑:

Failed to locate the winutils binary in the hadoop binary path java.io.IOException: Could not locate executable null\bin\winutils.exe in the Hadoop binaries.

spark雖然支持standalone模式,并且不依賴hadoop。但是在windows環境下還是需要hadoop的這個winutils.exe。因此需要下載2.6版本匹配的winutils.exe. 可以google "hadoop.dll 2.6" 或在此下載(hadoop dll winutils.exe,GitHub各種版本都有), 將下載后的文件覆蓋至hadoop的bin目錄(沒有的話需要建個目錄,并設置相應hadoop環境HADOOP_HOME及PATH環境變量)。

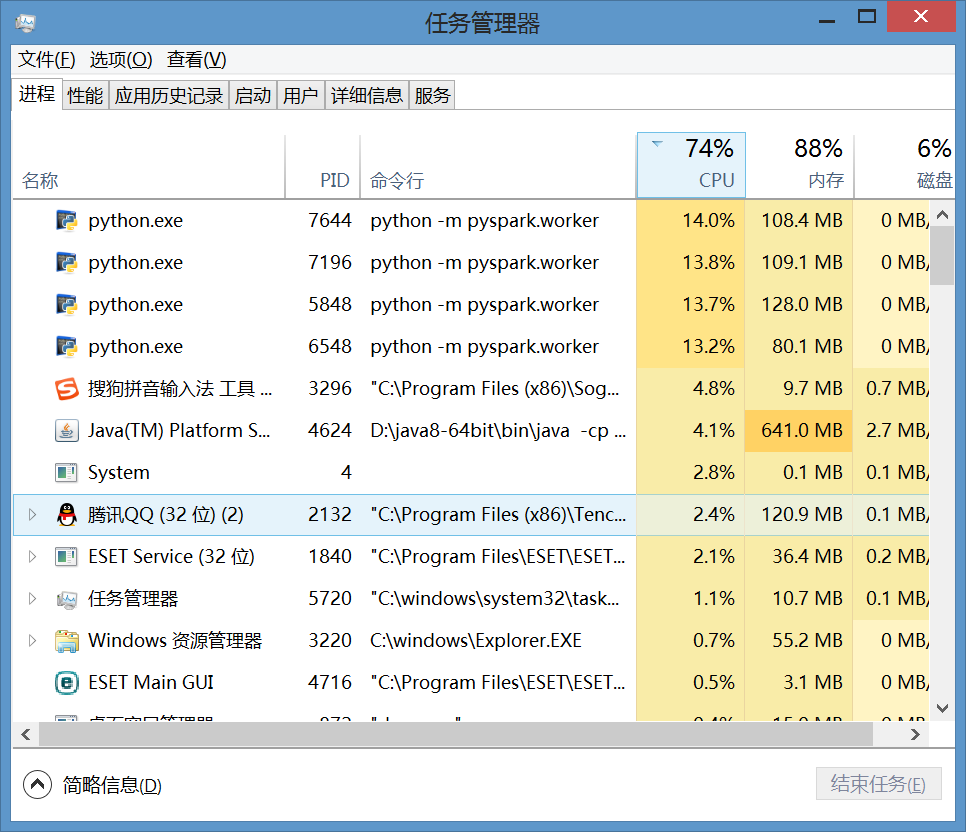

spark支持scala、python和java,由于對python的好感多于scala,因此開發環境是Python。

下面開始搭建python環境:

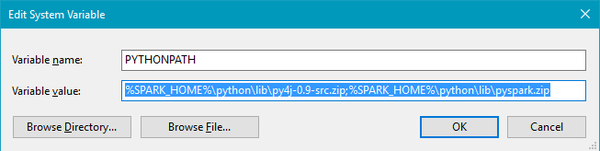

2.7或3.5均可,安裝過程在此不表,安裝完成后在環境變量里添加PYTHONPATH,這一步很重要:

如果配置正確,打開python自帶的IDE,輸入以下代碼,然后等待連接成功的消息即可:

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local").setAppName("MY First App")

sc = SparkContext(conf = conf)也可以手動啟動測試下:

spark-class.cmd org.apache.spark.deploy.master.Master spark-class.cmd org.apache.spark.deploy.worker.Worker spark://localhost:7077

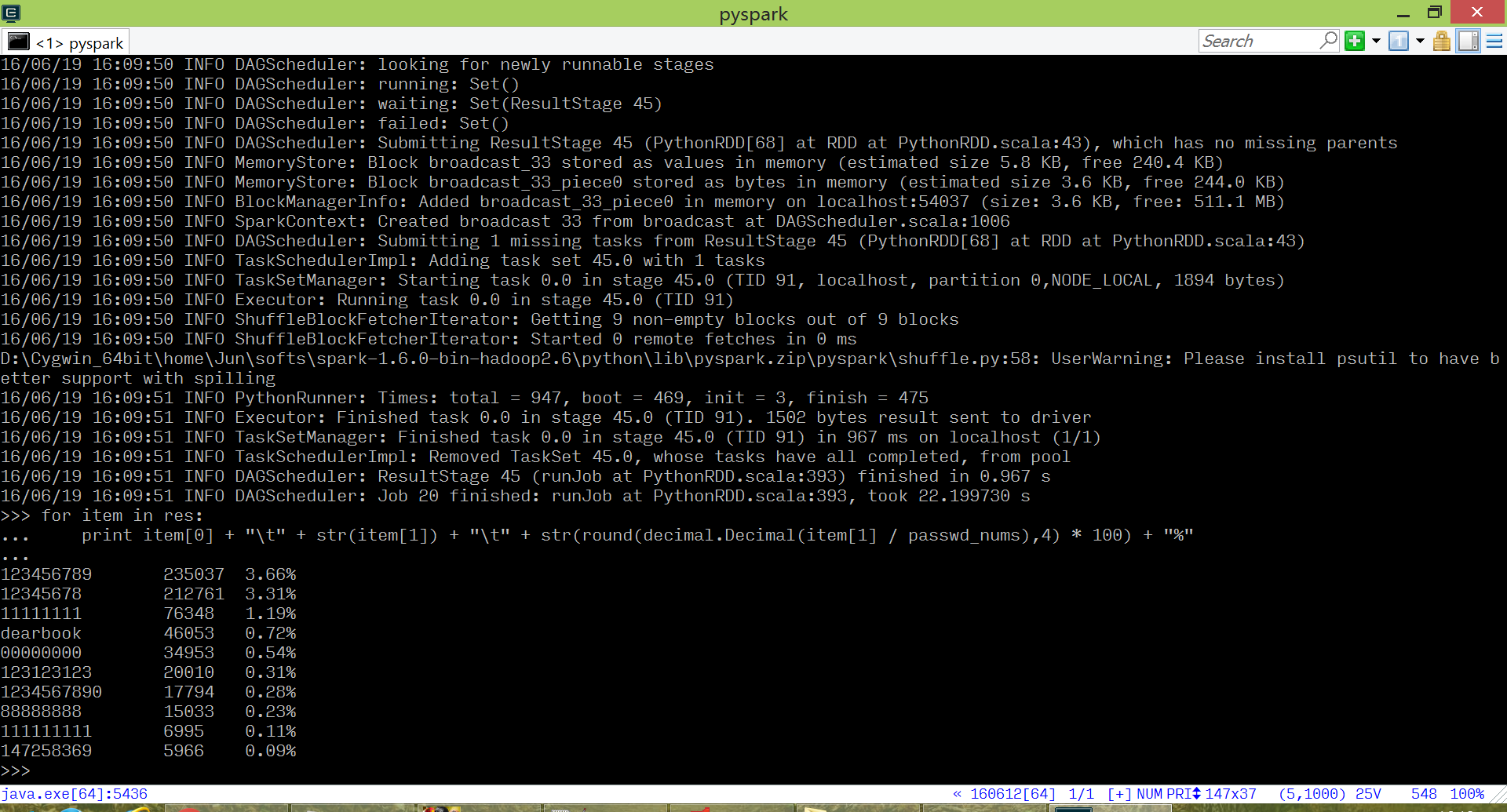

# coding=utf-8

# 測試utf-8編碼

from __future__ import division

import decimal

from pyspark import SparkConf, SparkContext, StorageLevel

import sys

reload(sys)

sys.setdefaultencoding('utf-8')

conf = SparkConf().setMaster("local").setAppName("CSDN_PASSWD_Top10")

sc = SparkContext(conf=conf)

file_rdd = sc.textFile("H:\mysql\csdn_database\www.csdn.net.sql")

passwds = file_rdd.map(lambda line: line.split("#")[1].strip()).map(lambda passwd: (passwd, 1)).persist(

storageLevel=StorageLevel.MEMORY_AND_DISK_SER)

passwd_nums = passwds.count()

top10_passwd = passwds.reduceByKey(lambda a, b: a + b).sortBy(lambda item: item[1], ascending=False).take(10)

for item in top10_passwd:

print item[0] + "\t">

代碼如下:

C:\Users\username>spark-shell

scala> val textFile = spark.read.textFile("C:\\Users\\username\\Desktop\\parse_slow_log.py")

textFile: org.apache.spark.sql.Dataset[String] = [value: string]

scala> textFile.count()

res0: Long = 156

scala> textFile.first()

res1: String = # encoding: utf-8

scala> val linesWithSpark = textFile.filter(line => line.contains("Spark"))

linesWithSpark: org.apache.spark.sql.Dataset[String] = [value: string]

scala> textFile.filter(line => line.contains("Spark")).count()

res2: Long = 0

scala> textFile.map(line => line.split(" ").size).reduce((a, b) => if (a > b) a else b)

res3: Int = 27

scala> val wordCounts = textFile.flatMap(line => line.split(" ")).groupByKey(identity).count()

wordCounts: org.apache.spark.sql.Dataset[(String, Long)] = [value: string, count(1): bigint]

scala> wordCounts.collect()

res4: Array[(String, Long)] = Array((self.slowlog,1), (import,3), (False,,1), (file_name,,1), (flag_word,3), (MySQL,1), (else,1), (*,2), (slowlog,1), (default=script_path),1), (0,4), ("",2), (-d,1), (__auther,1), (for,5...

scala感謝各位的閱讀!關于“windows安裝spark及PyCharm IDEA調試TopN的示例分析”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,讓大家可以學到更多知識,如果覺得文章不錯,可以把它分享出去讓更多的人看到吧!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。