您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

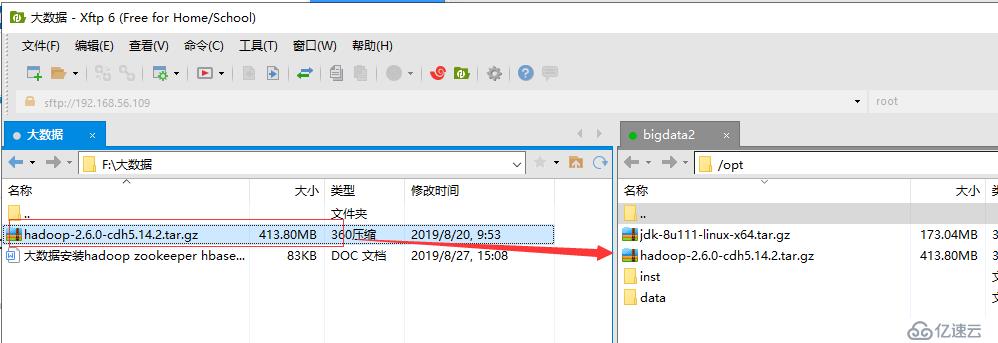

2.通過Xftp工具將壓縮包拉到虛擬機/opt目錄下(目錄個人隨意)

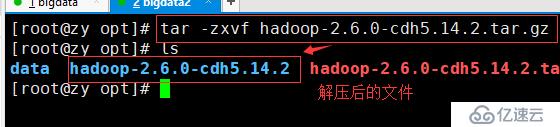

3.解壓hadoop壓縮包(命令:tar -zxvf hadoop-2.6.0-cdh6.14.2.tar.gz)

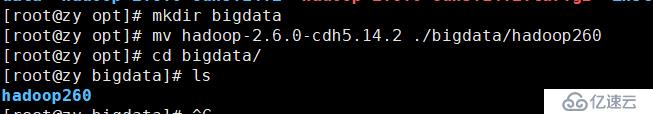

4.這里為了清晰,新建一個文件夾bigdata單獨存放解壓后的文件,并重命名

新建:mkdir bigdata

移動: mv hadoop-2.6.0-cdh6.14.2 ./bigdata/hadoop260

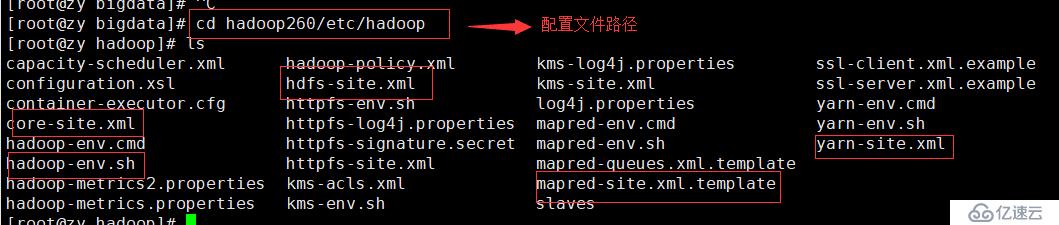

5.重頭:修改配置文件,移動至/etc/hadoop目錄下,ls命令,下圖中圈選的文件是本次我們需要進行配置的

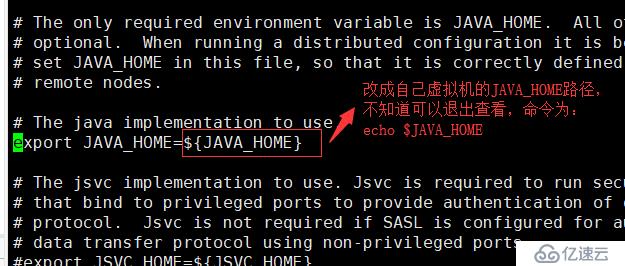

6.配置1:vi hadoop-env.sh修改如下位置,修改成自己JAVA_HOME的路徑,可以echo $JAVA_HOME查看,修改完保存退出

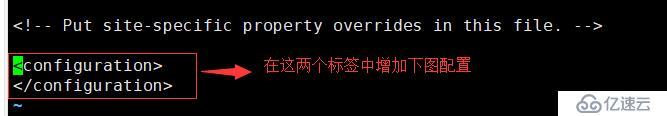

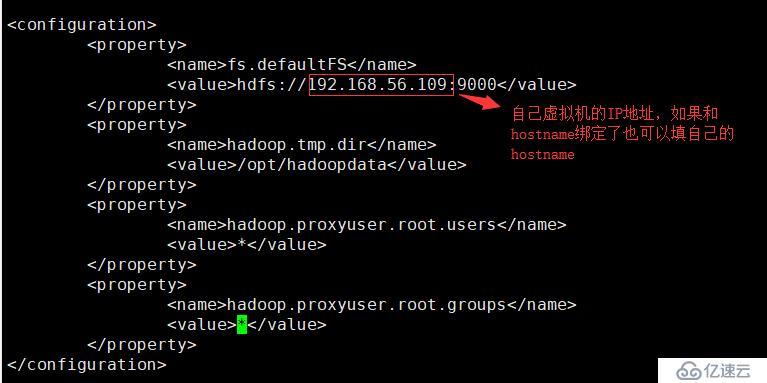

7.配置2:vi core-site.xml修改如下位置

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.56.109:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoopdata</value>

</property>

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>8.配置3:vi hdfs-site.xml,和上一步一樣的標簽中加入如下代碼

<property>

<name>dfs.replication</name>

<value>1</value>

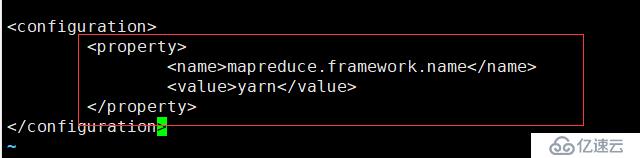

</property>9.配置4,這個文件需要自己copy,和上一步一樣的標簽中加入如下代碼

命令:cp mapred-site.xml.template mapred-site.xml

配置:vi mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

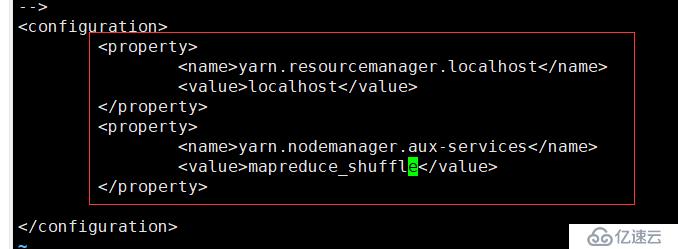

</property>10.配置5:vi yarn-site.xml,中間有行注釋可以刪掉直接

<property>

<name>yarn.resourcemanager.localhost</name>

<value>localhost</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

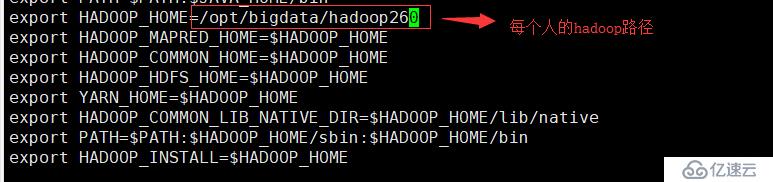

11.配置六:vi /etc/profile,移動至最后,加入以下代碼

export HADOOP_HOME=/opt/bigdata/hadoop260

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

export HADOOP_INSTALL=$HADOOP_HOME12.激活配置文件:source /etc/profile

13.格式化namenode:hdfs namenode -format

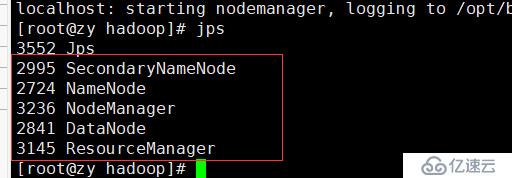

14.運行:start-all.sh,然后每一步都輸入yes

15.查看運行情況:jps,如果能查看到如下5個進程,則代表配置運行成功,如果少哪一個,就去檢查對應的配置文件

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。