您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“Apache四個大型開源數據和數據湖系統是什么”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

管理大數據所需的許多功能是其中一些是事務,數據突變,數據校正,流媒體支持,架構演進,因為酸性事務能力Apache提供了四種,用于滿足和管理大數據。

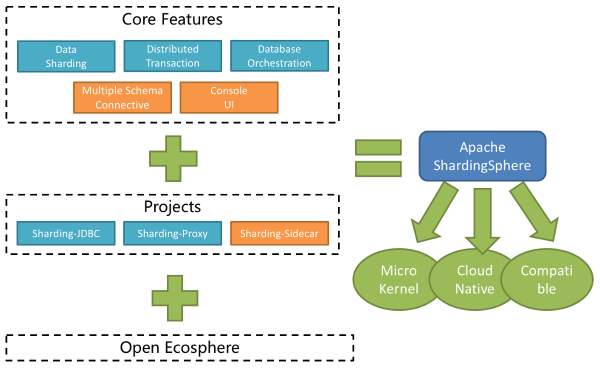

Apache Sharding Sphere

它是一個眾所周知的數據庫中間件系統。它包含三個獨立的模塊,JDBC,Proxy和Sidecar(計劃),但在部署時它們都混合在一起。Apache Shardingsphere提供標準化的數據分片,分布式事務和數據庫治理功能,可以針對各種多樣化應用方案,例如Java同義,異構語言和云本機。

今天的電子商務主要依賴于關系數據庫和分布式環境,高效查詢的激增和數據快速轉移成為公司關系數據庫的主要目標Apache Shardingsphere是偉大的關系數據庫中間件生態系統,它為其開發人員提供了合理的計算和存儲功能關系數據庫。

Apache Iceberg

Apache Iceberg 最初由Netflix設計和開發。關鍵的想法是組織目錄樹中的所有文件,如果您需要在2018年5月創建的文件在Apache iceBerg中,您只需找出該文件并只讀該文件,也沒有必要閱讀您可以閱讀的其他文件忽略您對當前情況不太重要的其他數據。核心思想是跟蹤時間表上表中的所有更改。

它是一種用于跟蹤非常大的表的數據湖解決方案,它是一個輕量級數據湖解決方案,旨在解決列出大量分區和耗時和不一致的元數據和HDFS數據的問題。它包含三種類型的表格格式木質,Avro和Orc.in Apache iceberg表格格式與文件集合和文件格式的集合執行相同的東西,允許您在單個文件中跳過數據

它是一種用于在非常大型和比例表上跟蹤和控制的新技術格式。它專為對象存儲而設計(例如S3)。Iceberg 中更重要的概念是一個快照。快照表示一組完整的表數據文件。為每個更新操作生成新快照。

Apache Iceberg 有以下特征:

ACID 事務能力,可以在不影響當前運行數據處理任務的情況下進行上游數據寫入,這大大簡化了ETL; Iceberg 提供更好的合并能力,可以大大減少數據存儲延遲;

支持更多的分析引擎優異的內核抽象使其不綁定到特定的計算引擎。目前,冰山支持的計算發動機是Spark,Flink,Presto和Hive。

Apache Iceberg為文件存儲,組織,基于流的增量計算模型和基于批處理的全尺度計算模型提供統一和靈活的數據。批處理和流式傳輸任務可以使用類似的存儲模型,并且不再隔離數據。iceberg支持隱藏的分區和分區演進,這促進了業務更新數據分區策略。支持三個存儲格式木質,Avro和Orc。

增量讀取處理能力iceBerg支持以流式方式讀取增量數據,支持流和傳輸表源。

Apache Hudi

Apache Hudi是一個大數據增量處理框架,它試圖解決攝取管道的效率問題和在大數據中需要插入,更新和增量消耗基元的ETL管道。它是針對分析和掃描優化的數據存儲抽象,其可以在幾分鐘內將更改應用于HDF中的數據集,并支持多個增量處理系統來處理數據。通過自定義InputFormat與當前Hadoop生態系統(包括Apache Hive,Apache Parquet,Presto和Apache Spark)的集成使框架無縫為最終用戶。

Hudi的設計目標是快速且逐步更新HDFS上的數據集。有兩種更新數據的方法:讀寫編寫并合并讀取。寫入模式上的副本是當我們更新數據時,我們需要通過索引獲取更新數據中涉及的文件,然后讀取數據并合并更新的數據。這種模式更易于更新數據,但是當涉及的數據更新時更新時,效率非常低;并合并讀取是要將更新寫入單獨的新文件,然后我們可以選擇與原始數據同步或異步地將更新的數據與原始數據合并(可以調用組合),因為更新的僅編寫新文件,所以此模式將更新更快。

在Hudi系統的幫助下,很容易在MySQL,HBase和Cassandra中收集增量數據,并將其保存到Hudi。然后,presto,spark和hive可以快速閱讀這些遞增更新的數據。

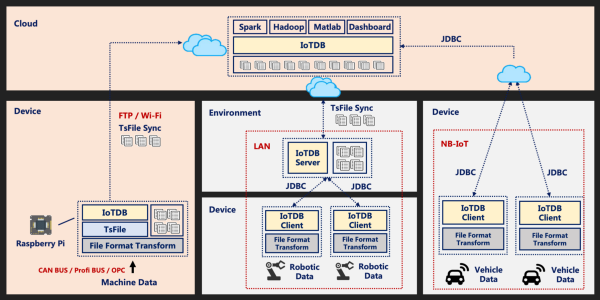

Apache Iotdb

它是一種物聯網時間序列工業數據庫,Apache IOTDB是一款集成,存儲,管理和Anallyze Thge IoT時間序列數據的軟件系統。Apache IOTDB采用具有高性能和豐富功能的輕量級架構,并與Apache Hadoop,Spark和Flink等進行深度集成,可以滿足工業中大規模數據存儲,高速數據讀數和復雜數據分析的需求事物互聯網領域。

Apache IOTDB套件由多個組件組成,它們一起形成一系列功能,例如“數據收集 - 數據寫入數據存儲 - 數據查詢 - 數據可視化數據分析”。其結構如下:

用戶可以導入從設備上的傳感器收集的時間序列數據,服務器負載和CPU內存等消息隊列中的時間序列數據,時間序列數據,應用程序的時間序列數據或從其他數據庫到本地或遠程IOTDB的時間序列數據JDBC。在。用戶還可以直接將上述數據寫入本地(或在HDFS上)TSFile文件。TSFile文件可以寫入HDF,以實現數據處理平臺的數據處理平臺等異常檢測和機器學習等數據處理任務。對于寫入HDFS或本地的TSFile文件,您可以使用TSFile-Hadoop或TSFile-Spark連接器來允許Hadoop或Spark處理數據。分析結果可以寫回TSFile文件。IOTDB和TSFile還提供相應的客戶端工具,以滿足用戶在SQL,腳本和圖形格式中查看數據的需求。

“Apache四個大型開源數據和數據湖系統是什么”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。