您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

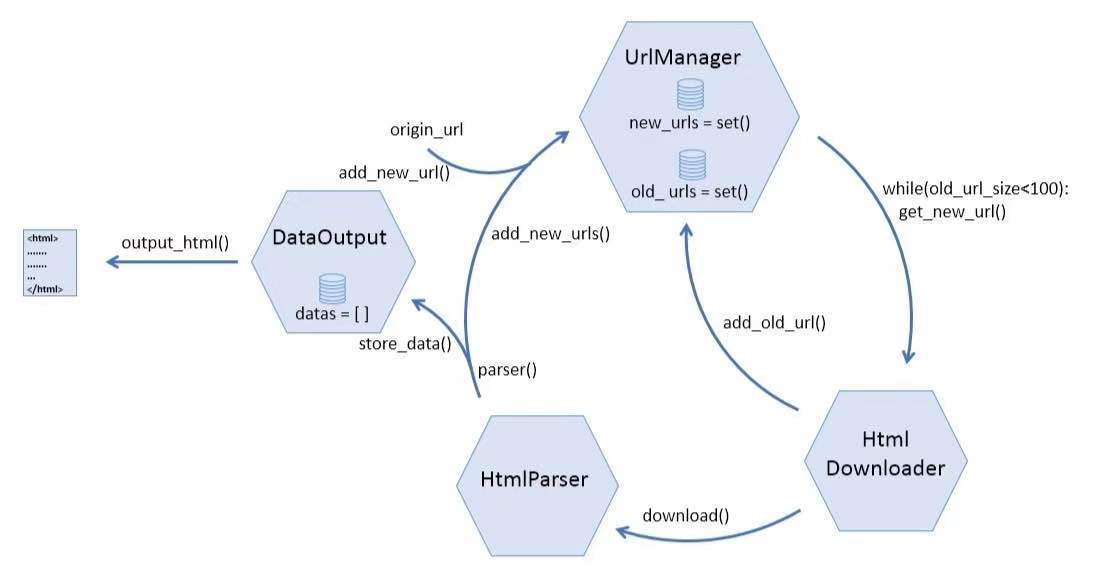

這篇文章將為大家詳細講解有關怎么在python爬蟲中利用url管理器實現一個去重功能,文章內容質量較高,因此小編分享給大家做個參考,希望大家閱讀完這篇文章后對相關知識有一定的了解。

URL管理器到底應該具有哪些功能?

URL下載器應該包含兩個倉庫,分別存放沒有爬取過的鏈接和已經爬取過的鏈接。

應該有一些函數負責往上述兩個倉庫里添加鏈接

應該有一個函數負責從新url倉庫中隨機取出一條鏈接以便下載器爬取

URL下載器應該能識別重復的鏈接,已經爬取過的鏈接就不需要放進倉庫了

如果一個URL管理器能夠具有以上4點功能,也算是“麻雀雖小,五臟俱全”了。然而,鏈接去重這個功能,應該怎么實現?

鏈接去重是關系爬蟲效率的一個比較關鍵的點,尤其是爬取的數據量極大的時候。在這個簡單的例子里,由于數據量較少,我們不需要太過復雜的算法,直接借助于python的set()函數即可,該函數可以生成一個集合對象,其元素不可重復。

根據以上分析,URL管理器的w代碼如下:

''' UrlManager class UrlManager(object): def __init__(self): #初始化的時候就生成兩個url倉庫 self.new_urls = set() self.old_urls = set() #判斷新url倉庫中是否還有沒有爬取的url def has_new_url(self): return len(self.new_urls) #從new_url倉庫獲取一個新的url def get_new_url(self): return self.new_urls.pop() def add_new_url(self, url): #這個函數后來用不到了…… ''' 將一條url添加到new_urls倉庫中 parm url: str return: if url is None: return #只需要判斷old_urls中沒有該鏈接即可,new_urls在添加的時候會自動去重 if url not in self.old_urls: self.new_urls.add(url) def add_new_urls(self, urls): 將多條url添加到new_urls倉庫中 parm url: 可迭代對象 print "start add_new_urls" if urls is None or len(urls) == 0: for url in urls: self.add_new_url(url) def add_old_url(self, url): self.old_urls.add(url) print "add old url succefully" #獲取已經爬取過的url的數目 def old_url_size(self): return len(self.old_urls)

關于怎么在python爬蟲中利用url管理器實現一個去重功能就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。