您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

前言

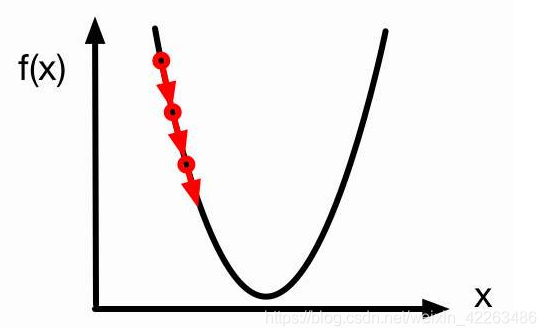

由于機器學習的基本思想就是找到一個函數去擬合樣本數據分布,因此就涉及到了梯度去求最小值,在超平面我們又很難直接得到全局最優值,更沒有通用性,因此我們就想辦法讓梯度沿著負方向下降,那么我們就能得到一個局部或全局的最優值了,因此導數就在機器學習中顯得非常重要了

基本使用

tensor.backward()可以及自動將梯度累加積到tensor.grad上

x = torch.ones(3,3) print(x.requires_grad) x.requires_grad_(True) print(x.requires_grad) y = x**2/(x-2) out = y.mean() print(x.grad) out.backward() print(x.grad)

False

True

None

tensor([[-0.3333, -0.3333, -0.3333],

[-0.3333, -0.3333, -0.3333],

[-0.3333, -0.3333, -0.3333]])

requires_grad 可以獲取到tensor是否可導

requires_grad_() 可以設置tensor是否可導

grad 查看當前tensor導數

上面的公式很簡單,程序含義

1/4 * (x**2) / (x-2)

求x的導數,基本公式在下方

注意點

我們使用.mean后得到的是標量,如果不是標量會報錯

x = torch.ones(3, requires_grad=True) y = x * 2 y = y * 2 print(y)

tensor([4., 4., 4.], grad_fn=<MulBackward0>)

y.backward() print(x.grad)

報錯

RuntimeError: grad can be implicitly created only for scalar outputs

v = torch.tensor([0.1, 1.0, 0.0001], dtype=torch.float) y.backward() print(x.grad)

tensor([4.0000e-01, 4.0000e+00, 4.0000e-04])

no_grad()作用域

如果想要某部分程序不可導那么我們可以使用這個

x = torch.ones(3, requires_grad=True) y = x * 2 print(y.requires_grad) with torch.no_grad(): y = y * 2 print(y.requires_grad)

True

False

總結

這一章我們使用pytorch里面的backward,自動實現了函數的求導,幫助我們在后面面對很多超大參數量的函數的時候,求導就變得游刃有余

上節

PyTorch使用教程-安裝與基本使用

到此這篇關于PyTorch 導數應用的使用教程的文章就介紹到這了,更多相關PyTorch 導數應用內容請搜索億速云以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持億速云!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。