您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹“spark集群如何使用hanlp進行分布式分詞”,在日常操作中,相信很多人在spark集群如何使用hanlp進行分布式分詞問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”spark集群如何使用hanlp進行分布式分詞”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

分兩步:

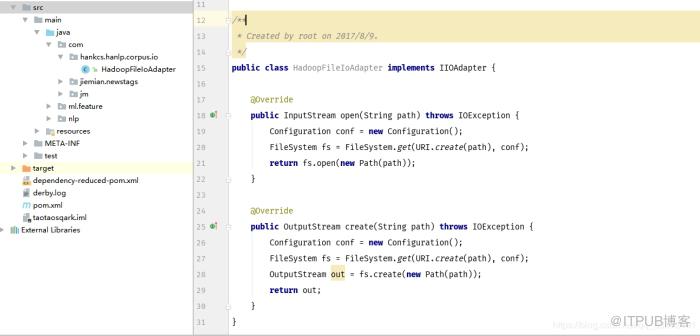

第一步:實現hankcs.hanlp/corpus.io.IIOAdapter

1. public class HadoopFileIoAdapter implements IIOAdapter {

2.

3. @Override

4. public InputStream open(String path) throws IOException {

5. Configuration conf = new Configuration();

6. FileSystem fs = FileSystem.get(URI.create(path), conf);

7. return fs.open(new Path(path));

8. }

9.

10. @Override

11. public OutputStream create(String path) throws IOException {

12. Configuration conf = new Configuration();

13. FileSystem fs = FileSystem.get(URI.create(path), conf);

14. OutputStream out = fs.create(new Path(path));

15. return out;

16. }

17. }

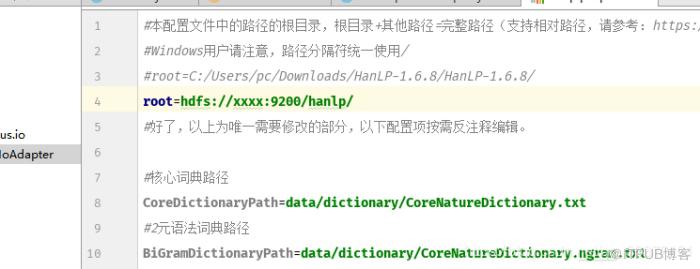

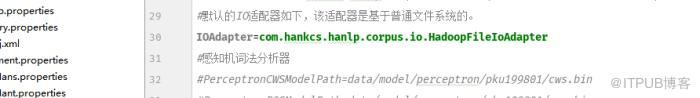

第二步:修改配置文件。root為hdfs上的數據包,把IOAdapter改為咱們上面實現的類

ok,這樣你就能在分布式集群上使用hanlp進行分詞了。

到此,關于“spark集群如何使用hanlp進行分布式分詞”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。