您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下pandas數據分析常用函數有哪些,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

1. 導入模塊

import pandas as pd # 這里用到的是pandas和numpy兩個模塊

import numpy as np2. 創建數據集并讀取

2.1 創建數據集

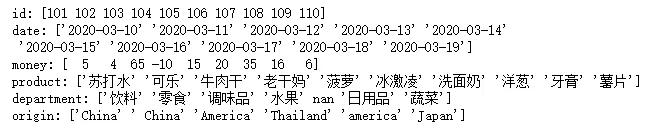

我構造了一個超市購物的數據集,該數據集屬性包括:訂單ID號(id)、訂單日期(date)、消費金額(money)、訂單商品(product)、商品類別(department)、商品產地(origin)。

# 列表和字典均可傳入DataFrame,我這里用的是字典傳入:

data=pd.DataFrame({

"id":np.arange(101,111), # np.arange會自動輸出范圍內的數據,這里會輸出101~110的id號。

"date":pd.date_range(start="20200310",periods=10), # 輸出日期數據,設置周期為10,注意這里的周期數應該與數據條數相等。

"money":[5,4,65,-10,15,20,35,16,6,20], # 設置一個-10的坑,下面會填(好慘,自己給自己挖坑,幸虧不準備跳~)

"product":['蘇打水','可樂','牛肉干','老干媽','菠蘿','冰激凌','洗面奶','洋蔥','牙膏','薯片'],

"department":['飲料','飲料','零食','調味品','水果',np.nan,'日用品','蔬菜','日用品','零食'], # 再設置一個空值的坑

"origin":['China',' China','America','China','Thailand','China','america','China','China','Japan'] # 再再設置一個america的坑

})

data # 輸出查看數據集輸出結果:

2.2 數據寫入和讀取

data.to_csv("shopping.csv",index=False) # index=False表示不加索引,否則會多一行索引data=pd.read_csv("shopping.csv")3. 數據查看

3.1 數據集基礎信息查詢

data.shape # 行數列數

data.dtypes # 所有列的數據類型

data['id'].dtype # 某一列的數據類型

data.ndim # 數據維度

data.index # 行索引

data.columns # 列索引

data.values # 對象值3.2 數據集整體情況查詢

data.head() # 顯示頭部幾行(默認5行)

data.tail() # 顯示末尾幾行(默認5行)

data.info() # 數據集相關信息概覽:索引情況、列數據類型、非空值、內存使用情況

data.describe() # 快速綜合統計結果4. 數據清洗

4.1 查看異常值

當然,現在這個數據集很小,可以直觀地發現異常值,但是在數據集很大的時候,我用下面這種方式查看數據集中是否存在異常值,如果有其他更好的方法,歡迎傳授給我。

for i in data:

print(i+": "+str(data[i].unique())) # 查看某一列的唯一值輸出結果:我們發現,該數據集中money存在一個負值,department存在一個空值以及origin存在大小寫問題。

4.2 空值處理

4.2.1 空值檢測

data.isnull()# 查看整個數據集的空值data['department'].isnull()# 查看某一列的空值

data.isnull() # 查看整個數據集的空值

data['department'].isnull() # 查看某一列的空值輸出結果:

將空值判斷進行匯總,更加直觀,ascending默認為True,升序。

data.isnull().sum().sort_values(ascending=False)

輸出結果:

4.2.2 空值處理

pandas.DataFrame.fillna(value = None,method = None,inplace = False)

value:用于填充的值,可以是具體值、字典和數組,不能是列表;

method:填充方法,有 ffill 和 bfill 等;

inplace默認無False,如果為True,則將修改此對象上的所有其他視圖。

data['department'].fillna(method="ffill") # 填充上一個值,即填充“水果”

輸出結果:

data['department'].fillna(method="bfill") # 填充下一個值,即填充“日用品”

data['department'].fillna(value="冷凍食品",inplace=True) # 替換為具體值,并且在原對象值上進行修改

輸出結果:

4.3 空格處理

只針對object類型數據

for i in data: # 遍歷數據集中的每一列

if pd.api.types.is_object_dtype(data[i]): # 如果是object類型的數據,則執行下方代碼

data[i]=data[i].str.strip() # 去除空格

data['origin'].unique() # 驗證一下輸出結果:array([‘China’, ‘America’, ‘Thailand’, ‘america’, ‘Japan’], dtype=object)

4.4 大小寫轉換

data['origin'].str.title() # 將首字母大寫

data['origin'].str.capitalize() # 將首字母大寫

data['origin'].str.upper() # 全部大寫

data['origin'].str.lower() # 全部小寫4.5 數據替換

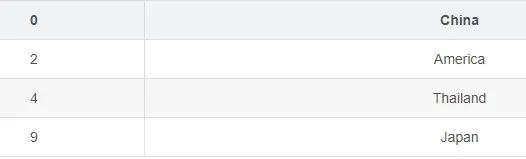

data['origin'].replace("america","America",inplace=True) # 將第一個值替換為第二個值,inplace默認為False

data['origin']輸出結果:

data['money'].replace(-10,np.nan,inplace=True) # 將負值替換為空值

data['money'].replace(np.nan,data['money'].mean(),inplace=True) # 將空值替換為均值

data['money']輸出結果:

4.6 數據刪除

方法一

data1 = data[data.origin != 'American'] #去掉origin為American的行

data1

data2=data[(data != 'Japan').all(1)] #去掉所有包含Japan的行 不等于Japan的行為真,則返回

data2方法二

data['origin'].drop_duplicates() # 默認刪除后面出現的重復值,即保留第一次出現的重復值

輸出結果:

data['origin'].drop_duplicates(keep='last') # 刪除前面出現的重復值,即保留最后一次出現的重復值

輸出結果:

更多關于pandas.DataFrame.drop_duplicates的用法,戳下面官方鏈接:https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.drop_duplicates.html#pandas.DataFrame.drop_duplicates

4.7 數據格式轉換

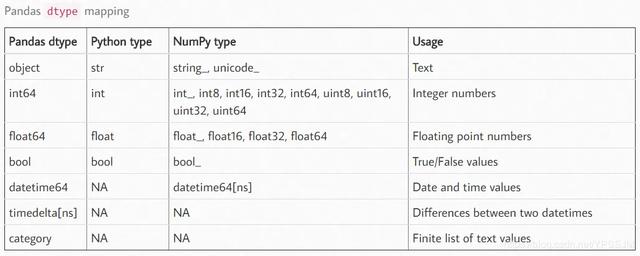

data['id'].astype('str') # 將id列的類型轉換為字符串類型。常見的數據類型對照

4.8 更改列名稱

data.rename(columns={'id':'ID', 'origin':'產地'}) # 將id列改為ID,將origin改為產地。輸出結果:

以上是“pandas數據分析常用函數有哪些”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。