您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹Python爬蟲中爬取貼吧內容的方法,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

爬取貼吧內容

先了解貼吧url組成:

每個貼吧url都是以'https://tieba.baidu.com/f?'開頭,然后是關鍵字 kw=‘’貼吧名字‘’,再后面是 &pn=頁數 (pn=0第一頁,pn=50第二頁,依次類推)

更多關于Python爬蟲的相關知識,可以關注億速云的Python爬蟲欄目。

1.先寫一個main,提示用戶輸入要爬取的貼吧名,并用urllib.urlencode()進行轉碼,然后組合url

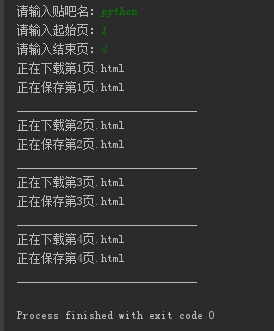

2.接下來,寫一個百度貼吧爬蟲接口tiebaSpider(),需要傳遞3個參數給這個接口, 一個是main里組合的url地址,以及起始頁碼和終止頁碼,表示要爬取頁碼的范圍。

3.前面寫出一個爬取一個網頁的代碼。然后,將它封裝成一個小函數loadPage(),供我們使用。

4.將爬取到的每頁的信息存儲在本地磁盤上,我們可以簡單寫一個存儲文件的接口writePage()

# _*_ coding:utf-8 _*_ import urllib,urllib2 def loadPage(url,filename): #根據url發送請求,獲取服務器響應文件 print '正在下載' + filename headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.101 Safari/537.36'} request = urllib2.Request(url,headers = headers) content = urllib2.urlopen(request).read() return content def writePage(html,filename): #將html內容寫入到本地 print '正在保存' + filename with open(unicode(filename,'utf-8'),'w') as f: f.write(html) print '_' * 30 def tiebaSpider(url,beginPage,endPage): #貼吧爬蟲調度器,負責組合處理每個頁面的url for page in range(beginPage,endPage + 1): pn = (page - 1) * 50 filename = '第' + str(page) + '頁.html' fullurl = url + '&pn=' + str(pn) # print fullurl html = loadPage(fullurl,filename) writePage(html,filename) if __name__ == '__main__': kw = raw_input('請輸入貼吧名:') beginPage = int(raw_input('請輸入起始頁:')) endPage = int(raw_input('請輸入結束頁:')) url = 'https://tieba.baidu.com/f?' key = urllib.urlencode({'kw':kw}) fullurl = url + key tiebaSpider(fullurl,beginPage,endPage)

通過輸入想要搜索的貼吧名字,爬取內容并保存到本地

以上是Python爬蟲中爬取貼吧內容的方法的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。