您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章運用簡單易懂的例子給大家介紹Python的字符編碼匯總,內容非常詳細,感興趣的小伙伴們可以參考借鑒,希望對大家能有所幫助。

一、常見編碼

ASCII:ASCII碼即美國標準信息交換碼(American Standard Code for Information Interchange)。由于計算機內部所有信息最終都是一個二進制值,而每一個二進制位(bit)有0和1兩種狀態,因此八個二進制位就可以組合出256種狀態,這被稱為一個字節(byte)。標準ASCII 碼一共規定了128個字符的編碼,這是因為只使用了后面七位,最前面的一位統一規定為0。之后IBM制定了128個擴充字符,這些字符并非標準的ASCII碼,而是用來表示框線、音標和其它歐洲非英語系的字母。

英語用128個符號編碼就夠了,但是用來表示其他語言,128個符號是不夠的,而且不同的國家使用不同的字母,有的國家使用的字符也遠遠超過256個,顯然ASCII已經無法解決問題了。那么有沒有一種統一且唯一的編碼方式呢?答案就是Unicode。

Unicode:Unicode是計算機科學領域里的一項業界標準,Unicode 是為了解決傳統的字符編碼方案的局限而產生的,它為每種語言中的每個字符設定了統一并且唯一的二進制編碼,以滿足跨語言、跨平臺進行文本轉換、處理的要求。

但是Unicode也是有問題的,比如“中”字的Unicode編碼是十六進制的4E2D,即二進制的100111000101101占15位,也就是說表示這個符號至少需要兩個字節,那么怎么知道這兩個字節是表示一個字符而不是分別表示兩個字符呢?也就是如何區分Unicode和ASCII?

UTF-8:UTF是“Unicode Transformation Format”的縮寫,可以翻譯成Unicode字符集轉換格式。UTF-8 就是在互聯網上使用最廣的一種Unicode的實現方式,其他實現方式還包括UTF-16(字符用兩個字節或四個字節表示)和UTF-32(字符用四個字節表示)。UTF-8最大的一個特點,就是它是一種變長的編碼方式。它可以使用1~6個字節表示一個符號,根據不同的符號而變化字節長度。對于某一個字符的UTF-8編碼,如果只有一個字節則其最高二進制位為0;如果是多字節,其第一個字節從最高位開始,連續的二進制位值為1的個數決定了其編碼的位數,其余各字節均以10開頭。

字節數 | UTF-8編碼(二進制)

1 | 0xxxxxxx

2 | 110xxxxx 10xxxxxx

3 | 1110xxxx 10xxxxxx 10xxxxxx

4 | 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx

5 | 111110xx 10xxxxxx 10xxxxxx 10xxxxxx 10xxxxxx

6 | 1111110x 10xxxxxx 10xxxxxx 10xxxxxx 10xxxxxx 10xxxxxx

很明顯對于“中”字使用UTF-8編碼需要使用三個字節,因此從“中”字的最后一個二進制位開始,依次從后向前填入格式中的x,多出的位補0。這樣就得到了“中”字的UTF-8編碼,結果為:11100100 10111000 10101101,即十六進制的E4B8AD。

二、Python3編碼

Python中的編碼問題困擾了我挺久的,尤其是Python2和Python3中還有區別,不過這里我只討論Python3中的編碼問題。

Python3最重要的新特性大概要算是對文本和二進制數據作了更為清晰的區分,文本總是Unicode,由str類型表示,二進制數據則由bytes類型表示,而兩者之間的轉換由編碼(encode)和解碼(decode)實現。這里可以看一下Python的官方文檔:

str.encode(encoding="utf-8", errors="strict") Return an encoded version of the string as a bytes object. Default encoding is 'utf-8'. errors may be given to set a different error handling scheme. The default for errors is 'strict', meaning that encoding errors raise a UnicodeError. Other possible values are 'ignore', 'replace', 'xmlcharrefreplace', 'backslashreplace' and any other name registered via codecs.register_error(), see section Error Handlers. For a list of possible encodings, see section Stardard Encodings. bytes.decode(encoding="utf-8", errors="strict") Return a string decoded from the given bytes. Default encoding is 'utf-8'. errors may be given to set a different error handling scheme. The default for errors is 'strict', meaning that encoding errors raise a UnicodeError. Other possible values are 'ignore', 'replace' and any other name registered via codecs.register_error(), see section Error Handlers. For a list of possible encodings, see section Stardard Encodings.

可以看到str是沒有decode方法的,因為本身就是Unicode編碼的,而bytes是沒有encode方法的,而且無論是encode還是decode默認都是使用UTF-8編碼的,當然我們還可以使用其他方式進行編碼和解碼,比如:

s = "博客園"

print(s.encode())

print(s.encode("utf-16"))

print(s.encode("gbk"))

# b'\xe5\x8d\x9a\xe5\xae\xa2\xe5\x9b\xad'

# b'\xff\xfeZS\xa2[\xedV'

# b'\xb2\xa9\xbf\xcd\xd4\xb0'那么對于某個數據來說,如果我們不知道它的編碼格式,要怎么辦呢?在Python3中可以使用chardet模塊里的detect方法查看:

import chardet

print(chardet.detect(b'\xe5\x8d\x9a\xe5\xae\xa2\xe5\x9b\xad'))

print(chardet.detect(b'\xff\xfeZS\xa2[\xedV'))

{'encoding': 'utf-8', 'confidence': 0.87625, 'language': ''}

{'encoding': 'UTF-16', 'confidence': 1.0, 'language': ''}detect方法會返回一個字典,包含編碼方式、檢測得到的概率和語言信息。可見,用chardet檢測編碼,使用簡單,獲取到編碼后,再轉換為str,就可以方便后續處理。

三、文本編碼

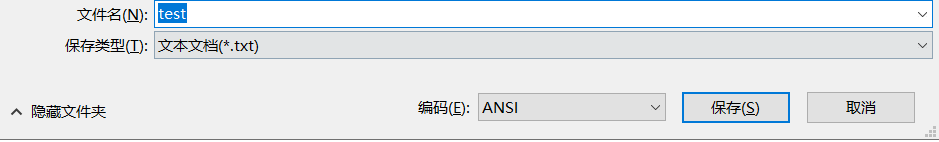

首先新建一個文本文檔“test.txt”,內容為:“博客園Blogs”,然后選擇“另存為”,可以看到默認使用的是ANSI編碼:

那么這個ANSI編碼是什么呢?不同的國家和地區制定了不同的標準,由此產生了GB2312、GBK、Big5、Shift_JIS等各自的編碼標準。這些使用1至4個字節來代表一個字符的各種漢字延伸編碼方式,稱為ANSI編碼。而在簡體中文Windows操作系統中,ANSI編碼就代表GBK編碼。那么假如我們使用了默認的ANSI編碼即GBK編碼,在讀取文本的時候會出現什么情況呢?

with open("test.txt", 'r') as f:

print(f.read())

# 博客園Blogs

with open("test.txt", 'r', encoding="gbk") as f:

print(f.read())

# 博客園Blogs

with open("test.txt", 'r', encoding="utf-8") as f:

print(f.read())

UnicodeDecodeError: 'utf-8' codec can't decode byte 0xb2 in position 0: invalid start byte可以看到使用UTF-8編碼打開的時候報錯了,原因是有無法解碼的字符。那么如果我們保存的時候使用UTF-8編碼呢?

with open("test.txt", 'r') as f:

print(f.read())

# 锘垮崥瀹㈠洯Blogs

with open("test.txt", 'r', encoding="gbk") as f:

print(f.read())

# 锘垮崥瀹㈠洯Blogs

with open("test.txt", 'r', encoding="utf-8") as f:

print(f.read())

# 博客園Blogs很明顯看到在使用GBK編碼時出現亂碼了,原因就是編碼和解碼的方式不一致,導致最終出現了亂碼的情況。

四、URL編碼

URL即全球統一資源定位符(Uniform Resource Locator),一般來說,URL只能使用英文字母、阿拉伯數字和某些標點符號,不能使用其他文字和符號,這是因為網絡標準RFC1738做出了規定。這意味著,如果URL中有漢字,就必須編碼后使用。但是麻煩的是,RFC1738沒有規定具體的編碼方法,而是交給應用程序(瀏覽器)自己決定。

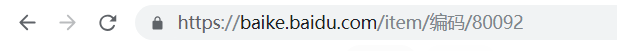

這里我們可以任意打開一個網頁,比如關于編碼的百度百科,可以看到瀏覽器顯示的鏈接沒有什么問題:

復制一下,然后粘貼出來看一下:https://baike.baidu.com/item/%E7%BC%96%E7%A0%81/80092,可以看到“編碼”兩個字被瀏覽器自動編碼成了“%E7%BC%96%E7%A0%81”。這里我們需要知道的是“編”的UTF-8編碼為:E7BC96,“碼”的UTF-8編碼為:E7A081,因此“%E7%BC%96%E7%A0%81”就是在每個字節前面加上一個“%”得到的,也就是說URL路徑使用的是UTF-8編碼。

關于Python的字符編碼匯總就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。