您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下Hadoop如何安裝,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

一、Hadoop的安裝

1. 下載地址:https://archive.apache.org/dist/hadoop/common/我下載的是hadoop-2.7.3.tar.gz版本。

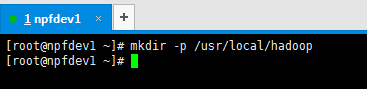

2. 在/usr/local/ 創建文件夾zookeeper

mkdir hadoop

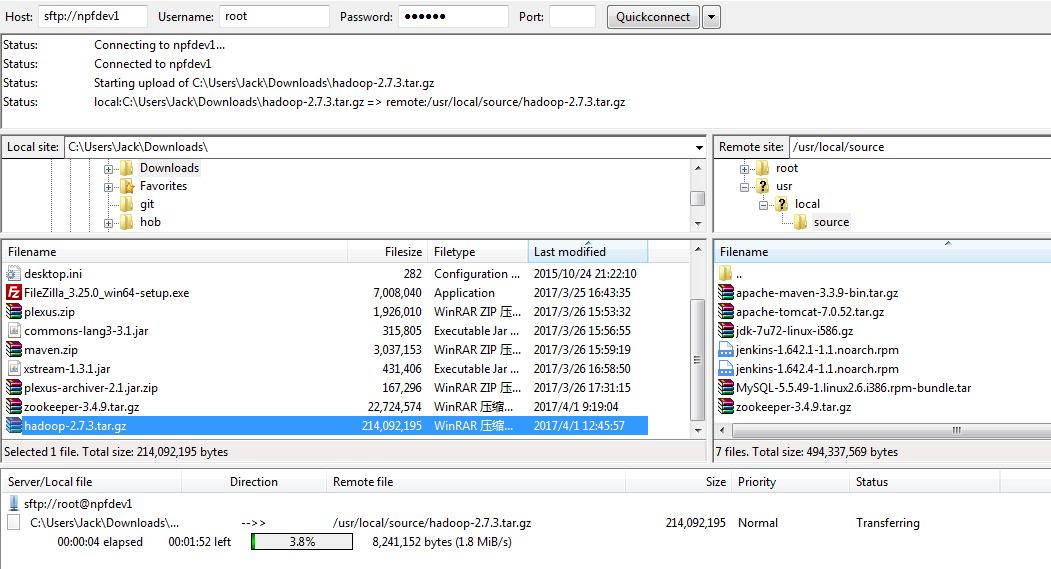

3.上傳文件到Linux上的/usr/local/source目錄下

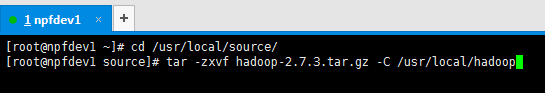

3.解壓縮

運行如下命令:

tar -zxvf hadoop-2.7.3.tar.gz-C /usr/local/hadoop

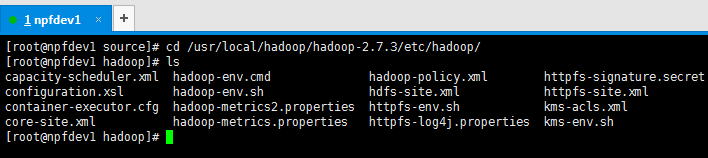

4. 修改配置文件

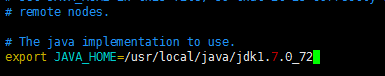

進入到cd /usr/local/hadoop/hadoop-2.7.3/etc/hadoop/ , 修改hadoop-env.sh

運行 vimhadoop-env.sh,修改JAVA_HOME

5.將Hadoop的執行命令加入到我們的環境變量里

在/etc/profile文件中加入:

export PATH=$PATH:/usr/local/hadoop/hadoop-2.7.3/bin:/usr/local/hadoop/hadoop-2.7.3/sbin

執行/etc/profile文件:

source /etc/profile

6. 將npfdev1機器上的hadoop復制到npfdev2和npfdev3和npfdev4機器上。使用下面的命令:

首先分別在npfdev2和npfdev3和npfdev4機器上,建立/usr/local/hadoop目錄,然后在npfdev1上分別執行下面命令:

scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev2:/usr/local/hadoop/

scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev3:/usr/local/hadoop/

scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev4:/usr/local/hadoop/

記住:需要各自修改npfdev2和npfdev3和npfdev4的/etc/profile文件:

在/etc/profile文件中加入:

export PATH=$PATH:/usr/local/hadoop/hadoop-2.7.3/bin:/usr/local/hadoop/hadoop-2.7.3/sbin

執行/etc/profile文件:

source /etc/profile

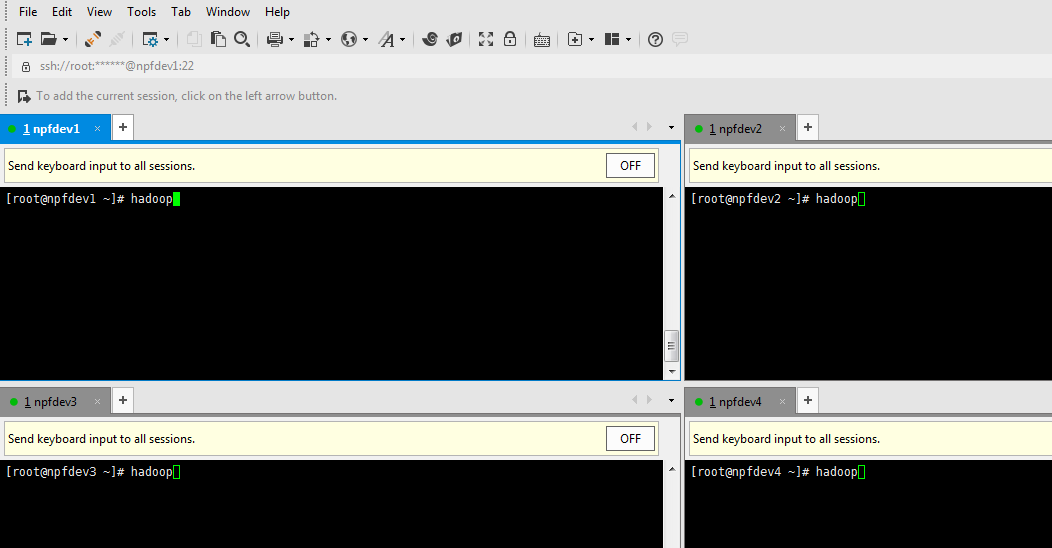

然后分別在npfdev1和npfdev2和npfdev3和npfdev4機器上,執行hadoop命令,看是否安裝成功。并且關閉防火墻。

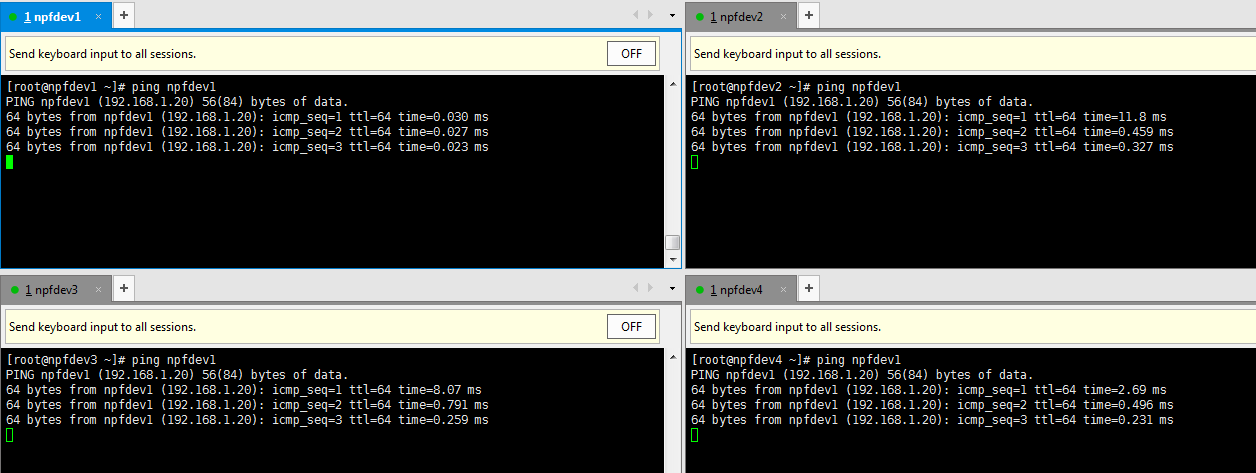

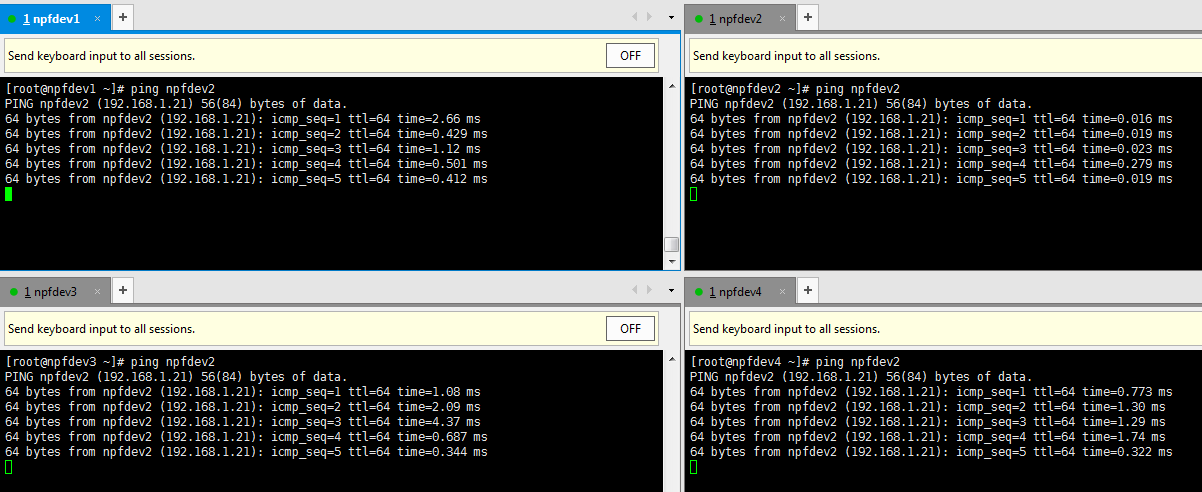

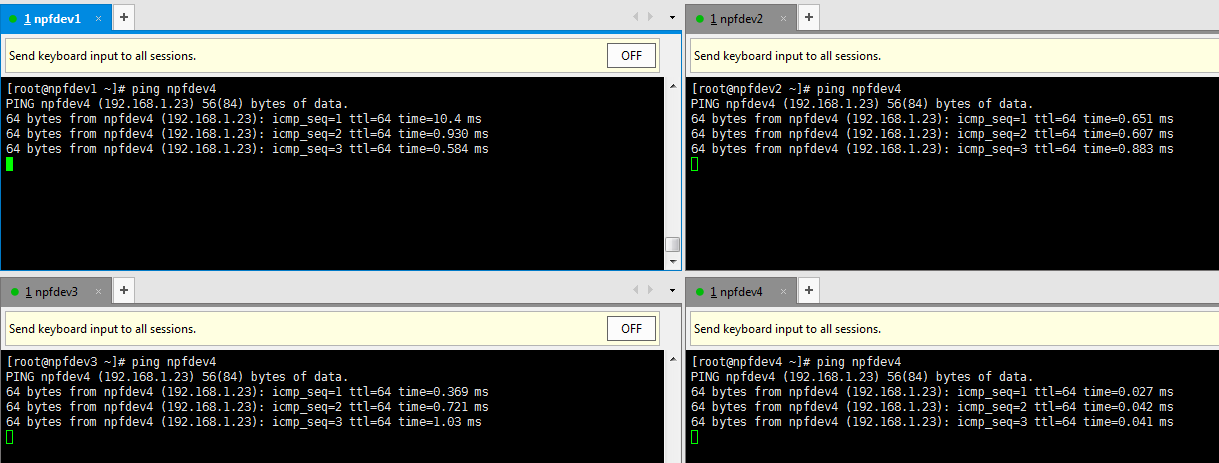

7. 確定所有機器之間可以相互ping通,使用下面的命令:

(1). ping npfdev1

(2). ping npfdev2

(3). ping npfdev3

(4). ping npfdev4

8. 啟動hadoop:

我們這里將npfdev1作為master,npfdev2和npfdev3和npfdev4分別作為三臺slave。

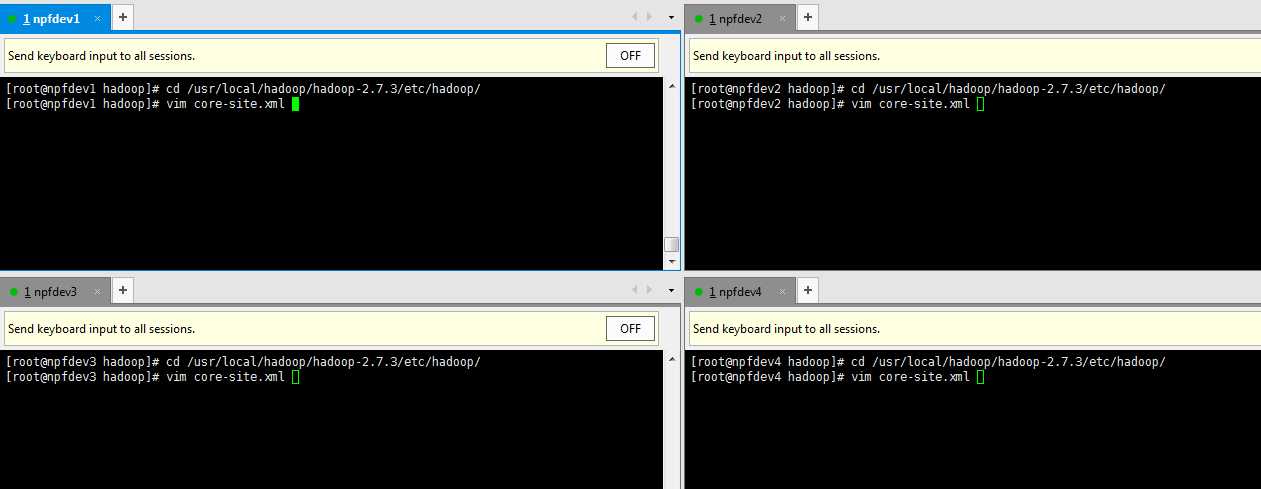

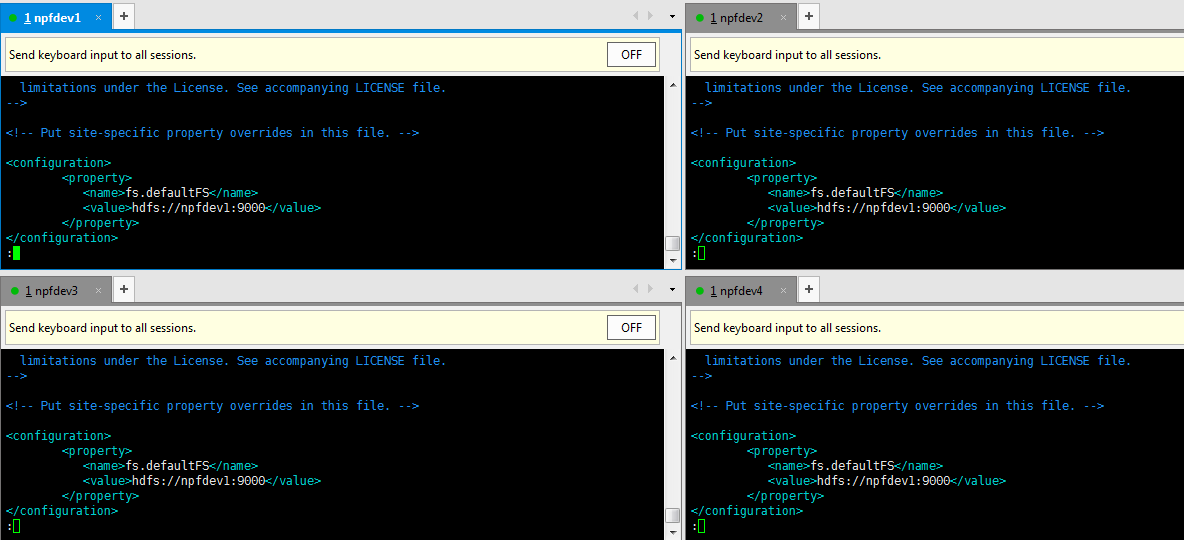

(1).修改配置文件core-site.xml

進入 cd /usr/local/hadoop/hadoop-2.7.3/etc/hadoop

具體配置如下:

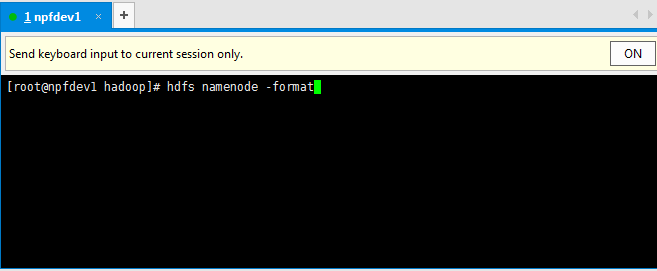

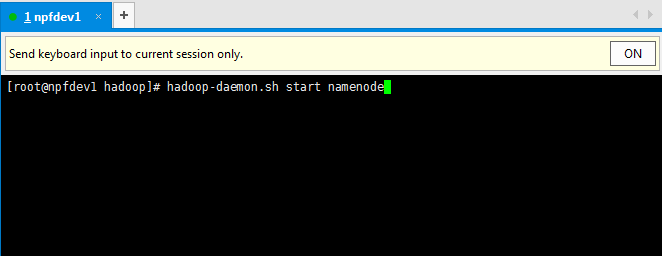

(2).在master機器npfdev1上啟動namenode

首先需要格式化namenode,第一次使用需要格式化,后來就不需要了。

hdfs namenode -format

然后啟動namenode:

hadoop-daemon.sh start namenode

通過jps命令查看,如果有namenode的java進程,就說明我們啟動namenode成功。

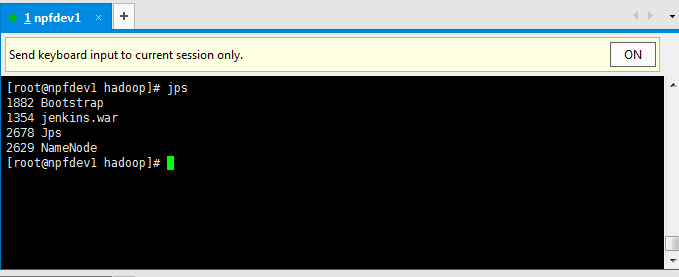

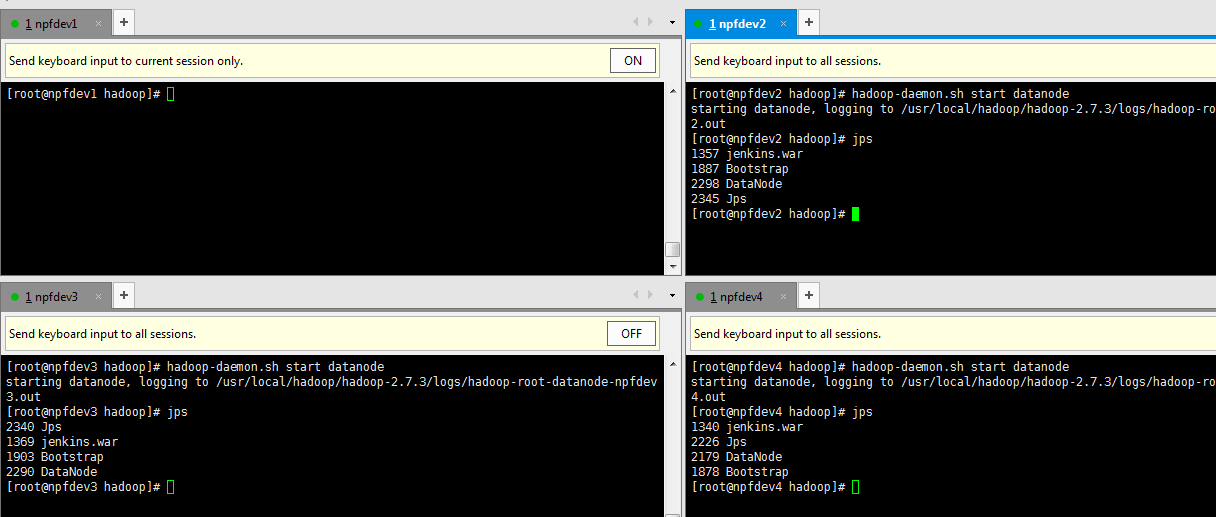

(3).在slave機器npfdev2,npfdev3,npfdev4上啟動datanode

以上是“Hadoop如何安裝”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。