您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

不久之前,亞馬遜剛剛推出了DeepLens 。這是一款專門面向開發人員的全球首個支持深度學習的攝像機,它所使用的機器學習算法不僅可以檢測物體活動和面部表情,而且還可以檢測類似彈吉他等復雜的活動。雖然DeepLens還未正式上市,但智能攝像機的概念已經誕生了。

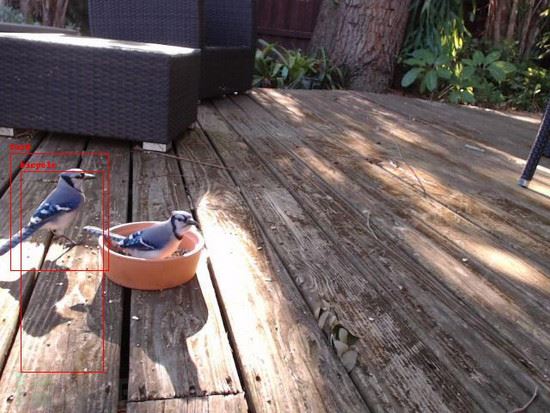

今天,我們將自己動手打造出一款基于深度學習的照相機,當小鳥出現在攝像頭畫面中時,它將能檢測到小鳥并自動進行拍照。最終成品所拍攝的畫面如下所示:

相機不傻,它可以很機智

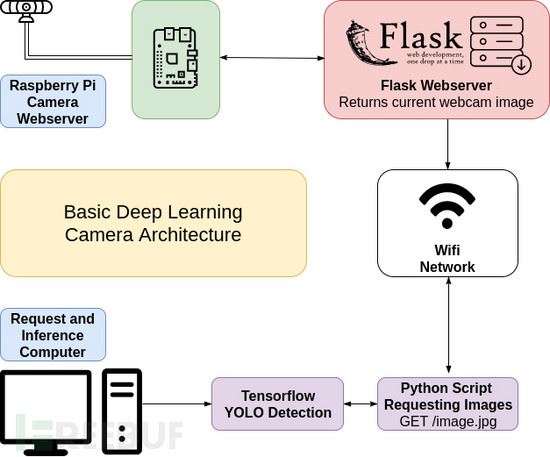

我們不打算將一個深度學習模塊整合到相機中,相反,我們準備將樹莓派“掛鉤”到攝像頭上,然后通過WiFi來發送照片。本著“一切從簡”(窮)為核心出發,我們今天只打算搞一個跟DeepLens類似的概念原型,感興趣的同學可以自己動手嘗試一下。

接下來,我們將使用Python編寫一個Web服務器,樹莓派將使用這個Web服務器來向計算機發送照片,或進行行為推斷和圖像檢測。

我們這里所使用的計算機其處理能力會更強,它會使用一種名叫 YOLO 的神經網絡架構來檢測輸入的圖像畫面,并判斷小鳥是否出現在了攝像頭畫面內。

我們得先從YOLO架構開始,因為它是目前速度最快的檢測模型之一。該模型專門給Tensorflow(谷歌基于DistBelief進行研發的第二代人工智能學習系統)留了一個接口,所以我們可以輕松地在不同的平臺上安裝和運行這個模型。友情提示,如果你使用的是我們本文所使用的迷你模型,你還可以用CPU來進行檢測,而不只是依賴于價格昂貴的GPU。

接下來回到我們的概念原型上… 如果像框內檢測到了小鳥,那我們就保存圖片并進行下一步分析。

檢測與拍照

正如我們所說的,DeepLens的拍照功能是整合在計算機里的,所以它可以直接使用板載計算能力來進行基準檢測,并確定圖像是否符合我們的標準。

但是像樹莓派這樣的東西,我們其實并不需要使用它的計算能力來進行實時計算。因此,我們準備使用另一臺計算機來推斷出現在圖像中的內容。

我使用的是一臺簡單的Linux計算機,它帶有一個攝像頭以及WiFi無線網卡( 樹莓派3 + 攝像頭 ),而這個簡單的設備將作為我的深度學習機器并進行圖像推斷。對我來說,這是目前最理想的解決方案了,這不僅大大縮減了我的成本,而且還可以讓我在臺式機上完成所有的計算。

當然了,如果你不想使用樹莓派視頻照相機的話,你也可以選擇在樹莓派上安裝OpenCV 3來作為方案B,具體的安裝方法請參考【這份文檔 】。友情提示,安裝過程可謂是非常的麻煩!

接下來,我們需要使用Flask來搭建Web服務器,這樣我們就可以從攝像頭那里獲取圖像了。這里我使用了 MiguelGrinberg 所開發的網絡攝像頭服務器代碼( Flask視頻流框架 ),并創建了一個簡單的jpg終端:

#!/usr/bin/envpython

from import lib import import_module

import os

from flask import Flask, render_template, Response

#uncomment below to use Raspberry Pi camera instead

#from camera_pi import Camera

#comment this out if you're not using USB webcam

from camera_opencv import Camera

app =Flask(__name__)

@app.route('/')

def index():

return "hello world!"

def gen2(camera):

"""Returns a single imageframe"""

frame = camera.get_frame()

yield frame

@app.route('/image.jpg')

def image():

"""Returns a single currentimage for the webcam"""

return Response(gen2(Camera()),mimetype='image/jpeg')

if __name__ == '__main__':

app.run(host='0.0.0.0', threaded=True)

如果你使用的是樹莓派視頻照相機,請確保沒有注釋掉上述代碼中from camera_pi那一行,然后注釋掉from camera_opencv那一行。

你可以直接使用命令python3 app.py或gunicorn來運行服務器,這跟Miguel在文檔中寫的方法是一樣的。如果我們使用了多臺計算機來進行圖像推斷的話,我們還可以利用Miguel所開發的攝像頭管理方案來管理攝像頭以及計算線程。

當我們啟動了樹莓派之后,首先需要根據IP地址來判斷服務器是否正常工作,然后嘗試通過Web瀏覽器來訪問服務器。

URL地址格式類似如下:

http://192.168.1.4:5000/image.jpg

在樹莓派中加載Web頁面及圖像來確定服務器是否正常工作:

圖像導入及推斷

既然我們已經設置好了終端來加載攝像頭當前的圖像內容,我們就可以構建一個腳本來捕捉圖像并推斷圖像中的內容了。

這里我們需要用到request庫(一個優秀的Python庫,用于從URL地址獲取文件資源)以及 Darkflow (YOLO模型基于Tensorflow的實現)。

不幸的是,我們沒辦法使用pip之類的方法來安裝 Darkflow ,所以我們需要克隆整個代碼庫,然后自己動手完成項目的構建和安裝。安裝好Darkflow項目之后,我們還需要下載一個YOLO模型。

因為我使用的是速度比較慢的計算機和板載CPU(而不是速度較快的GPU),所以我選擇使用YOLO v2迷你網絡。當然了,它的功能肯定沒有完整的YOLO v2模型的推斷準確性高啦!

配置完成之后,我們還需要在計算機中安裝Pillow、numpy和OpenCV。最后,我們就可以徹底完成我們的代碼,并進行圖像檢測了。

最終的代碼如下所示:

from darkflow.net.build import TFNet

import cv2

from io import BytesIO

import time

import requests

from PIL import Image

import numpy as np

options= {"model": "cfg/tiny-yolo-voc.cfg", "load":"bin/tiny-yolo-voc.weights", "threshold": 0.1}

tfnet= TFNet(options)

birdsSeen= 0

def handleBird():

pass

whileTrue:

r =requests.get('http://192.168.1.11:5000/image.jpg') # a bird yo

curr_img = Image.open(BytesIO(r.content))

curr_img_cv2 =cv2.cvtColor(np.array(curr_img), cv2.COLOR_RGB2BGR)

result = tfnet.return_predict(curr_img_cv2)

print(result)

for detection in result:

if detection['label'] == 'bird':

print("bird detected")

birdsSeen += 1

curr_img.save('birds/%i.jpg' %birdsSeen)

print('running again')

time.sleep(4)

此時,我們不僅可以在命令控制臺中查看到樹莓派所檢測到的內容,而且我們還可以直接在硬盤中查看保存下來的小鳥照片。接下來,我們就可以使用YOLO來標記圖片中的小鳥了。

假陽性跟假陰性之間的平衡

我們在代碼的options字典中設置了一個threshold鍵,這個閾值代表的是我們用于檢測圖像的某種成功率。在測試過程中,我們將其設為了0.1,但是如此低的閾值會給我們帶來是更高的假陽性以及誤報率。更糟的是,我們所使用的迷你YOLO模型準確率跟完整的YOLO模型相比,差得太多了,但這也是需要考慮的一個平衡因素。

降低閾值意味著我們可以得到更多的模型輸出(照片),在我的測試環境中,我閾值設置的比較低,因為我想得到更多的小鳥照片,不過大家可以根據自己的需要來調整閾值參數。

代碼開源

跟之前一樣,我已經將所有的代碼上傳到GitHub上了,感興趣的同學可以自行下載安裝【 GitHub傳送門 】。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。