溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

小編給大家分享一下Python3怎么實現爬蟲爬取趕集網列表功能,希望大家閱讀完這篇文章之后都有所收獲,下面讓我們一起去探討吧!

Python主要應用于:1、Web開發;2、數據科學研究;3、網絡爬蟲;4、嵌入式應用開發;5、游戲開發;6、桌面應用開發。

具體如下:

python3爬蟲之爬取趕集網列表。這幾天一直在學習使用python3爬取數據,今天記錄一下,代碼很簡單很容易上手。

首先需要安裝python3。如果還沒有安裝,可參考本站前面關于python3安裝與配置相關文章。

首先需要安裝request和BeautifulSoup兩個模塊

request是Python的HTTP網絡請求模塊,使用Requests可以輕而易舉的完成瀏覽器可有的任何操作

pip install requests

BeautifulSoup是用Python寫的一個HTML/XML的解析器,它可以很好的處理不規范標記并生成剖析樹

pip install beautifulsoup4

代碼:

from urllib import request

from bs4 import BeautifulSoup

#構造頭文件,模擬瀏覽器訪問

url="http://xa.ganji.com/meirdjm/o2/"

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36'}

page = request.Request(url,headers=headers)

# 發送請求,獲取內容

page_info = request.urlopen(page).read().decode('utf-8')

# 將獲取到的內容轉換成BeautifulSoup格式,并將html.parser作為解析器

soup = BeautifulSoup(page_info, 'html.parser')

# 查找所有a標簽中class='list-info-title'

titles = soup.find_all('a',class_="list-info-title")

# 打印抓取到的title

for title in titles:

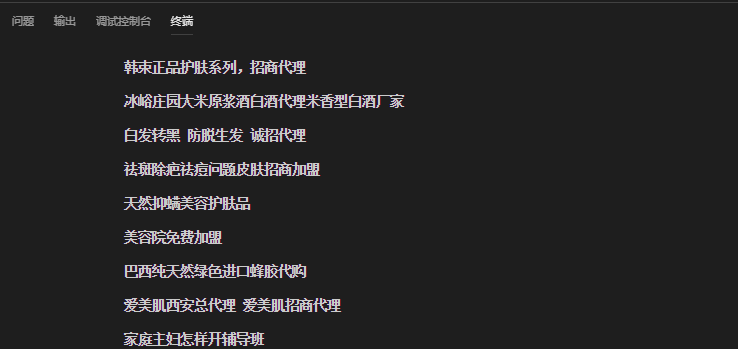

print(title.string)結果:

看完了這篇文章,相信你對“Python3怎么實現爬蟲爬取趕集網列表功能”有了一定的了解,如果想了解更多相關知識,歡迎關注億速云行業資訊頻道,感謝各位的閱讀!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。